机器学习笔记:范数正则化与L0、L1、L2在模型复杂度控制中的应用

需积分: 0 38 浏览量

更新于2024-08-04

收藏 505KB PDF 举报

本文主要探讨了机器学习中的正则化技术,特别是L0、L1和L2范数在回归模型中的应用,如岭回归和Lasso回归,以解决过拟合问题并实现特征选择。

在监督学习中,正则化是一种重要的技术,其目的是在最小化预测误差的同时,限制模型的复杂度,防止过拟合。当模型参数过多时,模型可能会对训练数据过度适应,导致在未见过的数据上表现不佳。正则化通过引入规则化项(或惩罚项)来约束模型参数,从而降低模型复杂度,同时也可以根据需求强制模型具备特定特性,如稀疏性。

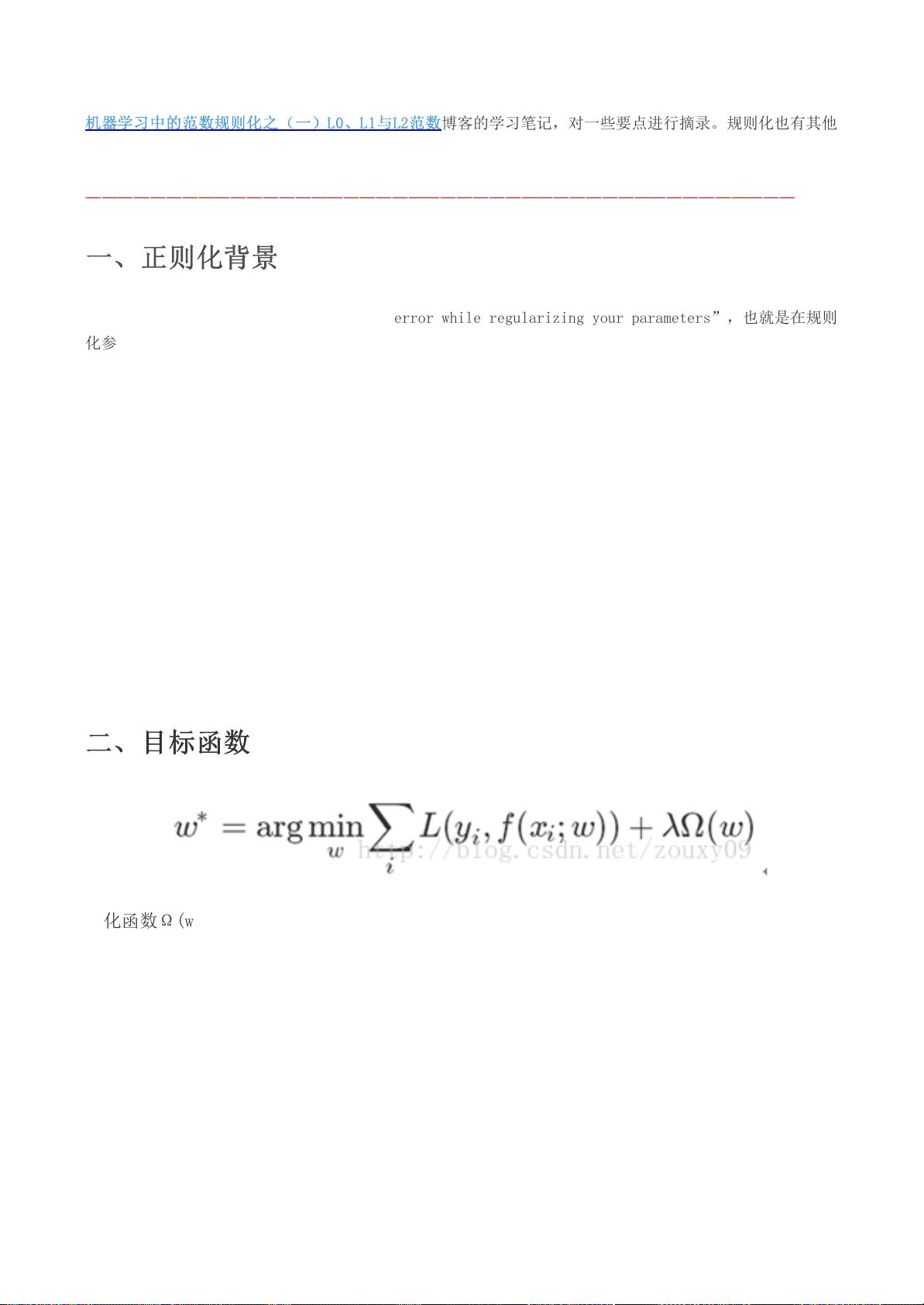

目标函数通常包含两部分:损失函数(Loss Function)和规则化项(Regularization Term)。损失函数衡量模型预测结果与实际值之间的差距,如平方误差、对数损失、间隔损失等,不同损失函数对应不同的学习任务。规则化项则是对模型参数的约束,常见的是参数向量的范数。

1. L0范数:虽然不是严格的数学范数,但L0范数代表非零参数的数量,它鼓励稀疏解,即尽可能多的参数为0。在L0范数正则化的模型中,特征选择变得直观,能实现特征的重要性判断。

2. L1范数:L1范数是参数向量的绝对值之和,它也倾向于产生稀疏解,因为当参数值接近0时,L1范数的梯度会趋向于无穷大,促使参数值归零。L1正则化常用于Lasso回归,能自动执行特征选择。

3. L2范数:L2范数是参数向量的平方和的平方根,它使得所有参数都尽可能小,但不趋向于0。L2正则化常用于岭回归,它可以防止模型过拟合,但不会产生稀疏解。

每种范数都有其适用场景。L0范数在特征选择中尤为有用,但优化计算困难;L1范数在特征压缩和特征选择上有优势,适合大数据集;L2范数则在保持模型稳定性和泛化能力方面表现出色。实际应用中,还会结合使用Elastic Net,它是L1和L2范数的组合,兼顾稀疏性和模型稳定。

正则化是机器学习中控制模型复杂度和防止过拟合的关键手段,不同的范数选择会直接影响模型的性能和特性。在实践中,应根据数据特点和任务需求,合理选择合适的正则化方法。

681 浏览量

1699 浏览量

2021-05-12 上传

250 浏览量

320 浏览量

421 浏览量

1000 浏览量

485 浏览量

点击了解资源详情

无声远望

- 粉丝: 1597

最新资源

- MFC绘图功能封装成DLL库的实现方法

- Ruby库实现特斯拉远程控制API文档

- Python代码实现详解与实践

- 深入理解C++Builder帮助文档——BCB6.HLP要点解析

- C#贪吃蛇游戏简易教程

- 电子商务平台Selenium自动化测试实战指南

- React开发Chrome扩展入门工具包:实现实时重新加载

- 西安Java招聘求职模板,后台管理系统界面设计

- C语言实现成绩分布图的顺序展示教程

- 全面掌握网站建设技术的W3C School离线教程

- VBA编程实例教程详解:方法与技巧

- Vagaa 2.6.6.7老版本发布,避免自动更新下载指南

- FirePHP扩展:在浏览器开发者工具中调试PHP

- Python编程练习示例解析

- 图片批量命名工具:高效统一文件命名解决方案

- Bink+Video+Player:Bik格式的视频播放解决方案