强化学习:时间差分预测法提升免模型任务效率

需积分: 0 89 浏览量

更新于2024-08-05

收藏 549KB PDF 举报

时间差分预测1深入探讨了强化学习中的一个重要概念,即时间差分(Temporal-Difference,TD)方法。在强化学习中,传统的动态规划(Dynamic Programming, DP)和蒙特卡洛(Monte Carlo, MC)方法各有优劣。动态规划适用于基于模型的任务,它依赖于环境的完整知识,而蒙特卡洛法则适合处理免模型问题,但其数据方差大、收敛速度慢,限制了在实际环境中的应用。

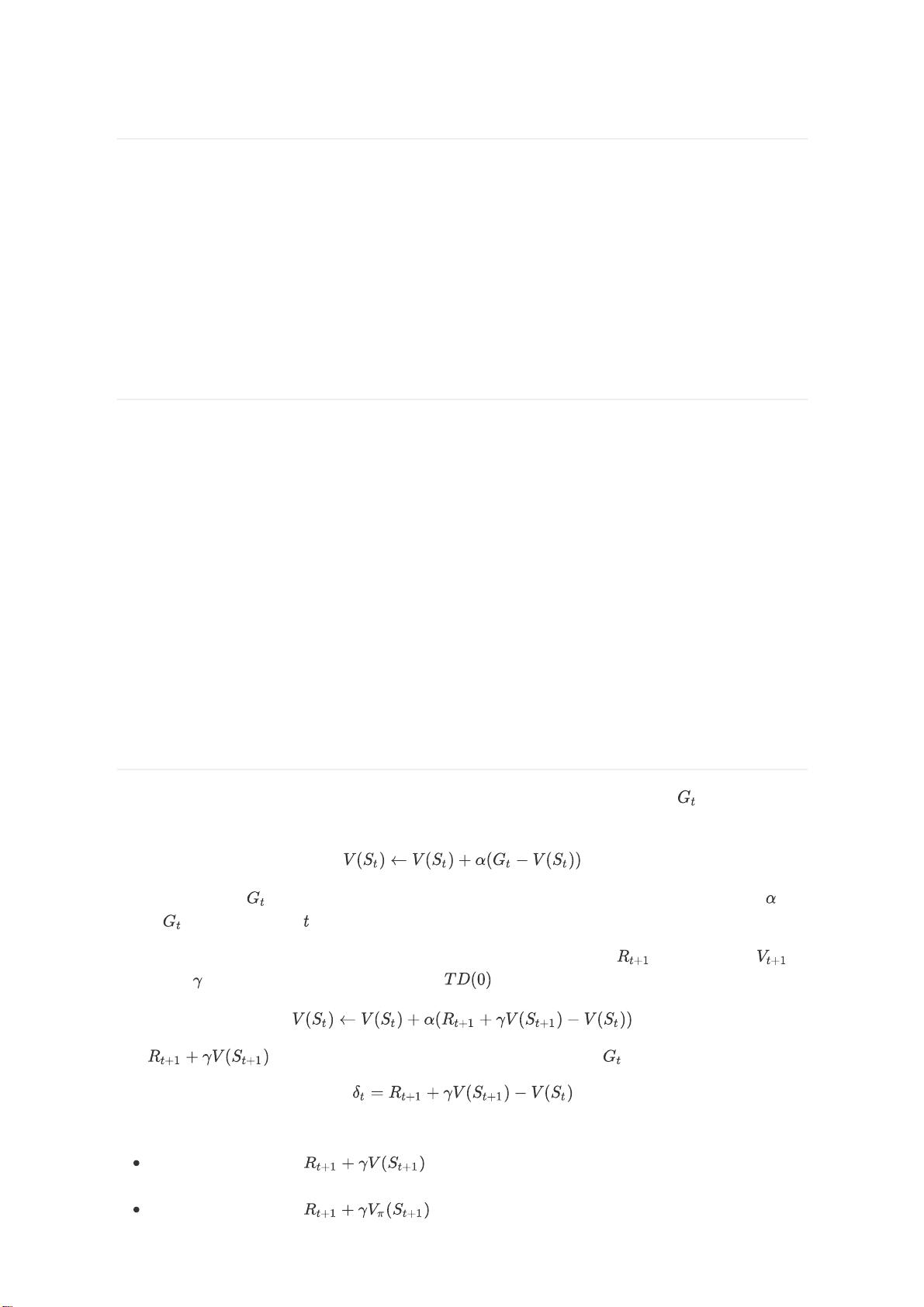

时间差分法的出现解决了这一难题。它借鉴了动态规划的 Bootstrapping(自举)思想,即在计算当前状态的价值时,不仅考虑当前的奖励,还利用后续可能的状态或动作价值。这使得TD方法可以在没有完整环境模型的情况下,通过序列数据的实时更新来逼近最优策略,提高了学习效率。相比于MC的延迟反馈,TD方法在每个时间步都能进行价值函数的增量更新,这在免模型强化学习中具有显著优势。

TD预测原理的核心在于其“预测”的机制,即利用智能体在环境中的经验,通过时间差来估计未来奖励的期望值。它通过对多次采样后经验轨迹的累积奖励进行在线调整,而非等到所有采样结束后再做平均。这种即时反馈的方式减少了数据方差,加快了学习速度,使得TD方法能够在复杂且未知的环境中更有效地求解强化学习问题。

总结来说,时间差分预测是强化学习中的一个重要分支,它结合了动态规划和蒙特卡洛的优点,通过实时估计和更新价值函数,尤其适合处理免模型的强化学习任务。这种方法的引入显著提升了强化学习算法在实际环境中的适应性和效率,是现代强化学习研究中的关键技术之一。

2023-10-08 上传

2022-08-03 上传

2023-09-22 上传

2024-07-22 上传

2024-02-09 上传

2023-03-28 上传

2023-03-28 上传

2021-03-24 上传

Friday永不为奴

- 粉丝: 20

- 资源: 317

最新资源

- 掌握压缩文件管理:2工作.zip文件使用指南

- 易语言动态版置入代码技术解析

- C语言编程实现电脑系统测试工具开发

- Wireshark 64位:全面网络协议分析器,支持Unix和Windows

- QtSingleApplication: 确保单一实例运行的高效库

- 深入了解Go语言的解析器组合器PARC

- Apycula包安装与使用指南

- AkerAutoSetup安装包使用指南

- Arduino Due实现VR耳机的设计与编程

- DependencySwizzler: Xamarin iOS 库实现故事板 UIViewControllers 依赖注入

- Apycula包发布说明与下载指南

- 创建可拖动交互式图表界面的ampersand-touch-charts

- CMake项目入门:创建简单的C++项目

- AksharaJaana-*.*.*.*安装包说明与下载

- Arduino天气时钟项目:源代码及DHT22库文件解析

- MediaPlayer_server:控制媒体播放器的高级服务器