ReSprop: 稀疏反向传播加速CNN训练,保持高精度

83 浏览量

更新于2024-06-20

收藏 698KB PDF 举报

标题"ReSprop:重用稀疏反向传播对CNN训练加速、准确度损失较小的研究"聚焦于提升卷积神经网络(CNN)的训练效率和精度。传统的CNN训练过程中,大量的计算集中在梯度更新上,而研究发现大约90%的梯度在整个训练期间是重复的。这一发现启发了ReSprop算法的设计,该算法利用这一观察,通过重用稀疏梯度来减少反向传播计算。

ReSprop的核心思想是通过细粒度的稀疏性来降低计算密集度,这种方法类似于Resprop(Resource Propagation)引入的计算减少策略。它能够在保持高精度的同时,将CIFAR-10、CIFAR-100和ImageNet等数据集上的精度损失控制在1.1%以内,显著地降低了反向传播计算的需求,从而实现了10倍的计算减少。这种加速效应使得整体训练时间缩短了2.7倍。

为了进一步优化稀疏计算,研究人员开发了一个通用的稀疏卷积神经网络加速器(GSCN),它专为稀疏卷积神经网络设计,能够与ReSprop紧密结合。在与GSCN结合时,例如在ResNet34和VGG16模型上,GTX1080Ti GPU的反向传播速度可以提升至原来的8.0倍,这意味着更高效的计算处理能力。

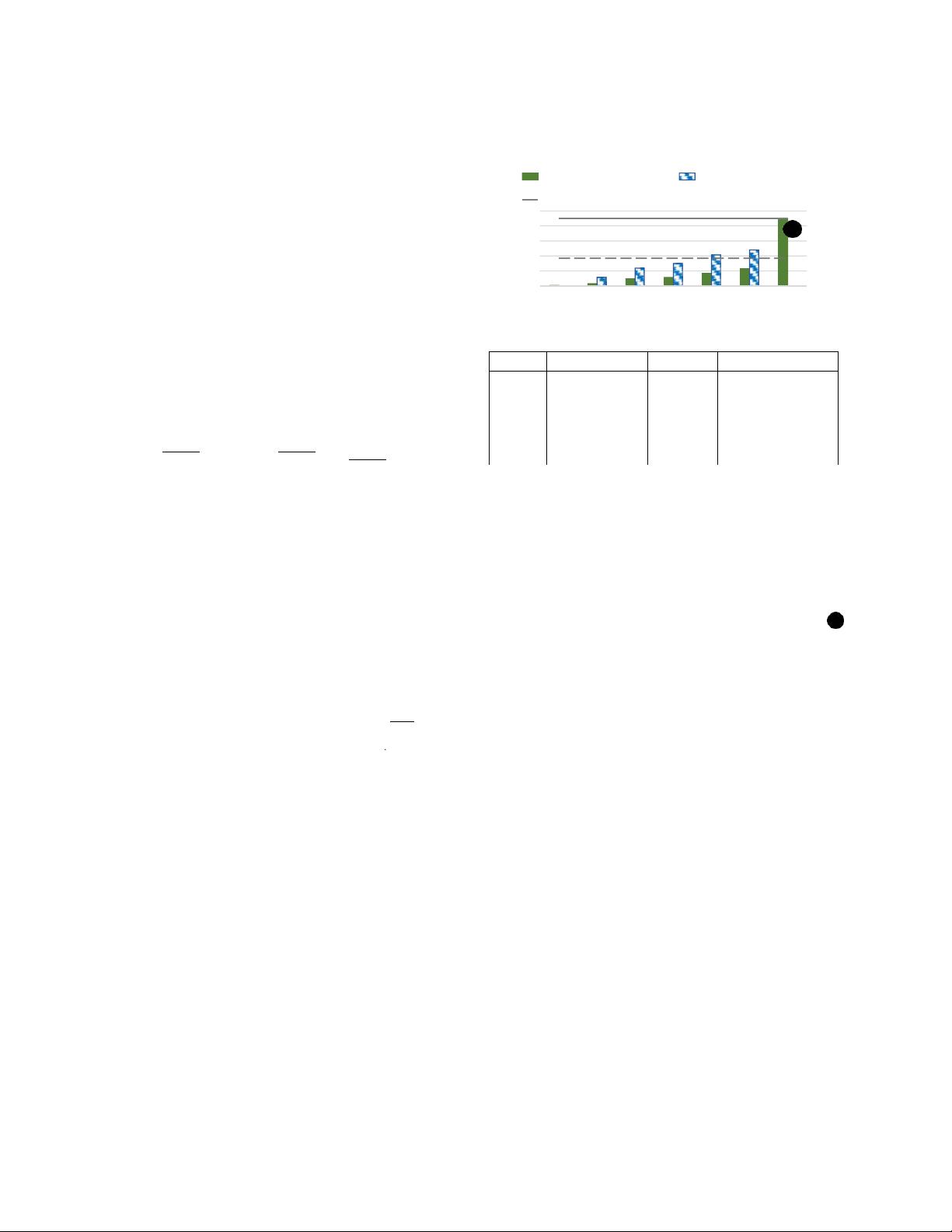

这项研究不仅关注于性能提升,还兼顾了模型的精度,表明在追求效率的同时,并没有牺牲太多模型的准确性。通过对比不同体系结构的实验结果,如图1所示,向后传播(Backward Propagation)的效率得到了明显改善,特别是在ResNet18、ResNet34、ResNet50、WRN-50-2、VGG16和VGG19等模型上,验证了ReSprop的实用性和有效性。

总结来说,ReSprop是一种创新的算法,它通过重用稀疏梯度和稀疏计算策略,实现了CNN训练的高效和精准。这种技术有望在未来推动深度学习模型的训练过程,提高计算效率,减少资源消耗,为实际应用中的大规模神经网络训练带来重大进步。

2022-08-08 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- CoreOS部署神器:configdrive_creator脚本详解

- 探索CCR-Studio.github.io: JavaScript的前沿实践平台

- RapidMatter:Web企业架构设计即服务应用平台

- 电影数据整合:ETL过程与数据库加载实现

- R语言文本分析工作坊资源库详细介绍

- QML小程序实现风车旋转动画教程

- Magento小部件字段验证扩展功能实现

- Flutter入门项目:my_stock应用程序开发指南

- React项目引导:快速构建、测试与部署

- 利用物联网智能技术提升设备安全

- 软件工程师校招笔试题-编程面试大学完整学习计划

- Node.js跨平台JavaScript运行时环境介绍

- 使用护照js和Google Outh的身份验证器教程

- PHP基础教程:掌握PHP编程语言

- Wheel:Vim/Neovim高效缓冲区管理与导航插件

- 在英特尔NUC5i5RYK上安装并优化Kodi运行环境