Hadoop源代码深度解析:从HDFS到MapReduce

需积分: 9 173 浏览量

更新于2024-07-20

收藏 5.91MB DOC 举报

"Hadoop源代码分析"

Hadoop是开源的分布式计算框架,它借鉴了Google的几个关键核心技术,包括分布式文件系统(GFS)、分布式锁服务(Chubby)、大规模数据存储系统(BigTable)和并行计算模型MapReduce。在Hadoop中,这些对应为HDFS、ZooKeeper、HBase和Hadoop MapReduce。

Hadoop分布式文件系统(HDFS)是Hadoop项目的基础,它为大数据处理提供了可靠的、可扩展的数据存储。HDFS的设计目标是处理PB级别的数据,支持高吞吐量的数据访问,并且具有容错机制。HDFS通过数据复制来确保数据的可用性,通常将数据块复制成三份,存储在不同的节点上,以防止节点故障。

MapReduce是Hadoop的计算模型,它将大规模数据处理任务分解为两个阶段:Map阶段和Reduce阶段。Map阶段将输入数据分割并映射到多个独立的任务,然后在各个节点上并行处理;Reduce阶段将Map的结果聚合,生成最终的输出。这种模型非常适合批处理和数据分析任务。

ZooKeeper在Hadoop生态系统中扮演了分布式协调服务的角色,类似于Google的Chubby。它为分布式应用提供了命名服务、配置管理、集群同步等基础服务,确保分布式环境中的节点间能够高效、一致地通信。

HBase是基于HDFS的分布式NoSQL数据库,模仿了BigTable的结构化数据存储。它提供了随机读写和高并发访问能力,适合处理大规模的实时数据。

Hadoop的包结构复杂,因为其需要处理分布式环境下的各种情况,例如,Hadoop的配置管理包(conf)依赖于文件系统包(fs),而fs包又可能包含对分布式文件系统或本地文件系统的抽象。

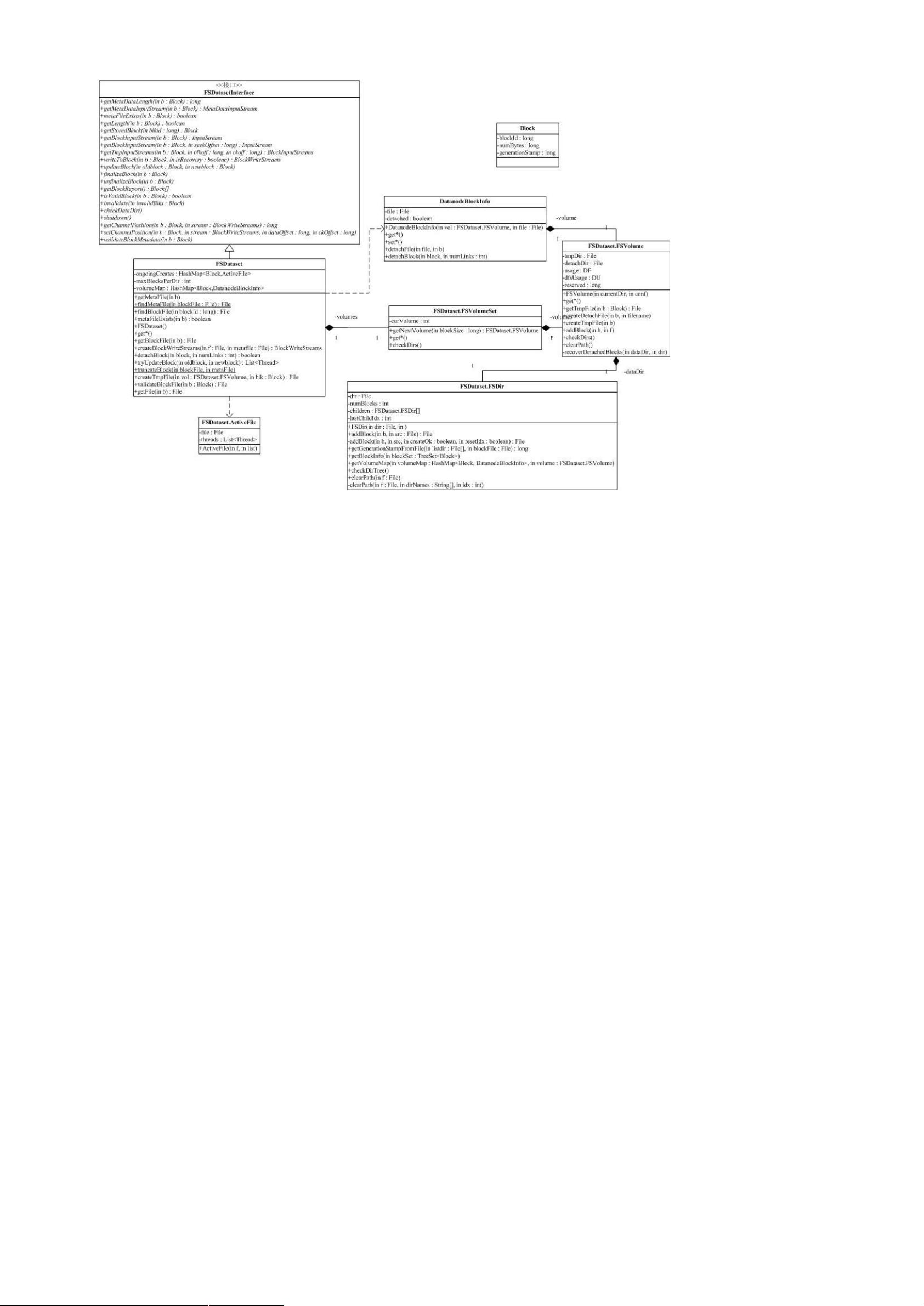

在Hadoop源代码分析中,重点关注的是蓝色部分的关键组件,这是理解Hadoop工作原理的核心。包的功能分析可以帮助我们深入理解每个包的作用以及它们之间的依赖关系。

通过深入分析Hadoop的源代码,开发者和研究人员可以更好地理解和优化Hadoop的性能,解决潜在的问题,以及开发新的工具和服务。这不仅有助于提升现有Hadoop集群的效率,也为构建更复杂的分布式应用程序提供了坚实的基础。对于学习分布式计算、大数据处理和云基础设施的人来说,Hadoop源代码分析是一项有价值的研究任务。

2011-11-07 上传

2021-03-13 上传

2012-01-05 上传

2013-10-23 上传

2022-06-18 上传

qq_34138104

- 粉丝: 0

- 资源: 1

最新资源

- C++ Qt影院票务系统源码发布,代码稳定,高分毕业设计首选

- 纯CSS3实现逼真火焰手提灯动画效果

- Java编程基础课后练习答案解析

- typescript-atomizer: Atom 插件实现 TypeScript 语言与工具支持

- 51单片机项目源码分享:课程设计与毕设实践

- Qt画图程序实战:多文档与单文档示例解析

- 全屏H5圆圈缩放矩阵动画背景特效实现

- C#实现的手机触摸板服务端应用

- 数据结构与算法学习资源压缩包介绍

- stream-notifier: 简化Node.js流错误与成功通知方案

- 网页表格选择导出Excel的jQuery实例教程

- Prj19购物车系统项目压缩包解析

- 数据结构与算法学习实践指南

- Qt5实现A*寻路算法:结合C++和GUI

- terser-brunch:现代JavaScript文件压缩工具

- 掌握Power BI导出明细数据的操作指南