深度学习PyTorch实战:循环神经网络解析与实现

"本文主要介绍了循环神经网络(RNN)及其两种变体——门控循环单元(GRU)和长短期记忆网络(LSTM),在处理时间序列数据时的优势。文章通过实例展示了如何使用PyTorch实现这些模型,并涵盖了数据加载、参数初始化、模型构建和训练的过程。"

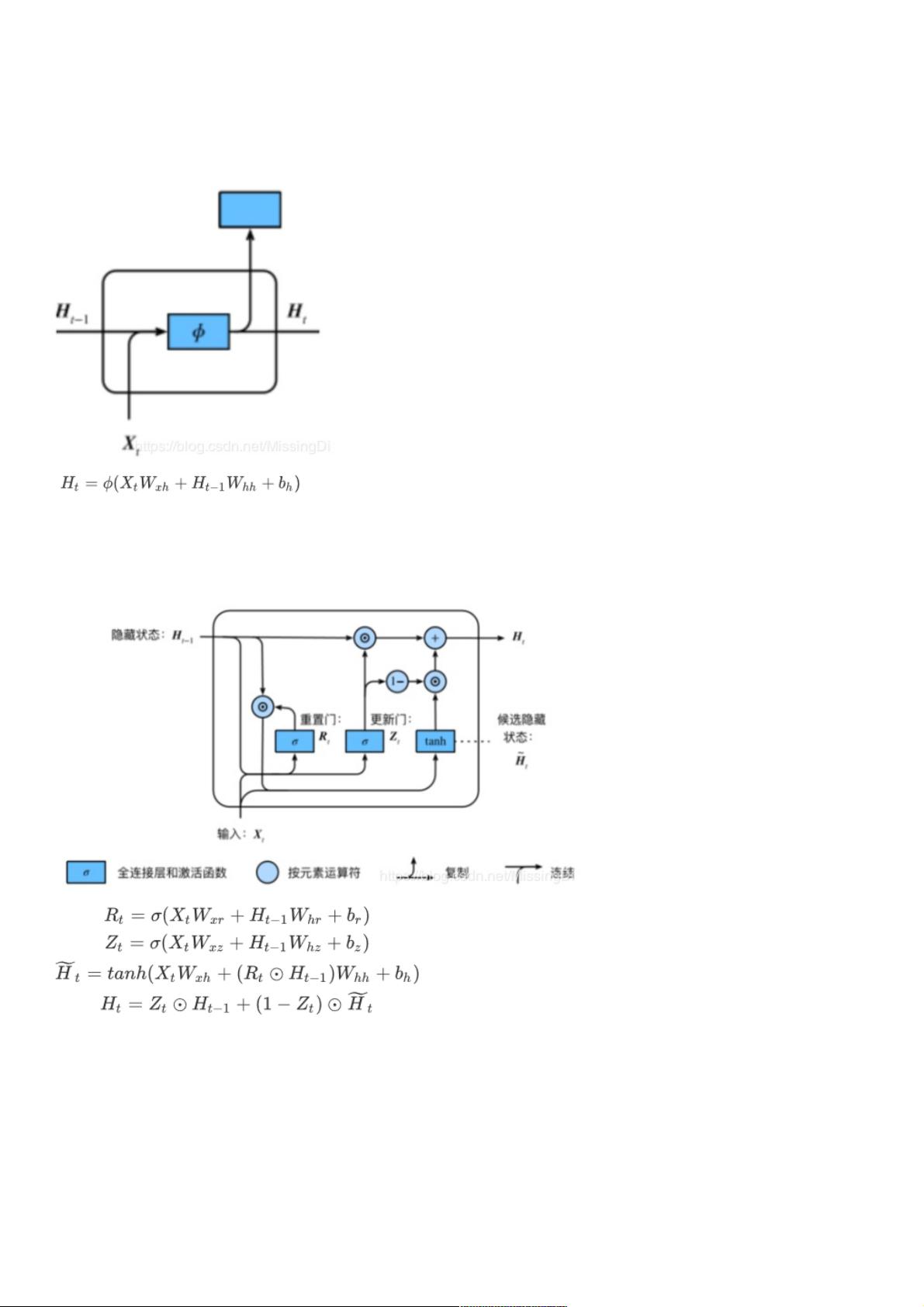

在深度学习领域,循环神经网络(RNN)是一种适用于处理序列数据的神经网络架构,尤其在自然语言处理和语音识别等领域有着广泛的应用。传统的RNN在处理长序列时面临梯度消失或爆炸的问题,这限制了它们学习长期依赖的能力。为了解决这个问题,研究者提出了GRU(Gated Recurrent Unit)和LSTM(Long Short-Term Memory)。

GRU是RNN的一种改进版本,引入了重置门和更新门的概念。重置门有助于模型捕获时间序列中的短期依赖,而更新门则有助于捕捉长期依赖。这样,GRU可以在不牺牲太多计算效率的情况下,有效地缓解梯度消失或爆炸的问题。在实现上,GRU的步骤包括数据加载、参数初始化、构建GRU模型和训练模型。

数据加载部分通常涉及读取和预处理数据,例如在本例中使用`os.listdir`来检查数据目录,并通过`d2l.load_data_jay_lyrics`导入一个歌词数据集。数据集会被转化为适合RNN处理的形式,如词序编码。

在参数初始化阶段,定义了输入维度、隐藏层维度和输出维度,然后使用随机初始化权重的函数`get_params`创建模型所需的参数,如权重矩阵和偏置向量。这些参数将被用于计算每个时间步的隐藏状态。

模型构建阶段,GRU的结构由输入到隐藏层的转换、隐藏层到隐藏层的转换以及重置门和更新门的控制组成。训练模型则涉及定义损失函数(如交叉熵损失)、优化器(如Adam),并迭代地应用前向传播和反向传播来更新模型参数。

LSTM是另一种解决RNN长期依赖问题的方法,它引入了输入门、遗忘门和输出门,更精细地控制信息的流动。LSTM的实现步骤与GRU类似,但其内部结构更为复杂,包括更多的门控机制来更好地管理记忆单元的状态。

这篇文章通过PyTorch的实例深入浅出地介绍了RNN、GRU和LSTM的工作原理及实现细节,对于想要学习和应用这些模型的初学者来说是一份宝贵的教程。

2021-01-06 上传

2022-09-12 上传

2021-01-07 上传

2021-10-03 上传

103 浏览量

2021-01-07 上传

2024-05-08 上传

weixin_38644688

- 粉丝: 9

- 资源: 932

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载