SparkStreaming:故障恢复与优势剖析的流处理架构

15 浏览量

更新于2024-09-01

收藏 320KB PDF 举报

SparkStreaming是Apache Spark生态系统中的关键组件,它专为大规模实时数据流处理而设计,为批处理和流处理提供了统一的编程模型。相比于市场上其他流处理引擎,Spark Streaming的独特优势在于其原生支持这两种处理模式,而非仅仅专注于单一方面。

Spark Streaming的执行模型基于微批处理的概念,它将数据流划分成一系列短小的时间窗口,每个窗口内的数据通过批处理的方式进行计算,这样可以利用Spark强大的批处理能力来处理实时数据。这种设计使得Spark Streaming能够在故障恢复和处理慢节点(stragglers)时保持高效,因为它能够快速重试失败的任务或者调整任务分配,以保证整个处理流程的顺畅。

在架构方面,Spark Streaming主要包括以下几个组成部分:

1. 数据源:接收实时数据的源头,如日志、遥测数据或物联网设备数据,常常通过Kafka、Amazon Kinesis等消息队列系统接入。

2. 数据处理:在集群上并行化处理这些数据,Spark Streaming通过并行化任务调度和故障恢复机制,确保高可用性。

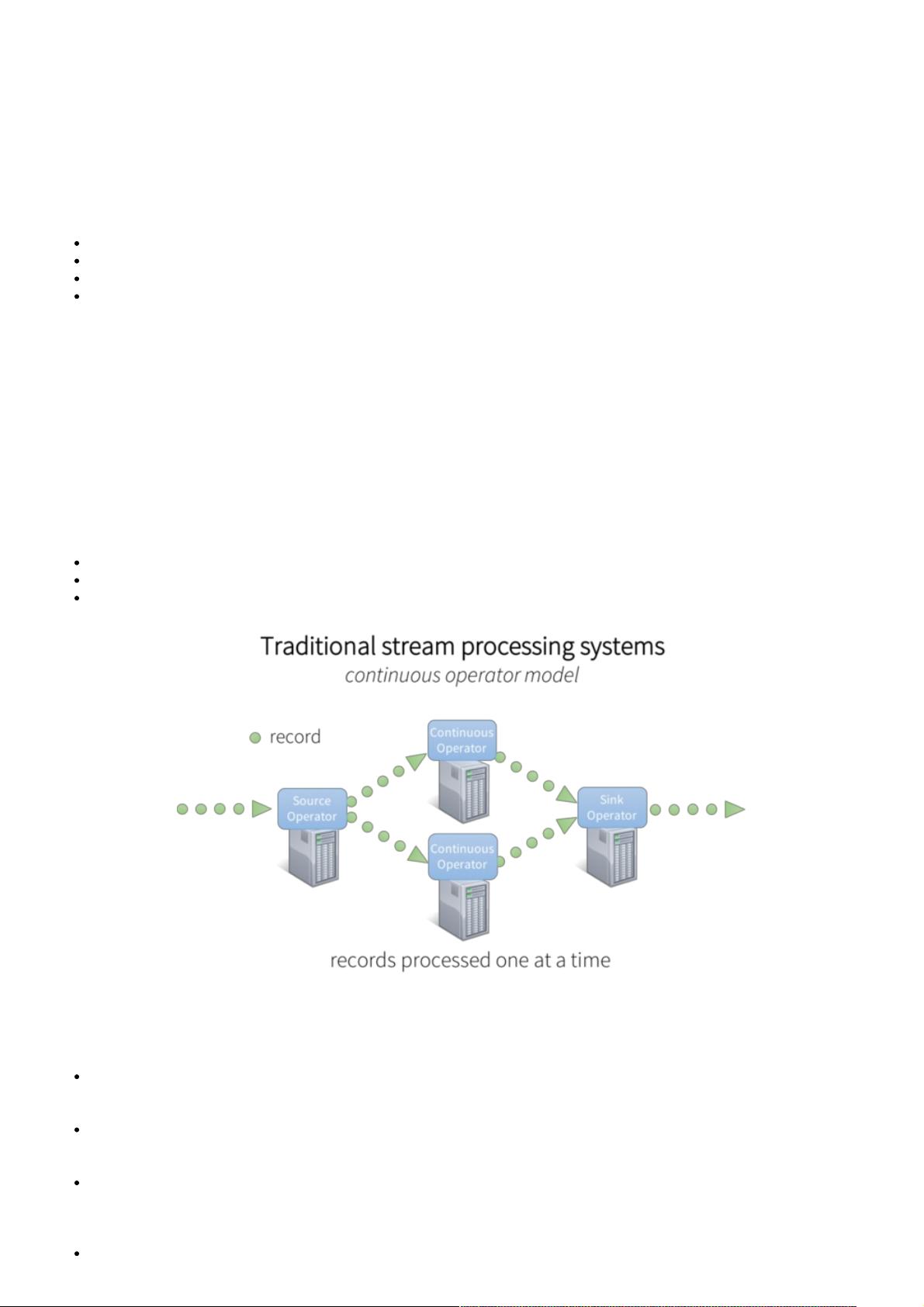

3. 算子执行:数据通过一系列连续或非连续的Spark操作(即算子)进行处理,每个算子负责一个特定的数据转换操作。

4. 负载均衡与资源管理:Spark Streaming能够动态调整任务的分配,确保资源的有效利用,提高整体性能。

5. 结果存储:处理后的数据被发送到下游系统,如HBase、Cassandra或再次返回到消息队列,形成数据流的闭环。

6. 集成与查询:Spark Streaming可以无缝地与静态数据集交互,支持SQL查询和高级分析,包括机器学习和图处理等复杂操作。

为了应对大数据时代的挑战,Spark Streaming克服了连续算子模型的局限性,提供了更高的灵活性和可扩展性。然而,尽管Spark Streaming在许多方面表现出色,但它仍然面临实时性挑战,因为微批处理的窗口大小决定了响应时间。为了进一步优化,研究人员正在探索新的模型和优化策略,如减少窗口大小、实时数据处理的低延迟实现等。

深入理解Spark Streaming的执行模型有助于开发者更好地设计实时数据处理应用,充分利用Spark的强大功能,并针对具体场景选择最合适的处理策略。未来,随着技术的发展,Spark Streaming可能会引入更多的创新,以适应不断变化的数据处理需求。

2018-03-02 上传

2017-11-03 上传

2019-05-05 上传

2024-11-02 上传

2023-09-14 上传

2024-11-09 上传

2024-11-12 上传

2024-11-06 上传

2024-11-05 上传

weixin_38675777

- 粉丝: 3

- 资源: 917