计算机视觉中的自注意力与尺度注意力机制综述

版权申诉

85 浏览量

更新于2024-08-11

收藏 451KB PDF 举报

计算机视觉中的注意力机制研究是近年来深度学习领域的重要课题,它旨在模拟人类大脑的注意力功能,以提升计算机对图像中关键信息的识别和处理能力。本文主要探讨了两种核心的注意力机制类型:self-attention和scale attention。

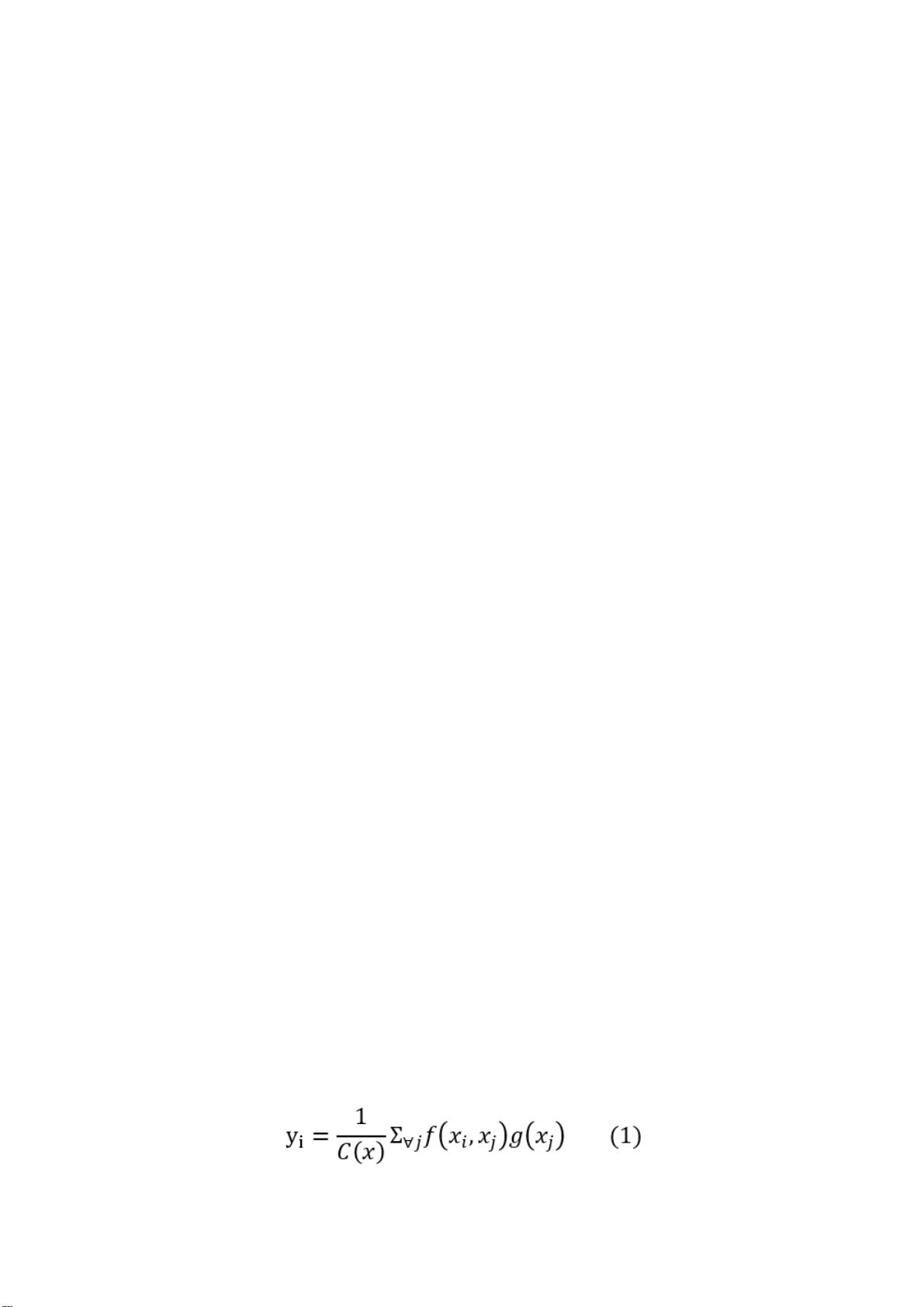

首先,self-attention,源自[1]提出的Transformer模型,最初应用于机器翻译任务中,通过调整查询(query)和键(key)来自同一空间的计算方式,计算不同位置间的关系,从而更好地提取输入句子或图片的全局特征。这一机制极大地增强了模型的精度和并行性,特别是在视觉任务中,如语义分割和生成对抗网络,它能够突破传统卷积神经网络的局部限制,实现对全局信息的有效捕捉。

然而,self-attention在处理视觉数据时也存在挑战。由于图像像素众多,全量计算会导致高昂的计算成本和显存消耗。此外,它假设所有位置独立处理,忽略了像素间的相对位置信息,这可能丢失图像的结构信息。为解决这个问题,研究者开始探索如何在self-attention中融入相对位置编码,例如通过添加位置嵌入或者设计专门的模块来保留图像的空间结构。

另一方面,scale attention,虽然具体文献未在摘要中提及,可能是指对不同尺度特征的注意力机制,这种机制可能关注于不同尺度下的视觉元素,比如物体的大小、形状等,有助于捕捉图像中的多尺度信息。在实际应用中,结合自注意力和尺度注意力,可能能进一步提高计算机视觉模型的鲁棒性和准确性。

总结来说,计算机视觉中的注意力机制研究是深度学习中一个至关重要的分支,它通过模拟人脑的注意力,优化了信息处理过程,显著提高了视觉任务的性能。同时,随着技术的发展,不断出现的新方法和改进,如相对位置编码的引入,将继续推动这一领域的发展。理解并掌握这些注意力机制,对于开发高效、准确的计算机视觉系统具有重要意义。

2022-04-21 上传

2021-09-28 上传

2022-04-15 上传

2022-04-21 上传

2022-05-24 上传

2021-11-18 上传

2021-09-28 上传

2022-06-06 上传

2022-04-21 上传

_webkit

- 粉丝: 31

- 资源: 1万+

最新资源

- MongoDB-test-project

- Accuinsight-1.0.22-py2.py3-none-any.whl.zip

- AppBots:IIT2019053,IIT2019039,IIT2019059,IIT2019060

- 电动机星三角启动程序.rar

- PGA 排行榜抓取器:从 PGA 官方网站上的当前排行榜中抓取玩家分数-matlab开发

- 曼达

- Ignite-Trilha-ReactJS:培训期间开发的讲义和项目,重点是Rocketseat的ReactJS

- goormExploration:goormIDE的探索可用性,带宽,速度,可用工具或发行版等

- Mergely:在线合并和差异文档

- clase1_NT2

- 笔记本销售网站的ASP毕业设计(源代码+论文).zip

- 反向传播教程 - 神经网络的训练算法:关于反向传播算法的西班牙语教程。 仅用于学术和教育用途。-matlab开发

- React初始项目

- CanturkFramework:开发了完整的.Net框架结构,其中使用了许多用于OOP的技术

- 基于网络环境的库存管理系统的asp毕业设计(源代码+论文).zip

- zb-php:ZB API像官方文档界面一样,支持任意扩展