python运用运用sklearn实现实现KNN分类算法分类算法

KNN(K-Nearest-Neighbours Classiflication)分类算法,供大家参考,具体内容如下

最简单的分类算法,易于理解和实现

实现步骤:通过选取与该点距离最近的k个样本,在这k个样本中哪一个类别的数量多,就把k归为哪一类。

注意

该算法需要保存训练集的观察值,以此判定待分类数据属于哪一类

k需要进行自定义,一般选取k<30

距离一般用欧氏距离,即

通过通过sklearn对数据使用对数据使用KNN算法进行分类算法进行分类

代码如下:

## 导入鸢尾花数据集

iris = datasets.load_iris()

data = iris.data[:, :2] target = iris.target

## 区分训练集和测试集,75%的训练集和25%的测试集

train_data, test_data = train_test_split(np.c_[data, target])

## 训练并预测,其中选取k=15

clf = neighbors.KNeighborsClassifier(15, 'distance')

clf.fit(train_data[:, :2], train_data[:, 2])

Z = clf.predict(test_data[:, :2])

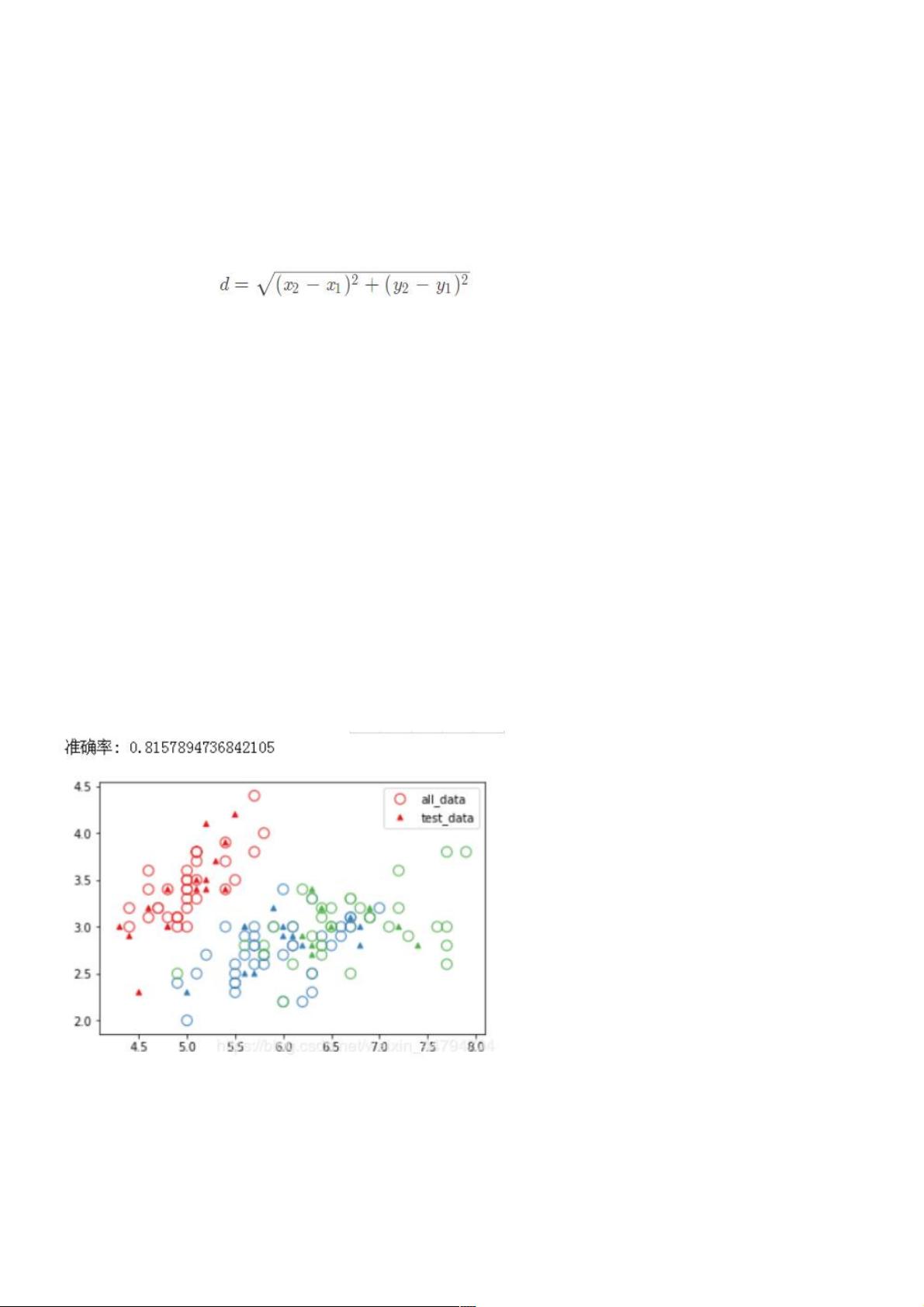

print '准确率:' ,clf.score(test_data[:, :2], test_data[:, 2])

colormap = dict(zip(np.unique(target), sns.color_palette()[:3]))

plt.scatter(train_data[:, 0], train_data[:, 1], edgecolors=[colormap[x] for x in train_data[:, 2]],c='', s=80, label='all_data')

plt.scatter(test_data[:, 0], test_data[:, 1], marker='^', color=[colormap[x] for x in Z], s=20, label='test_data')

plt.legend()

plt.show()

结果如下:

您可能感兴趣的文章您可能感兴趣的文章:使用python实现kNN分类算法python实现KNN分类算法基于python实现KNN分类算法python机器学习之

KNN分类算法用Python实现KNN分类算法原生python实现knn分类算法

评论0