没有合适的资源?快使用搜索试试~ 我知道了~

首页深度元学习-A Survey of Deep Meta-Learning-翻译.docx

资源详情

资源评论

资源推荐

深度元学习

摘要

深度神经网络在拥有大量数据集和足够的计算资源的情况下能够取

得巨大的成功。然而,他们快速学习新概念的能力相当有限。元学

习是解决这一问题的一种方法,通过使网络学会如何学习。令人兴

奋的是深度元学习领域正在高速发展,但缺乏对当前技术的统一、

深刻的概述。这项工作就是在为读者提供理论基础,我们研究和总

结了主要的方法,这些方法被分为 度量;模型;和 基于优化

的技术。此外,我们确定了主要的开放挑战,如在异构基准上的性

能评估,以及元学习计算成本的降低。

关键词:元学习,学会学习,少镜头学习,迁移学习,深度学习

引言

近年来,深度学习技术在各种任务上取得了显著的成功,包括

玩游戏 等人, 年; 等人, 年、图像识别

!"# 等人, 年;$ 等人,% 年和机器翻译& 等人,

年。 尽管取得了这些进展,但仍有许多挑战有待解决,例如

为取得良好效果需要大量数据和训练。 这些要求严重限制了深度神

经网络快速学习新概念的能力,这是区别于人类智力的主要方面之

一'#("# 等人, 年;# 等人,) 年。

元学习被认为是克服这一挑战的一种策略*# 和

++,,, 年;-+./,,0) 年;1,,,0 年。 关

键在于元学习随着时间的推移提高自己的学习能力,或者换个说法,

学会学习。 学习过程主要涉及任务(观察资料集)和任务,并发生

在两个不同的层次:内部和外部层次。 在内部层面,提出了一个新

的任务,并试图从训练观察中快速学习相关的概念。 这种快速适应

得益于它在外部层面的早期任务中积累的知识的。因此,虽然内部

层关注单个任务,但外部层关注多个任务。

从历史上看,元学习这个术语的使用范围很广。从最广泛的意义

上说,它概括了所有利用之前的学习经验以更快地学习新任务的系

统2"-30。这个广泛的概念包括更传统的机器学习算法

选择和超参数优化技术4!.30。然而,在这项工作中,

我们专注于元学习领域的一个子集,该领域开发元学习程序来学习

深度神经网络的良好诱导偏差。从今以后3我们使用术语深度元学

习指元学习的领域。

深度元学习领域正在快速发展,但它缺乏一个连贯、统一的概述,

无法提供对关键技术的详细洞察。2"-0对元学习技术进

行了调查,其中元学习被广泛使用,限制了对深度元学习技术的描

述。此外,在调查发表后,深度元学习领域也出现了许多令人兴奋

的发展。$"." 等人最近的一项调查采用了与我们相同的

深度元学习概念,但目的是广泛地概述,而忽略了各种技术的技术

细节。

我们试图通过提供当代深度元学习技术的详细解释来填补这一空

白,使用统一的符号。此外,我们确定了当前的挑战和未来工作的

方向。更具体地说,我们覆盖了监督和强化学习领域的现代技术,

已经实现了最先进的性能,在该领域获得了普及,并提出了新的想

法。由于 5, )和相关技术对该领域的影响,我

们给予了格外的关注。本研究可作为深度元学习领域的系统性介绍,

并可作为该领域资深研究人员的参考资料。在整个过程中,我们将

采用 2")所使用的分类法,该分类法确定了三种深度元学

习方法6度量、模型和 基于优化的元学习技术。

文章主要架构如下:第二部分叙述了一个理论基础,我们以此为

基础对深度元学习进行概述。第三、四和五节分别介绍了主要的基

于度量、基于模型和基于优化的元学习技术、第六节提供了这个领

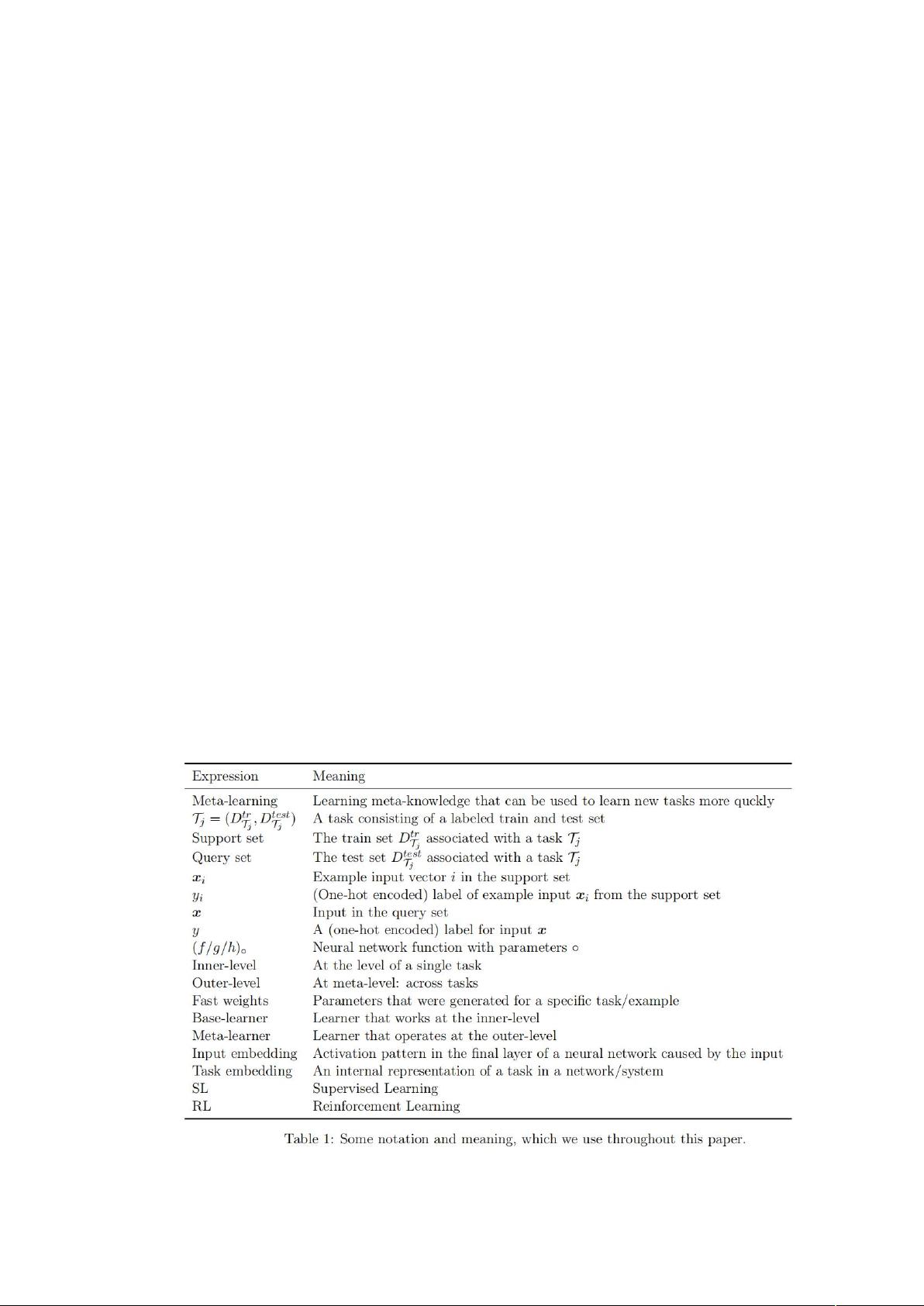

域的技术视图,并总结了主要挑战和未解决的问题。表一叙述了本

文中需要使用的符号。

2 理论基础

在本节中,我们为以一致的方式研究深度元学习技术奠定了必要

的基础。 首先,我们对比常规学习和元学习。 随后,我们简要讨论

了深度元学习与不同领域的关系,通常的训练和评估程序是什么样

子的,以及经常为此目的使用哪些基准。 我们通过描述元学习领域

的一些应用和背景来完成本节。

2.1 元的概念

本节我们针对两个不同的方法(监督学习和强化学习)对比了常

规学习和元学习。

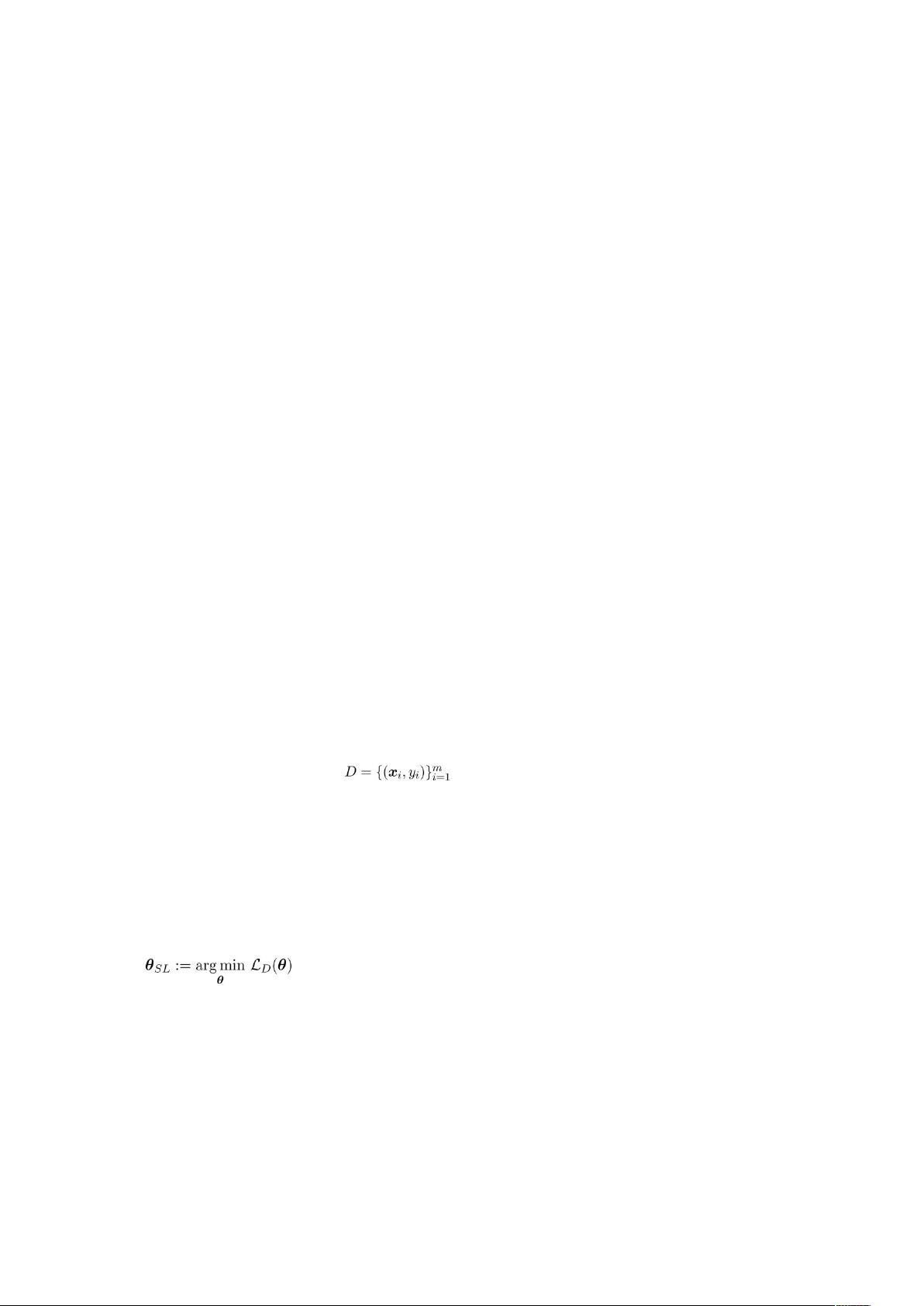

2.1.1 常规监督学习

在监督学习中,我们希望学习一个函数 f

θ

:X→Y,它学习将输入

x

i

∈X 映射到相应的输出 y

i

∈Y。 式中,θ 是模型的参数(例如神经

网络的权重),它决定了函数的效能。 为了学习这些参数,我们给

模型 m 个观察数据: 。依靠给的数据 D,模型要去寻找

到满足经验损失函数 L

D

最小值条件的参数集。在这个过程中,要能

监测模型的执行状况,从而随时进行调整。总之,我们希望能找

到:

其中 SL 代表“监督学习”。 请注意,这个目标是特定于数据集 D

的,这意味着我们的模型 f

θ

可能不会适用于 D 之外的数据集。为了

衡量模型的普适性,可以在单独的,没有使用过的测试数据集上评

估模型的性能。一种主流的方法是交叉验证,在数据集 D 中反复地

创建训练集和测试集,并用来训练和评估模型。(Hastie 等

人,2009 年)。

寻找全局最优参数 θ

SL

通常在计算上是不可行的。 然而,我们可

以利用先验知识 ω(Hospedales 等人,2020 年)来得到参数的近似

值,例如初始模型参数 θ,选择的优化器和学习率序列。 这样,我

们近似得到了:

其中

7

是一个优化器,它使用预定义的元知识 7、数据集 和损

失函数

来生成更新在数据集 上表现得(可能)比较好的权重

7,

。

监督元学习

相反,有监督的元学习并不预先定义任何元知识 7。 相反,元

学习的目标是找到最好的 7,这样我们的(正规)基础学习者(类

似于迁移学习)就可以尽快学习新的任务(数据集)。 因此,虽然

监督规则学习涉及一个数据集,但监督元学习涉及一组数据集。 目

标是学习元知识 7 使我们的模型能够很好地学习许多不同的任务。

因此,我们的模式是学习学习。

更正式地说,我们有一个任务 1的概率分布,并希望找到最优

的元知识:

在这里,内部级别()关注特定于任务的学习,而外

剩余63页未读,继续阅读

dream230306

- 粉丝: 1

- 资源: 1

上传资源 快速赚钱

我的内容管理

收起

我的内容管理

收起

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

会员权益专享

最新资源

- RTL8188FU-Linux-v5.7.4.2-36687.20200602.tar(20765).gz

- c++校园超市商品信息管理系统课程设计说明书(含源代码) (2).pdf

- 建筑供配电系统相关课件.pptx

- 企业管理规章制度及管理模式.doc

- vb打开摄像头.doc

- 云计算-可信计算中认证协议改进方案.pdf

- [详细完整版]单片机编程4.ppt

- c语言常用算法.pdf

- c++经典程序代码大全.pdf

- 单片机数字时钟资料.doc

- 11项目管理前沿1.0.pptx

- 基于ssm的“魅力”繁峙宣传网站的设计与实现论文.doc

- 智慧交通综合解决方案.pptx

- 建筑防潮设计-PowerPointPresentati.pptx

- SPC统计过程控制程序.pptx

- SPC统计方法基础知识.pptx

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功

评论0