文本情感分析:去除标点与停用词优化

151 浏览量

更新于2023-03-03

收藏 71KB PDF 举报

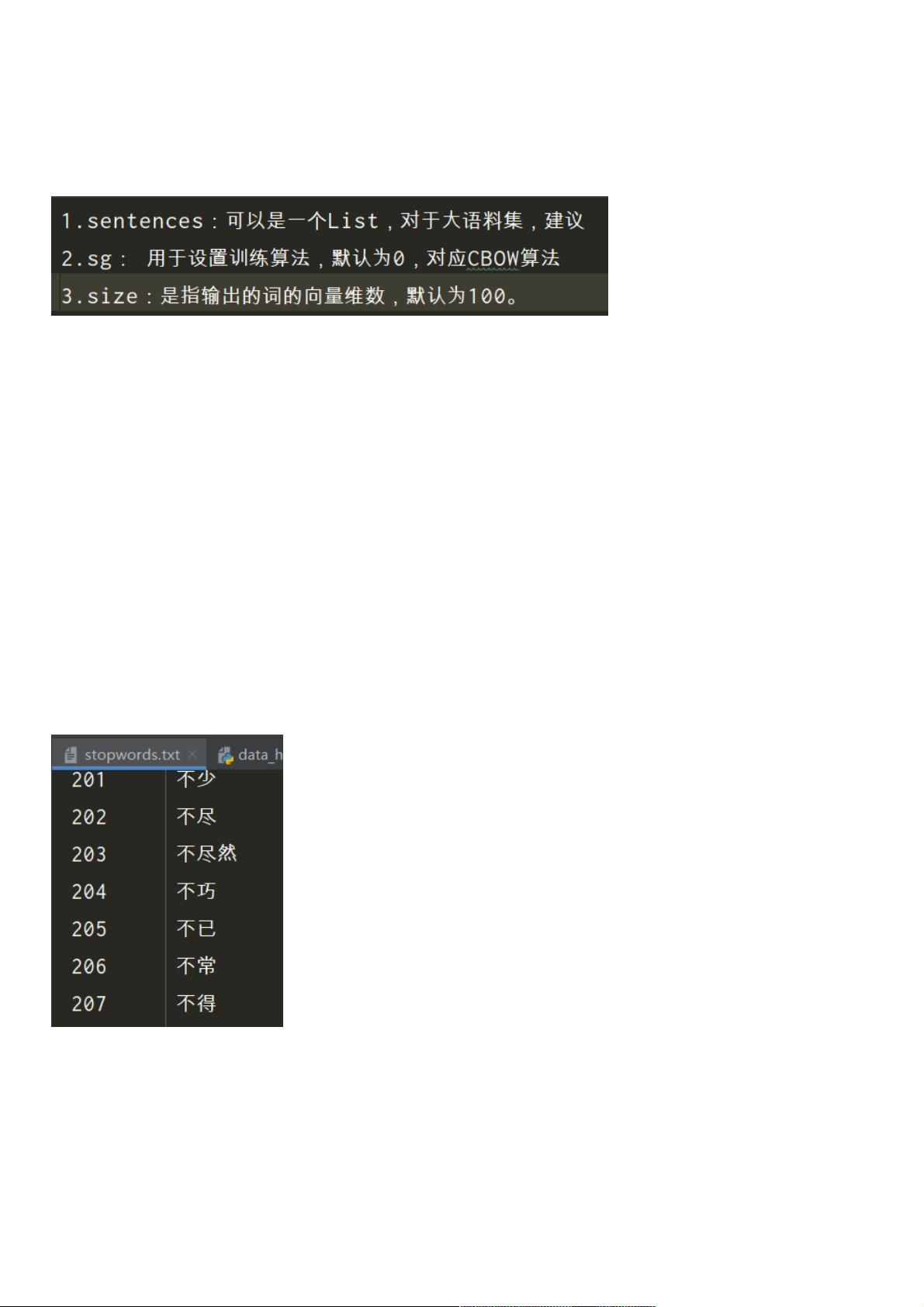

在文本情感分析中,"去停用词"是一个关键步骤,它有助于提高分析效率和准确性。停用词是指在文本处理过程中通常被忽略的常见词汇,如介词、连词、冠词等,它们在大部分情况下对情感分析的主体内容贡献较小。这里主要讨论的是两种去停用词的方法:

1. 预处理阶段去除标点符号:

首先,为了简化文本并减少干扰,常用正则表达式来移除字符串中的标点符号。在gensim的word2vec模型应用中,通过定义函数`clearn_str`来实现这一过程。该函数首先筛除中文标点,接着移除英文标点,确保文本只包含字母和可能对情感分析有意义的单词。

```python

def clearn_str(string):

string = re.sub(r'[……「」『』【】〔〕…·!?。。]', '', string) # 筛除中文标点

string = re.sub(r'[!"#$%&\'()*+,-./:;?@[\]^_`{|}~]', '', string) # 筛除英文标点

return string

```

2. 分词后去除停用词:

分词完成后,可以进一步去除停用词,这通常在自然语言处理中进行。这里提到了使用nltk库中的英文停用词列表,同时也可以获取中文停用词。例如,从nltk的`stopwords`模块加载英文停用词,并从外部文件(如链接提供的`stopwords.txt`)中加载中文停用词。

```python

from nltk.corpus import stopwords

import jieba

# 获取英文停用词

stopwords1 = stopwords.words('english')

# 加载中文停用词

with open('../data/stopwords.txt', 'r', encoding='utf8') as f:

chinese_stopwords = f.readlines()

```

去除停用词后,文本将仅包含那些对情感倾向有较大影响的词汇,这对于后续的情感分析模型(如TF-IDF、LDA或深度学习模型)训练更为有效。在实际应用中,可以考虑根据具体需求调整这些步骤,例如,是否在预处理阶段移除停用词,或者在模型训练时动态排除停用词。

文本情感分析中的去停用词是提高分析准确性和效率的重要手段,它能帮助过滤掉无意义的词,使模型能够更专注于关键的情感承载词汇,从而得出更精确的情感判断。

294 浏览量

638 浏览量

323 浏览量

638 浏览量

133 浏览量

102 浏览量

152 浏览量

124 浏览量

254 浏览量

weixin_38693720

- 粉丝: 10

- 资源: 900

最新资源

- 不看后悔的人事管理系统论文

- jmeter测试流程

- 图书管理系统_概要规划说明书

- 图书管理系统_软件开发设计书

- iBATIS 入门指南

- 很不错的java面试宝典

- C#函数方法集(汇总c#.net常用函数和方法集)

- Servlet_JSP

- 硬件必读硬件必读\硬件必读\硬件必读\

- Apache+ActiveMQ教程.pdf下载

- plsql21天自学通

- A Novel Invisible Color ImageWatermarking Scheme using Image Adaptive Watermark Creation and Robust Insertion-Extraction

- BerkeleyDB

- MapInfo Professional操作指南(pdf)

- 软件需求变更管理七步法

- 计算机软件测试面试题