没有合适的资源?快使用搜索试试~ 我知道了~

首页sparkStreaming实战学习资料

sparkStreaming实战学习资料

需积分: 50 21 下载量 107 浏览量

更新于2023-03-16

评论

收藏 287KB DOCX 举报

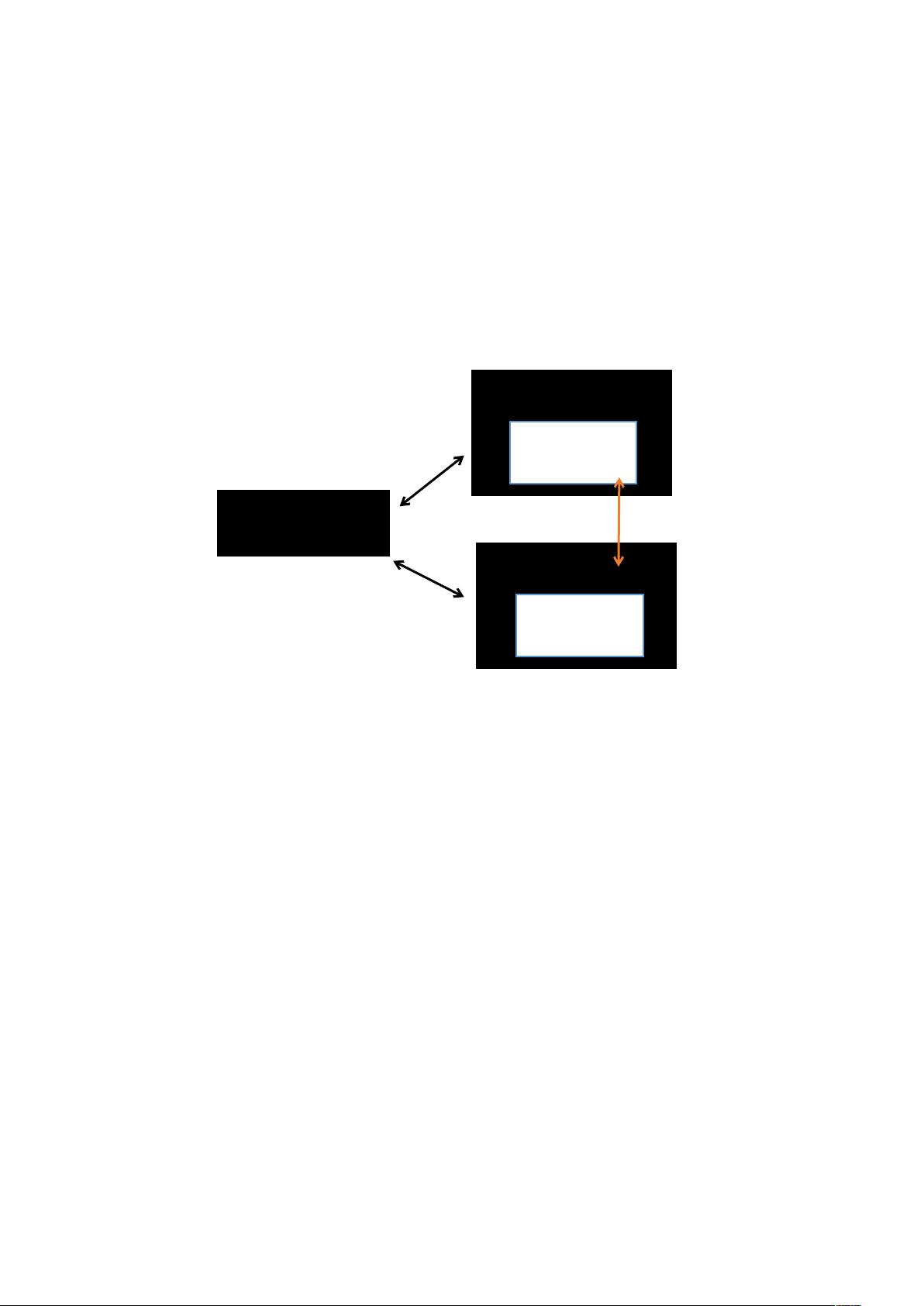

Spark核心概念简介: Spark使用maven进行打包(减少jar包大小): Spark中的(弹性分布式数据集)简称RDD: Spark中的Transformation操作之Value数据类型的算子: Spark中的Transformation操作之Key-Value数据类型的算子: Spark中的Action操作: Transformation->map算子: Transformation->flatMap算子: FaltMap算子与Map算子的区别 Action->reduce算子: Action->collect算子: Spark懒加载: Spark本地运行只要数据不要多余的日志: Spark本地运行没有Hadoop而报错: SparkStreaming中的window窗口操作: SparkStreaming中的reduceByWindow窗口操作: SparkStreaming中的正常操作(每读2秒就计算一次): Spark中的local[2]: Spark中的处理流程图像:

资源详情

资源评论

资源推荐

指引

核心概念简介

使用 进行打包减少 包大小

中的弹性分布式数据集简称

中的 操作之 数据类型的算子

中的 操作之 数据类型的算子

中的 操作

算子

算子

! 算子与 算子的区别

" 算子

算子

懒加载

本地运行只要数据不要多余的日志

本地运行没有 #" 而报错

$% 中的 &$"& 窗口操作

$% 中的 "'($"& 窗口操作

$% 中的正常操作每读 ) 秒就计算一次

中的 *)+

中的处理流程图像

Spark 核心概念简介:

,$,-,./!$01"22////./3

4$. 统计 中的元素个数

$,5%

从 上层来看,每一个 应用都由一个驱动器程序"$,%来发起集群

上的各种并行操作.我们在类中所写的 $ 方法就属于驱动器程序6"$,% 通过一个

7/ 来访问 6这个对象代表对计算集群的一个链接。

如果你使用 ,1 来写代码的话,那么 "$,% 就是 ,1 本身,且

1 启动时自动创建了 7/ 对象

8/

如果要执行 算子等操作,那么 "$,% 会自动将操作发送到各个执行器节

点/上。那么不同的节点会分工进行计算,然后将数据返回给 "$,%

,,,,,,,

,,,,,,,,,,,,,,

Spark 使用 maven 进行打包(减少 jar 包大小):

9%.:.%92

9%$%92%$%

的依赖包

9;,1<22$.22%.1.2=).>?,

9""

,,,,9%@"%.1.92%@"

,,,,9@"=).>?92@"

9$).>.>92$

9$""92

92""

这里之所以使用 "$"" 是为了确保 不与应用依赖的其他工件打包在一起,但

如果本地测试的话则需要吧这个 "$"" 注释掉否则,@8 是找不到这个包的同时也无

法使用该包下面的类 , 但 是由于在 集 群 的 环境变量 中 有 这 个 包所以 使 用

"$"" 不仅可以避免 包冲突,还可以减少 包的大小

在 '$" 的下面写

9%$ %

,,9%$

,,,,9%$

,,,,,,9%@"%.1..%$92%@"

8/

执行器

任务6任务

执行器

任务任务

$,5%

,,,,7/

8/

执行器

任务6任务

执行器

任务任务

,,,,,,9@"$%$92@"

,,,,,,9$).A.)92$

,,,,,,9B%

,,,,,,,,9CD.$E92

,,,,,,,,9%CD.$E92%

,,,,,,92B%

,,,,92%$

,,92%$

92%$ %

Spark 中的(弹性分布式数据集)简称 RDD:

中的 是一个不可变的分布式对象集合,每个 都会被分为多个分区,这

些分区运行在集群中的不同节点上。

创建 两种办法

!$读取外部数据集,,常用

.$F4$03633把程序中一个已有的集合传给 $F,不常用占内存

的持久化也称为缓存$

是惰性求值的,而有时我们希望多次使用同一个 ,如果简单的对 调

用行动操作, 会重算 以及它的所有依赖。这样的消耗格外的大。

例如下面的例子我使用了 ) 次 算子分别是计算数量。将数据输出成字符串的格

式并且以逗号进行分割这样等于是计算了 ) 次 ,消耗大。

,,-,$./-/G/

5$.

5$..$%6

为了避免多次计算同一个 ,可以让 对数据进行持久化。为了避免一个有持

久化节点数据的设备发生故障,我们可以将数据备份到多个节点上 存储级别的末尾加上

=)

持久化存储的级别

剩余10页未读,继续阅读

忆山

- 粉丝: 14

- 资源: 4

上传资源 快速赚钱

我的内容管理

收起

我的内容管理

收起

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

会员权益专享

最新资源

- c++校园超市商品信息管理系统课程设计说明书(含源代码) (2).pdf

- 建筑供配电系统相关课件.pptx

- 企业管理规章制度及管理模式.doc

- vb打开摄像头.doc

- 云计算-可信计算中认证协议改进方案.pdf

- [详细完整版]单片机编程4.ppt

- c语言常用算法.pdf

- c++经典程序代码大全.pdf

- 单片机数字时钟资料.doc

- 11项目管理前沿1.0.pptx

- 基于ssm的“魅力”繁峙宣传网站的设计与实现论文.doc

- 智慧交通综合解决方案.pptx

- 建筑防潮设计-PowerPointPresentati.pptx

- SPC统计过程控制程序.pptx

- SPC统计方法基础知识.pptx

- MW全能培训汽轮机调节保安系统PPT教学课件.pptx

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功

评论0