没有合适的资源?快使用搜索试试~ 我知道了~

首页BP CNN RNN LSTM 技术分享

资源详情

资源评论

资源推荐

技术分享—BP CNN RNN LSTM

Part IPart I BP反向传播神经网络 BP反向传播神经网络

反向传播算法的核心就是梯度下降 + 链式法则求偏导梯度下降 + 链式法则求偏导

所谓神经网络的训练或者是学习,其主要目的在于通过学习算法得到神经网络解决指定问题所需的参数,所谓神经网络的训练或者是学习,其主要目的在于通过学习算法得到神经网络解决指定问题所需的参数,

这里的参数包括各层神经元之间的连接权重以及偏置等这里的参数包括各层神经元之间的连接权重以及偏置等

偏置结点是为了描述训练数据中没有的特征,偏置结点对于下一层的每一个结点的权重的不同而生产不同的偏置,于是

可以认为偏置是每一个结点(除输入层外)的属性。

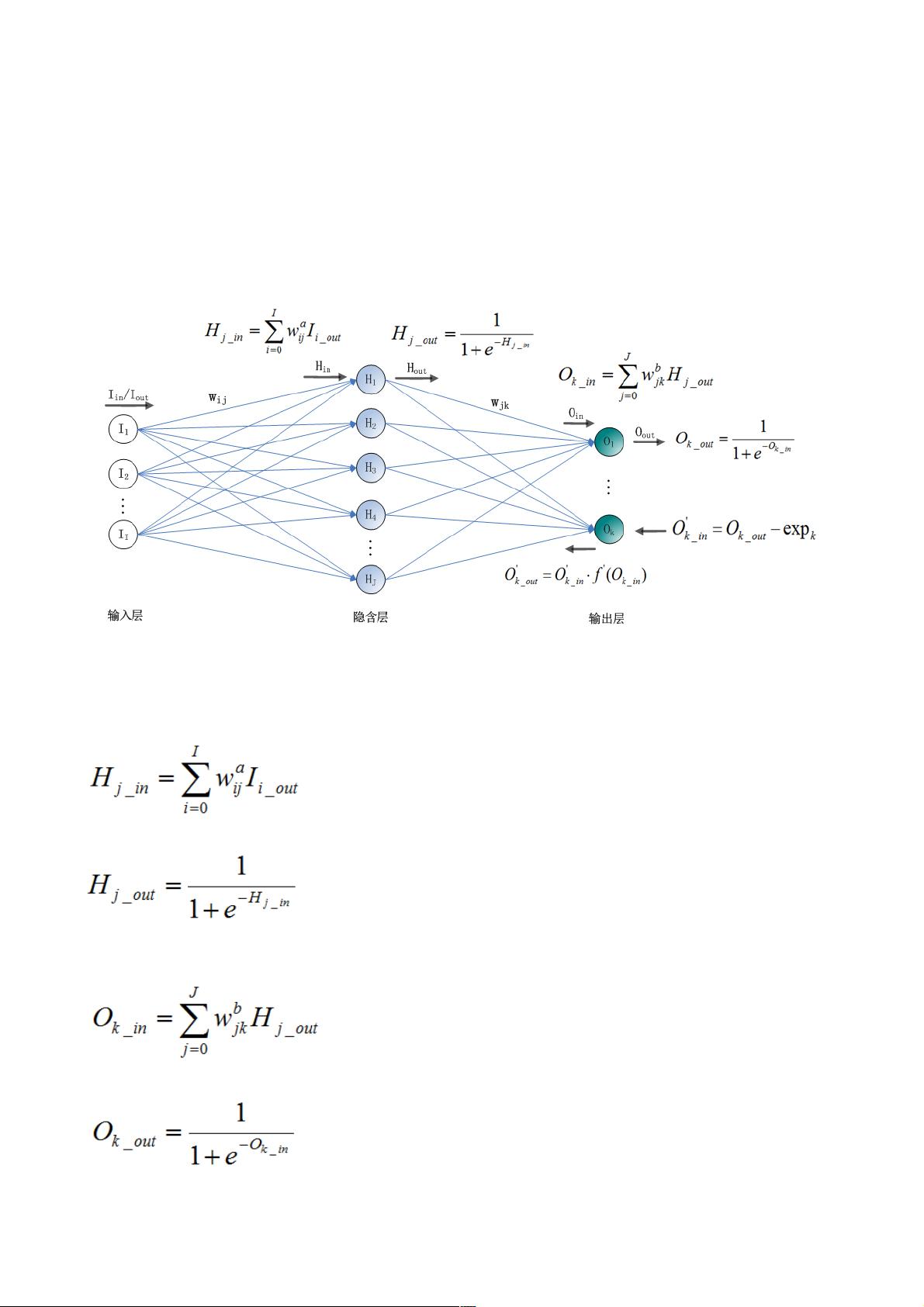

输入层(I个节点)、隐含层(J)、输出层(K)

1、前向传播

输入层的输入输出即为特征数据

隐层第j个节点的输入

输出

输出层的输入输出与隐层类似,分别为

它就是特征空间,隐层节点的个数就是特征空间的维数,或者说这组数据有多少个特征。而输入层到隐层的连接权重则

将输入的原始数据投影到特征空间,比如sj就表示这组数据在特征空间中第j个特征方向的投影大小,或者说这组数据有

多少份量的j特征。而隐层到输出层的连接权重表示这些特征是如何影响输出结果的,比如某一特征对某个输出影响比较

大,那么连接它们的权重就会比较大。关于隐层的含义就解释这么多,至于多个隐层的,可以理解为特征的特征。

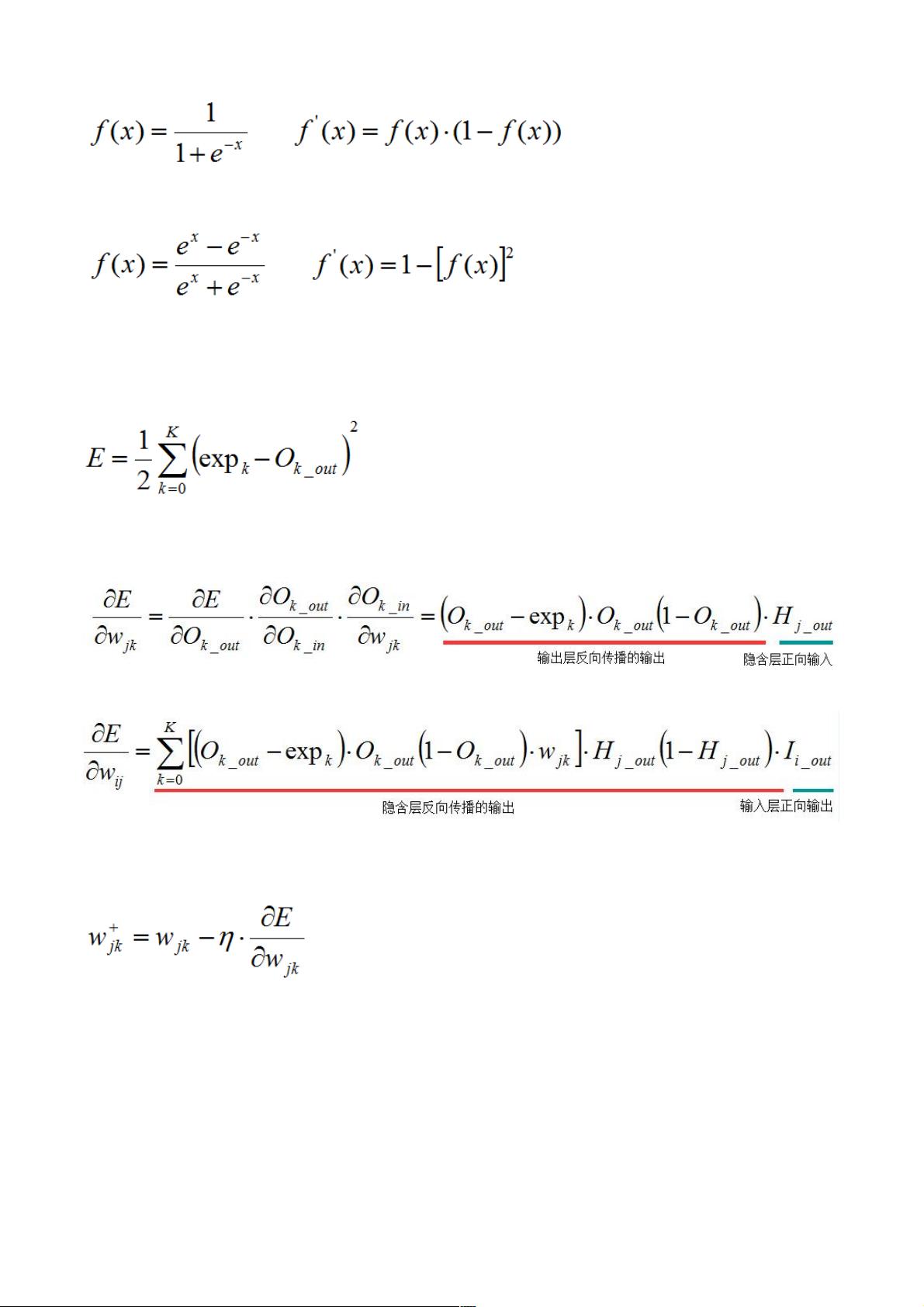

激活函数f(x),需满足处处可导,一般使用S形函数(即sigmoid函数),比如可以使用log-sigmoid:

或tan-sigmoid:

2、反向传播误差,调整权重

误差为

如何调整每个权重,使得E下降最快?利用梯度下降法,调整权重,使误差E不断减小,使结果往正确的方向变化。现在

任务就转化为求E对每个权重的梯度

连接隐含层与输出层之间权重:

连接输入与隐含层之间权重:

总结:每个权重的梯度都等于与其相连的前一层节点的输出乘以与其相连的后一层的反向传播的输出总结:每个权重的梯度都等于与其相连的前一层节点的输出乘以与其相连的后一层的反向传播的输出

更新权重

举例

[2.24, 6.4, 5.4, 6.4, 1.08, 4.82],期望输出是[0, 0 , 1]

第1次:

迭代

次数

输出 误差

1

[0.57251894, 0.55970883, 0.542

6416]

0.4251143

2

[0.54621994, 0.53369033, 0.562

9086]

0.3871152

7

......

1000

[0.021393767, 0.021391256, 0.9

786625]

6.8528415

E-4

5000

[0.0093104, 0.009310347, 0.990

69434]

1.2998068

E-4

目前没有任何理论能给出最佳节点数,只有经验公式可用。这里用的经验公式是sqrt(输入节点数+输出节点数)+0~9之间

的常数,也可以用log2(输入节点数),具体多少需要反复验证,这个经验公式还是有点靠谱的,至少数量级上没有太大

问题。

扩展资料

1.梯度下降:http://www.wengweitao.com/ti-du-xia-jiang-fa.html

2.BackPropagation:http://www.cnblogs.com/charlotte77/p/5629865.html

3.隐含层层数及节点数选取:http://www.doc88.com/p-1671451549252.html

4.BP算法改进:http://www.cnblogs.com/zhangchaoyang/articles/2269523.html

5.BP神经网络设计常用的基本方法和实用技术:http://www.lai18.com/content/601751.html

Part II CNNPart II CNN卷积神经网络卷积神经网络

卷积的含义?

物理意义:一个函数在另一个函上的加权叠加加权叠加.

Reference: https://www.zhihu.com/question/22298352?rf=21686447

剩余10页未读,继续阅读

Gongzixiaoge

- 粉丝: 1

- 资源: 1

上传资源 快速赚钱

我的内容管理

收起

我的内容管理

收起

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

会员权益专享

最新资源

- stc12c5a60s2 例程

- Android通过全局变量传递数据

- c++校园超市商品信息管理系统课程设计说明书(含源代码) (2).pdf

- 建筑供配电系统相关课件.pptx

- 企业管理规章制度及管理模式.doc

- vb打开摄像头.doc

- 云计算-可信计算中认证协议改进方案.pdf

- [详细完整版]单片机编程4.ppt

- c语言常用算法.pdf

- c++经典程序代码大全.pdf

- 单片机数字时钟资料.doc

- 11项目管理前沿1.0.pptx

- 基于ssm的“魅力”繁峙宣传网站的设计与实现论文.doc

- 智慧交通综合解决方案.pptx

- 建筑防潮设计-PowerPointPresentati.pptx

- SPC统计过程控制程序.pptx

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功

评论0