没有合适的资源?快使用搜索试试~ 我知道了~

首页机器学习笔记 Bishop版PAML

资源详情

资源评论

资源推荐

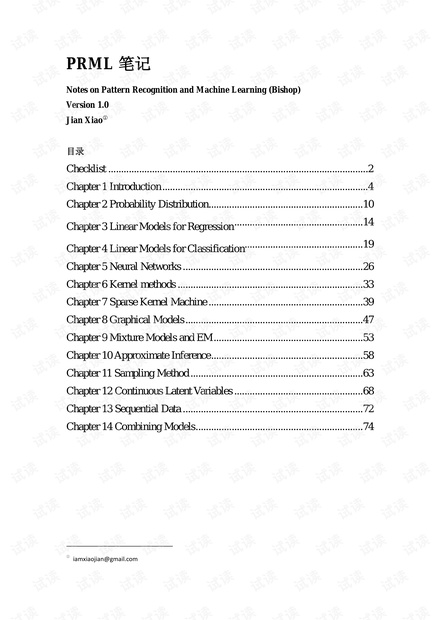

PRML 笔记

Notes on Pattern Recognition and Machine Learning (Bishop)

Version 1.0

Jian Xiao

①

目录

Checklist ..................................................................................................... 2

Chapter 1 Introduction ................................................................................ 4

Chapter 2 Probability Distribution ............................................................ 10

Chapter 3 Linear Models for Regression

.................................................. 14

Chapter 4 Linear Models for Classification

.............................................. 19

Chapter 5 Neural Networks ...................................................................... 26

Chapter 6 Kernel methods ........................................................................ 33

Chapter 7 Sparse Kernel Machine ............................................................ 39

Chapter 8 Graphical Models ..................................................................... 47

Chapter 9 Mixture Models and EM .......................................................... 53

Chapter 10 Approximate Inference ........................................................... 58

Chapter 11 Sampling Method ................................................................... 63

Chapter 12 Continuous Latent Variables .................................................. 68

Chapter 13 Sequential Data ...................................................................... 72

Chapter 14 Combining Models ................................................................. 74

①

iamxiaojian@gmail.com

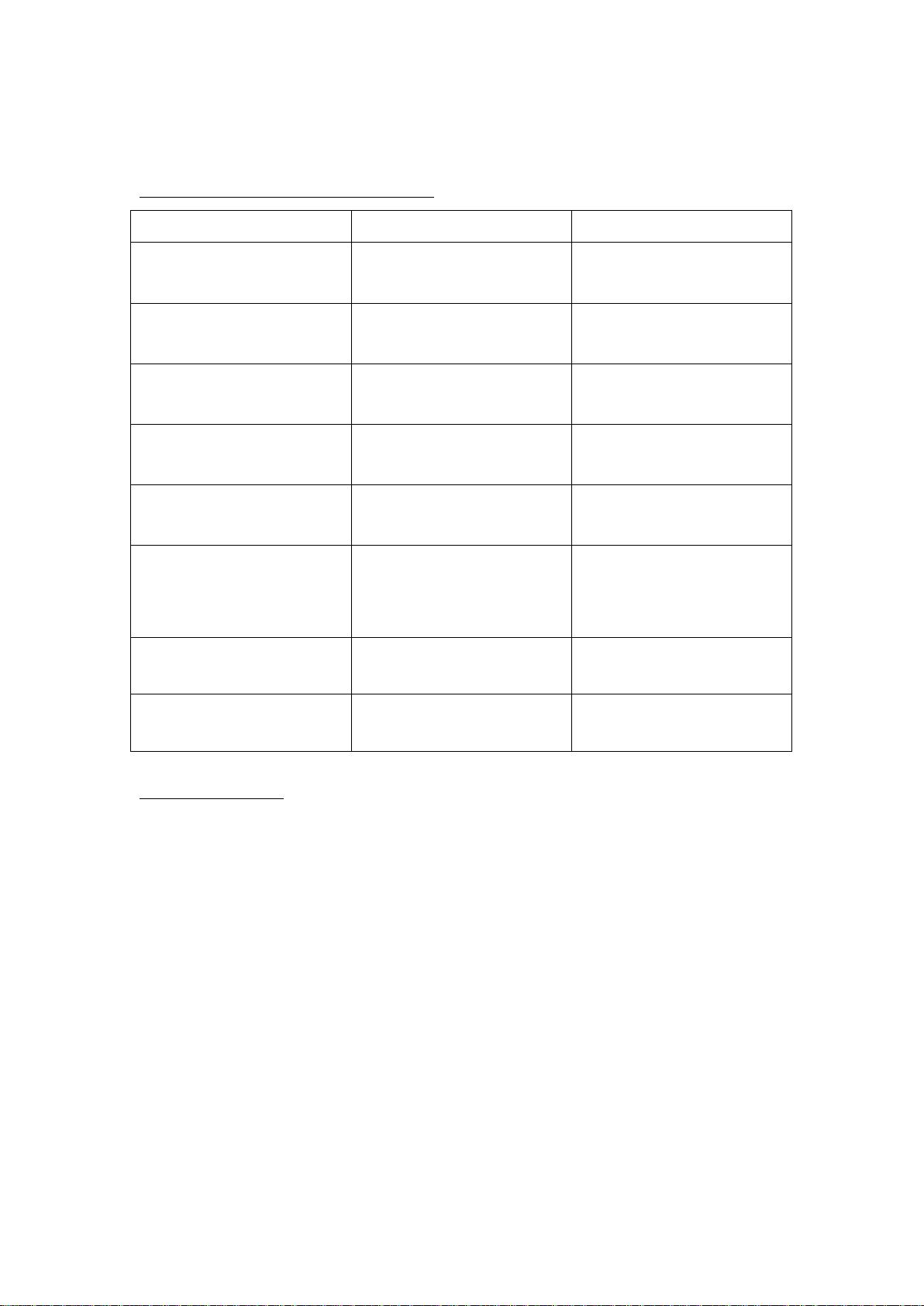

Checklist

Frequentist 版本

Frequentist-Bayesian对峙构成的主要内容

Bayesian 版本 解模型所用的方法

Linear basis function

regression

Bayesian linear basis function

regression

前者和后者皆有 closed-form

solution

Logistic regression

Bayesian logitstic regression

前者牛顿迭代(IRLS),后者

Laplace approximation

Neural network (for

regression, classification)

Bayesian Neural network (for

regression, classification)

前者 gradient decent,后者

Laplace approximation

SVM (for regression,

classification)

RVM (for regression,

classification)

前者解二次规划,后者迭代、

Laplace approximation

Gaussian mixture model Bayesian Gaussian mixture

model

前者用 EM,后者 Variation

inferencce

Probabilistic PCA

Bayesian probabilistic PCA

前者 closed-form solution 或

EM,后者 Laplace

approximation

Hidden markov model

Bayesian Hidden markov

model

前者 EM,后者未详提

Linear dynamic system

Bayesian Linear dynamic

system

前者 EM,后者未详提

1

(|) (|, )pN

αα

−

= 0w wI

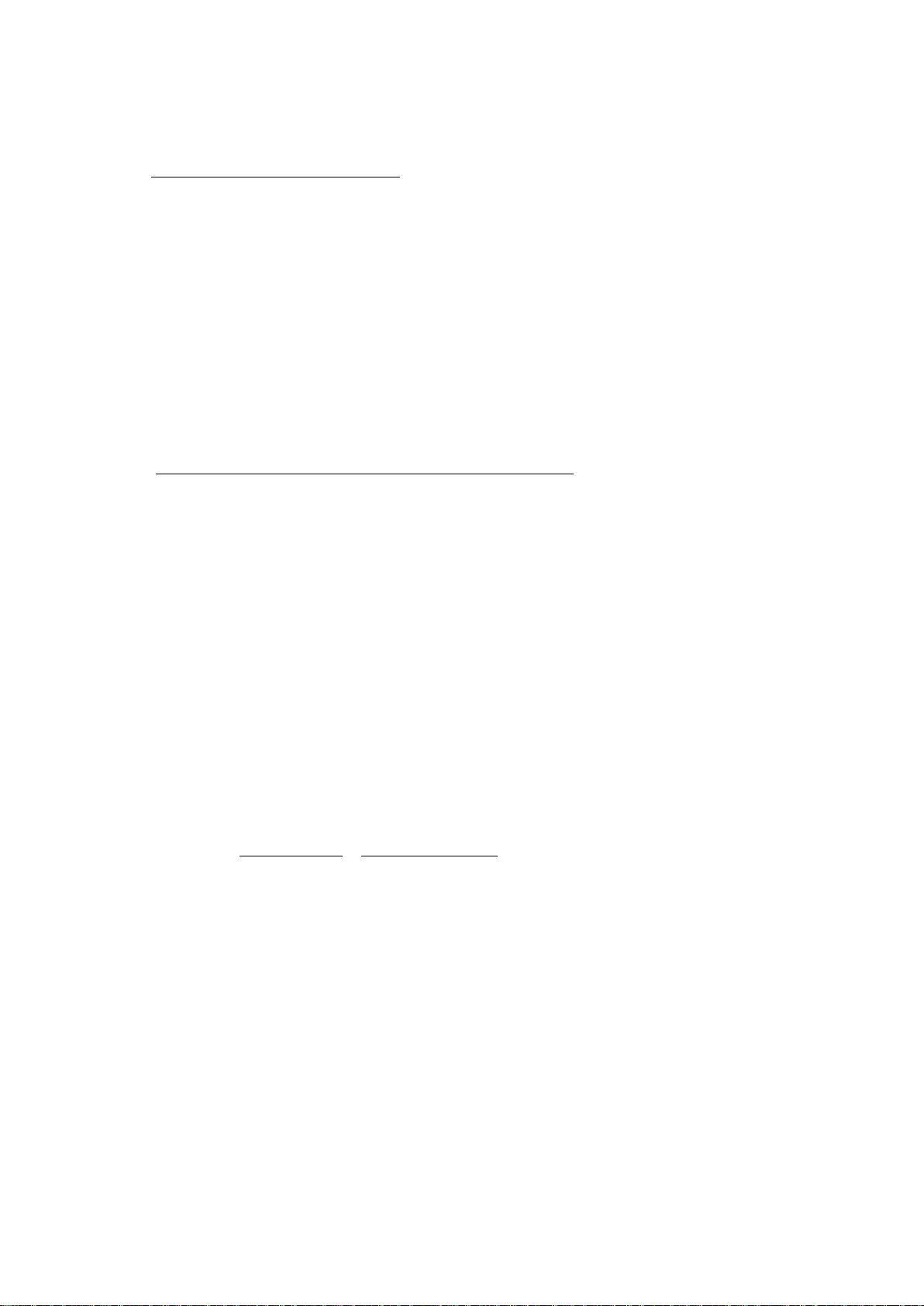

三种形式的Bayesian

Fully Bayesian

:需要

marginalize with respect to hyper-parameters as well as parameters

。而这

往往是

analytical intractable

的。

对于

curve fitting

的例子

(

,

1

(| , , ) (| (, ), )pt Nt y

ββ

−

=xw xw

)

来说,就是:

(|) (| , )( |,,)(, |)pt pt p p d d d

β αβ αβ α β

=

∫∫∫

t w wt t w

Empirical Bayes/type 2 maximum likelihood/evidence approximation

:对

hyper-parameter

采

取这样的策略,即先求出使得

marginal likelihood

最大化的参数

*

α

和

*

β

,然后使

hyper-parameter

取固定的值

*

α

和

*

β

,再对

w

进行

marginalize

:

** * **

(|) (|, , ) (| , ) ( |, , )pt pt pt p d

αβ β αβ

≈=

∫

t t w wt w

MAP(poor man’s Bayesian)

:不涉及

marginalization

,仅仅是一种按后验概率最大化的

point

estimate

。

PRML

说的

Bayesian

主要还是指

Empirical Bayesian

。

Optimization/approximation

Linear/Quadratic/Convex optimization:求线性/二次/凸函数的最值

Lagrange multiplier:带(等式或不等式)约束的最值

Gradient decent:求最值

Newton iteration:解方程

Laplace approximation:近似

Expectation Maximation (EM):求最值/近似,latent variable model 中几乎无处不在

Variational inference:求泛函最值

Expectation Propagation (EP):求泛函最值

MCMC/Gibbs sampling:采样

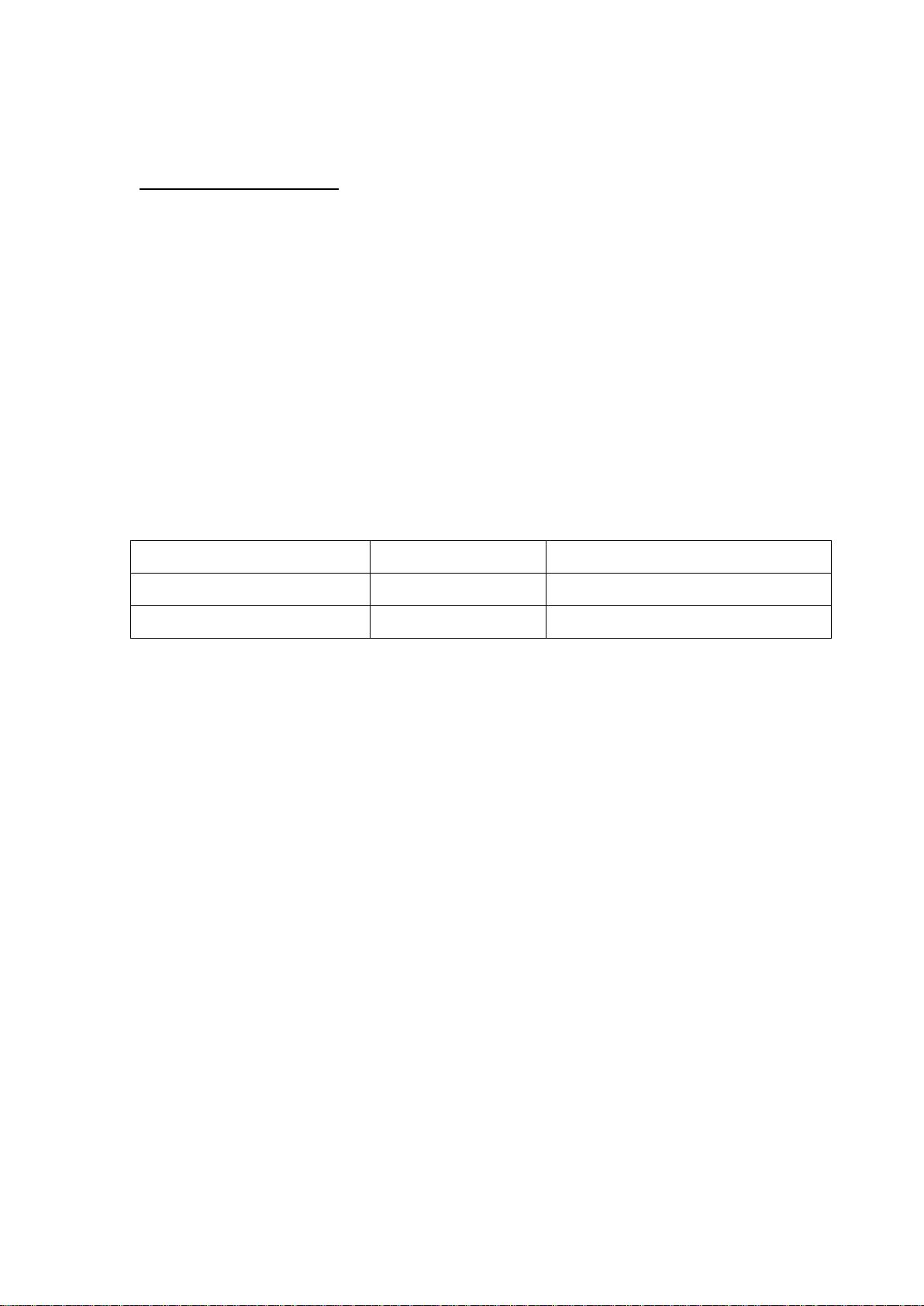

Latent variable model

Latent variable 离散 Latent variable 连续

Latent variable 独立

GMM

Probabilistic PCA/ICA/Factor Analysis

Latent variable 是 Markov chain

HMM

LDS

Objective function/ Error function/Estimator

Likelihood:MLE 参数估计的 estimator,最常用的目标函数

Marginal likelihood:emprical Bayes/evidence approximation 中用于估计 hyper-parameter

Sum-of-square error:regression 常用

Posterior:MAP 参数估计

Negative log likelihood/cross-entropy:Logistic regression

Exponential error:Adaboost 的目标函数

Hinge error:SVM 的目标函数

Chapter 1 Introduction

1. Bayesian interpretation of probability

与其说是贝叶斯学派对“概率”这个概念的解释,不如说是概率碰巧可以作为量化贝叶斯学

派“degree of belief”这个概念的手段。

贝叶斯学派的出发点是“uncertainty”这个概念,对此给予“degree of belief”以表示不确定性。

Cox showed that if numerical values are used to represent degrees of belief, then a simple set of

axioms encoding common sense properties of such beliefs leads uniquely to a set of rules for

manipulating degrees of belief that are equivalent to the sum and product rules of probability.

因此之故,我们才可以 use the machinery of probability theory to describe the uncertainty in

model parameters.

2.

( | )() ( | )()

(|)

()

( | )()

pD wpw pD wpw

pw D

pD

p D w p w dw

= =

∫

对parameter的观点,以及Bayesian对先验、后验概率的解释

对于 Frequentist 来说,model parameter w 是一个 fixed 的量,用“estimator”来估计;最常

见的 estimator 是 likelihood。

对 Bayesian 来说,w 本身是一个不确定量,其不确定性用 prior probability p(w)表示。

为了获知 fixed 的 w,Frequentist 进行重复多次的试验,获得不同的 data sets D;

对于 Bayesian 而言,there is only a single data set D, namely the one that is actually observed.

在得到一个 observation D 后,贝叶斯学派要调整原来对于 w 的 belief(prior probability),用

后验概率 P(w|D)表示调整后的 belief。调整的方法是贝叶斯定理。

Bayesian 的中心定理是贝叶斯定理,该定理 convert a prior probability into a posterior

probability by incorporating the evidence provided by the observed data。其中的条件概率 P(D|w)

表示的是,how probable the observed data set is for different settings of parameter vector w。

其中分母里的 p(D)只是用于归一化的量,使得 p(w|D)确实是一个概率。而 p(D)的计算已经

给出在上面的分母中。

(理解后验概率:即修正后的先验概率。例如,有

C1,…,Ck

个类别,先验为

P(C1)

,

…

,

P(Ck)

,这个时候如果给一个未知类别的数据让我们猜它是哪个类别,显然应该猜先验概率

最大的那个类别。在观察到数据

x

后,计算后验概率

P(C1|x)

,

…

,

P(Ck|x)

;于是此时的“先

验”修正为

P’(C1)=P(C1|x)

,

…

,

P’(Ck)=P(Ck|x)

。如果现在再来一个未知类别的数据让我

们猜,我们猜的方法仍旧是找先验概率最大的那个类别,只不过此时的先验概率是

P’(C1)

,

…

,

P’(Ck)

。)

3.

Bayesian和Frequentist的缺点

Bayesian 常受的批评之一:prior distribution is often selected on the basis of mathematical

convenience rather than as a reflection of any prior beliefs。 例如常选择 conjugate prior。

Frequentist 方法的缺点:Over-fitting problem can be understood as a general property of

maximum likelihood。

4.

应对over-fitting问题

Frequentist 控制 over-fitting 的方法:

1) regularization,即在目标函数中加入一个 penalty term。

L2 regularizer 被称为 ridge regression

L1 regularizer 被称为 Lasso regression

加入 penalty 的方法也叫 shrinkage method,因为它可以 reduce the value of the coefficients.

2) cross-validation,即留出一部分数据做 validation

Cross-validation 也是一种进行 model selection 的方法。利用留出来的 validation data,可以

选择多个所训练 model 中的最好的一个。

Bayesian 控制 over-fitting 的方法:Prior probability

5.

Bayesian方法面临的主要问题:marginalization计算困难

Marginalization lies at the heart of Bayesian methods.

Bayesian methods 的应用长期受制于 marginalization。对于一个 full Bayesian procedure 来

说, 要 make prediction 或 compare different models,必要的一步是 marginalize (sum or integrate)

over the whole of parameter space.

两方面发展起来的方法克服了做 marginalization 的困难:

第一种是 sampling,例 如 Markov chain Monte Carlo。Monte Carlo method 的优点是 flexible

而广泛用于各种 model 中;缺点是 computationally intensive,主要用于 small-scale problems.

第二种是 deterministic approximation,例如 variational Bayes 和 expectation propagation,优

点是可用于 large-scale applications.

6.

2) MAP (poor man’s bayes),引入 prior probability,对 posterior probability 求最大值,得到

w。MAP 此时相当于在 MLE 的目标函数(likelihood function)中加入一个 L2 penalty。该方

Curve fitting为例子演示三种方法

1) MLE,直 接对 likelihood function 求最大值,得到参数 w。该方法属于 point estimation。

剩余76页未读,继续阅读

zhaolu2009

- 粉丝: 4

- 资源: 13

上传资源 快速赚钱

我的内容管理

收起

我的内容管理

收起

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

会员权益专享

最新资源

- stc12c5a60s2 例程

- Android通过全局变量传递数据

- c++校园超市商品信息管理系统课程设计说明书(含源代码) (2).pdf

- 建筑供配电系统相关课件.pptx

- 企业管理规章制度及管理模式.doc

- vb打开摄像头.doc

- 云计算-可信计算中认证协议改进方案.pdf

- [详细完整版]单片机编程4.ppt

- c语言常用算法.pdf

- c++经典程序代码大全.pdf

- 单片机数字时钟资料.doc

- 11项目管理前沿1.0.pptx

- 基于ssm的“魅力”繁峙宣传网站的设计与实现论文.doc

- 智慧交通综合解决方案.pptx

- 建筑防潮设计-PowerPointPresentati.pptx

- SPC统计过程控制程序.pptx

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功

评论5