深度学习中的注意力机制解析

需积分: 43 50 浏览量

更新于2023-05-05

3

收藏 6.44MB PDF 举报

"《注意力机制》教程是一份深入探讨注意力机制在神经网络中应用的112页PPT,由Jus$n Johnson于2020年10月14日发布。教程涵盖了广泛的话题,包括PyTorch的自动梯度、循环网络、注意力机制、网络可视化(如显著性映射和对抗性示例)、特征反转以及艺术风格迁移。此外,还提及了一个在线进行的中期考试安排,考试时长为90分钟,考生可以在24小时的窗口期内自由选择时间,并允许使用笔记。考试形式包括真假判断、多选题和简答题,对于涉及数学的简答题,可以用LaTeX书写或上传手写图片。"

在深度学习领域,注意力机制是一个关键的概念,它模拟了人类视觉和认知系统中集中注意力的能力,从而让模型在处理大量信息时能够有选择地关注重要部分。这份教程详细阐述了这一机制的历史、应用和当前的研究挑战。注意力机制最初在自然语言处理中被引入,通过分配不同的权重来处理输入序列的不同部分,使得模型能够更有效地理解和生成复杂的文本。

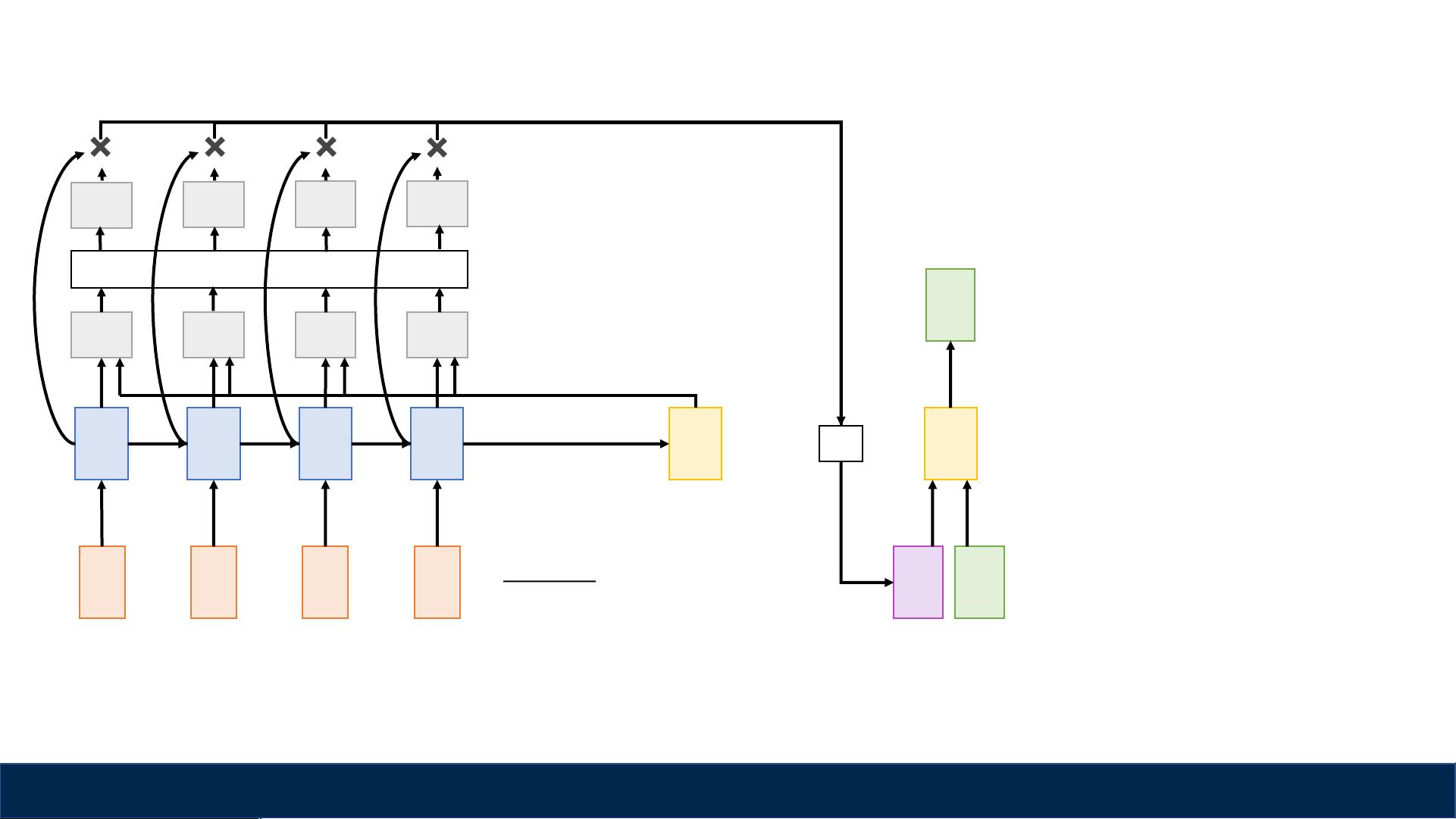

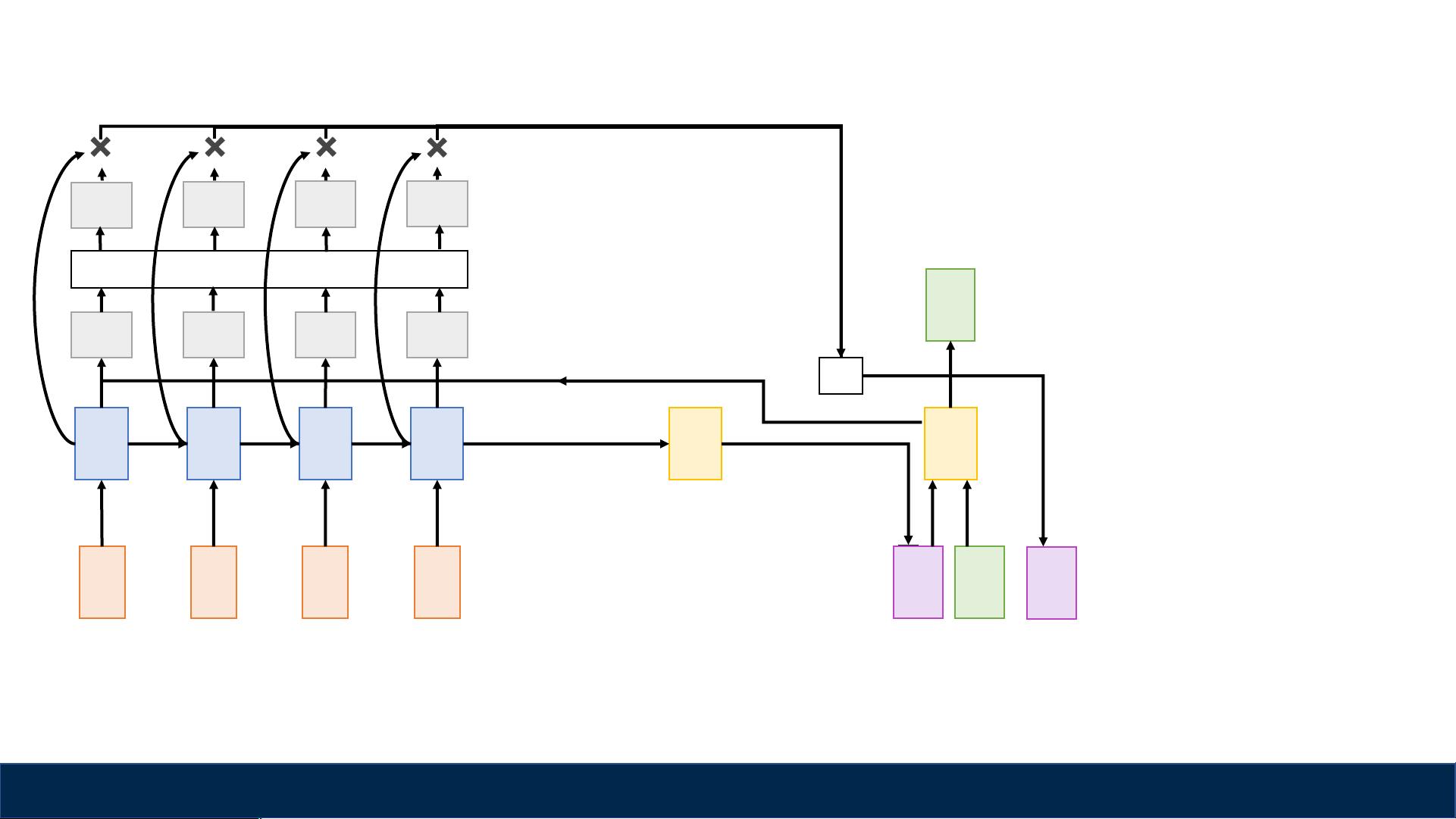

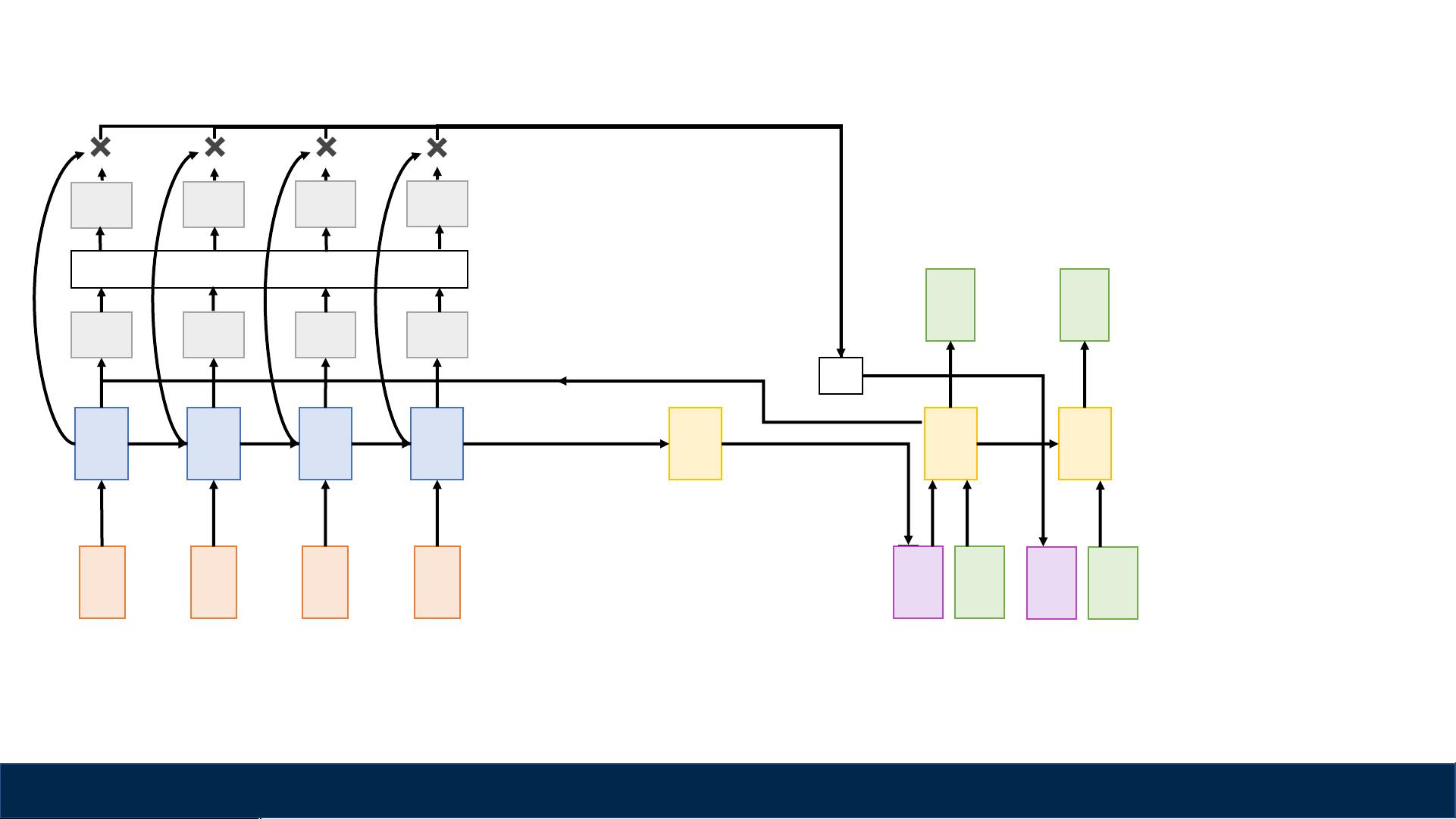

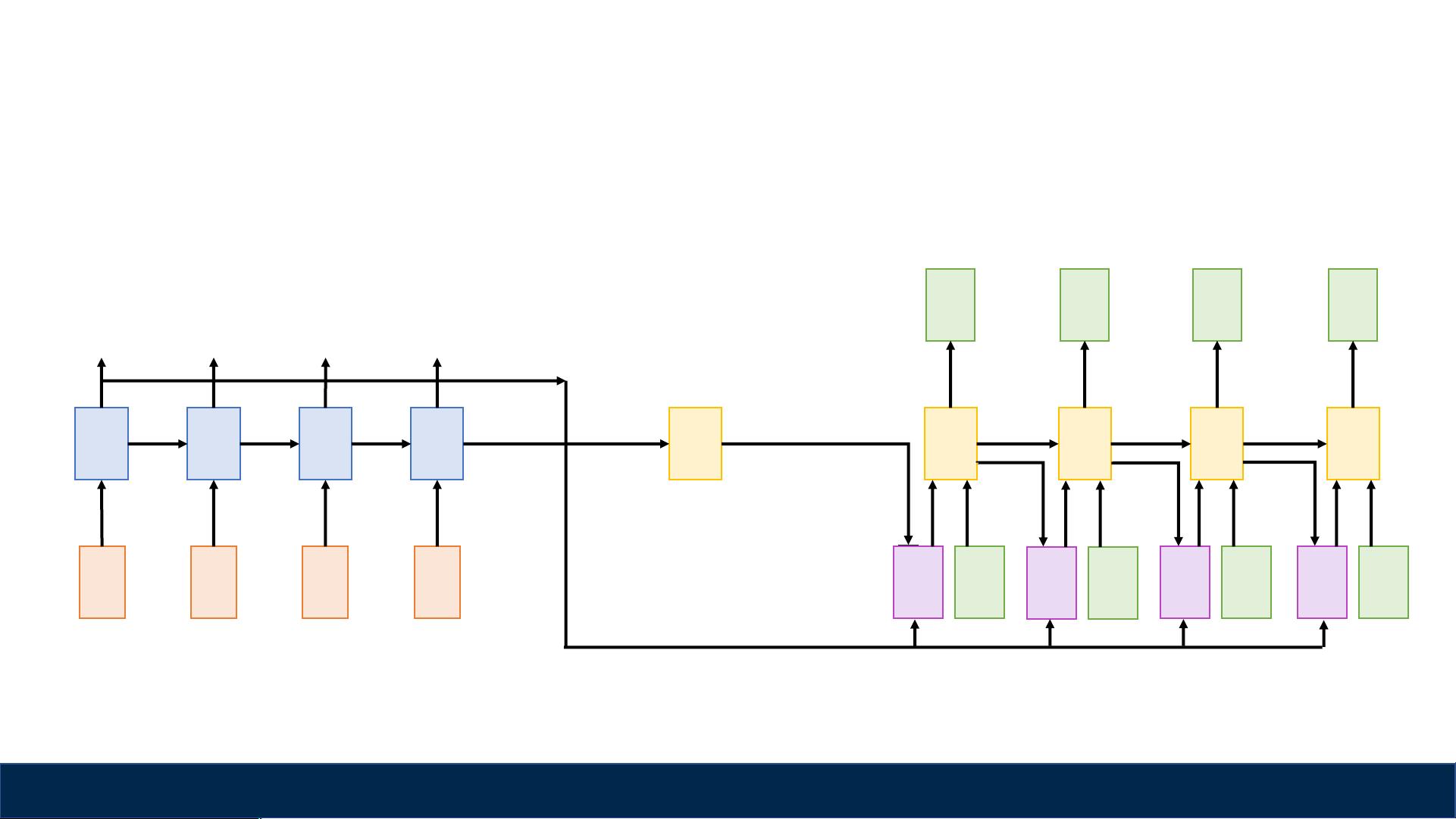

注意力机制有多种实现方式,如软注意力和硬注意力。软注意力允许模型以连续的方式分配权重,而硬注意力则采用二进制决策,将权重集中在单个位置。在循环神经网络(RNN)中,注意力机制能帮助解决长期依赖问题,使模型在处理长序列时依然保持性能。

教程中提到的PyTorch Autograd是PyTorch框架中的自动求梯度模块,它使得神经网络的反向传播过程自动化,简化了模型训练的流程。循环网络,如长短时记忆网络(LSTM)和门控循环单元(GRU),是利用注意力机制的理想平台,因为它们能够处理变长序列并记住上下文信息。

网络可视化部分,如显著性映射,展示了模型在做出决策时重点关注的输入区域,这对于理解模型行为和调试非常重要。对抗性示例和特征反转则涉及到模型的鲁棒性和理解,前者通过构造误导性的输入来测试模型的弱点,后者尝试从模型的输出反向构建输入图像。

艺术风格迁移是计算机视觉中的一个有趣应用,它使用注意力机制和其他技术将一幅图像的内容与另一幅图像的风格结合起来,创造出全新的艺术作品。这些话题的涵盖表明这份教程不仅理论深入,而且实践性强,适合对深度学习和注意力机制感兴趣的学者和开发者参考学习。

4513 浏览量

1302 浏览量

2021-09-29 上传

119 浏览量

2021-10-04 上传

2021-09-29 上传

2022-06-18 上传

2010-10-13 上传

syp_net

- 粉丝: 158

最新资源

- 小学水墨风学校网站模板设计

- 深入理解线程池的实现原理与应用

- MSP430编程代码集锦:实用例程源码分享

- 绿色大图幻灯商务响应式企业网站开发源码包

- 深入理解CSS与Web标准的专业解决方案

- Qt/C++集成Google拼音输入法演示Demo

- Apache Hive 0.13.1 版本安装包详解

- 百度地图范围标注技术及应用

- 打造个性化的Windows 8锁屏体验

- Atlantis移动应用开发深度解析

- ASP.NET实验教程:源代码详细解析与实践

- 2012年工业观察杂志完整版

- 全国综合缴费营业厅系统11.5:一站式缴费与运营管理解决方案

- JAVA原生实现HTTP请求的简易指南

- 便携PDF浏览器:随时随地快速查看文档

- VTF格式图片编辑工具:深入起源引擎贴图修改