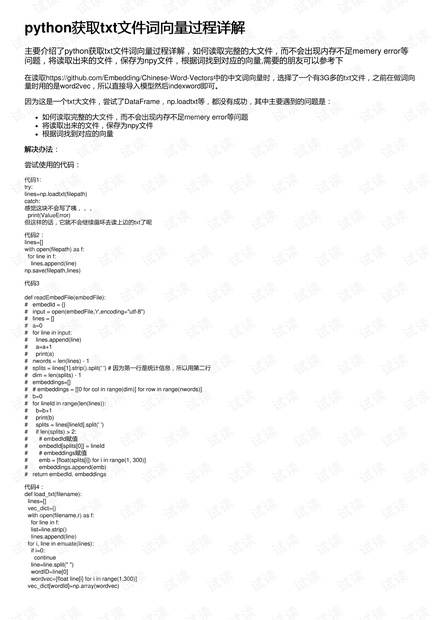

python获取获取txt文件词向量过程详解文件词向量过程详解

主要介绍了python获取txt文件词向量过程详解,如何读取完整的大文件,而不会出现内存不足memery error等

问题,将读取出来的文件,保存为npy文件,根据词找到对应的向量,需要的朋友可以参考下

在读取https://github.com/Embedding/Chinese-Word-Vectors中的中文词向量时,选择了一个有3G多的txt文件,之前在做词向

量时用的是word2vec,所以直接导入模型然后indexword即可。

因为这是一个txt大文件,尝试了DataFrame,np.loadtxt等,都没有成功,其中主要遇到的问题是:

如何读取完整的大文件,而不会出现内存不足memery error等问题

将读取出来的文件,保存为npy文件

根据词找到对应的向量

解决办法解决办法:

尝试使用的代码:

代码1:

try:

lines=np.loadtxt(filepath)

catch:

感觉这块不会写了咦,,,

print(ValueError)

但这样的话,它就不会继续循环去读上边的txt了呢

代码2:

lines=[]

with open(filepath) as f:

for line in f:

lines.append(line)

np.save(filepath,lines)

代码3

def readEmbedFile(embedFile):

# embedId = {}

# input = open(embedFile,'r',encoding="utf-8")

# lines = []

# a=0

# for line in input:

# lines.append(line)

# a=a+1

# print(a)

# nwords = len(lines) - 1

# splits = lines[1].strip().split(' ') # 因为第一行是统计信息,所以用第二行

# dim = len(splits) - 1

# embeddings=[]

# # embeddings = [[0 for col in range(dim)] for row in range(nwords)]

# b=0

# for lineId in range(len(lines)):

# b=b+1

# print(b)

# splits = lines[lineId].split(' ')

# if len(splits) > 2:

# # embedId赋值

# embedId[splits[0]] = lineId

# # embeddings赋值

# emb = [float(splits[i]) for i in range(1, 300)]

# embeddings.append(emb)

# return embedId, embeddings

代码4:

def load_txt(filename):

lines=[]

vec_dict={}

with open(filename,r) as f:

for line in f:

list=line.strip()

lines.append(line)

for i, line in emuate(lines):

if i=0:

continue

line=line.split(" ")

wordID=line[0]

wordvec=[float line[i] for i in range(1,300)]

vec_dict[wordId]=np.array(wordvec)

评论0