理解循环神经网络(RNN):从1-of-N编码到LSTM

需积分: 9 17 浏览量

更新于2023-05-19

收藏 3.79MB PDF 举报

"本文主要介绍了循环神经网络(RNN)在机器学习中的应用,包括词槽填充示例、1-of-N编码以及超越1-of-N编码的解决方案,还提及了RNN的不同变体如Elman网络、Jordan网络、双向RNN以及长短期记忆网络(LSTM)。"

在机器学习领域,循环神经网络(RNN)是一种具有递归结构的深度学习模型,特别适合处理序列数据,例如自然语言处理任务。RNN的主要特点是其内部状态能够捕获序列的上下文信息,这使得它们在诸如语言建模、机器翻译、情感分析和对话系统等任务中表现出色。

**示例应用:词槽填充**

词槽填充是一个典型的自然语言理解任务,例如在语音识别或聊天机器人中,系统需要理解用户的意图并填充特定的词槽,如目的地、到达时间等。在例子中,用户说"I would like to arrive Taipei on November 2nd.",系统需要识别出"Taipei"是目的地,"November 2nd"是到达时间。

**1-of-N编码**

在早期的RNN应用中,词汇表中的每个单词通常通过1-of-N编码表示,也称为one-hot编码。在这个编码方式中,每个单词被表示为一个向量,向量的长度等于词汇表大小,只有对应单词的位置是1,其他位置都是0。例如,词汇表包含"apple", "bag", "cat", "dog", "elephant",那么"apple"的编码就是[1, 0, 0, 0, 0]。

**超越1-of-N编码**

然而,1-of-N编码存在局限性,它忽略了词与词之间的相似性。为解决这个问题,可以采用词嵌入(word embeddings)技术,如词向量(Word2Vec)、GloVe等,这些方法将每个单词映射到一个连续的向量空间,使语义相近的词在向量空间中靠近。另一种方法是使用词哈希(word hashing),它可以有效地处理大量词汇,但可能会引入“其他”维度来捕获未见过的词。

**RNN的变体**

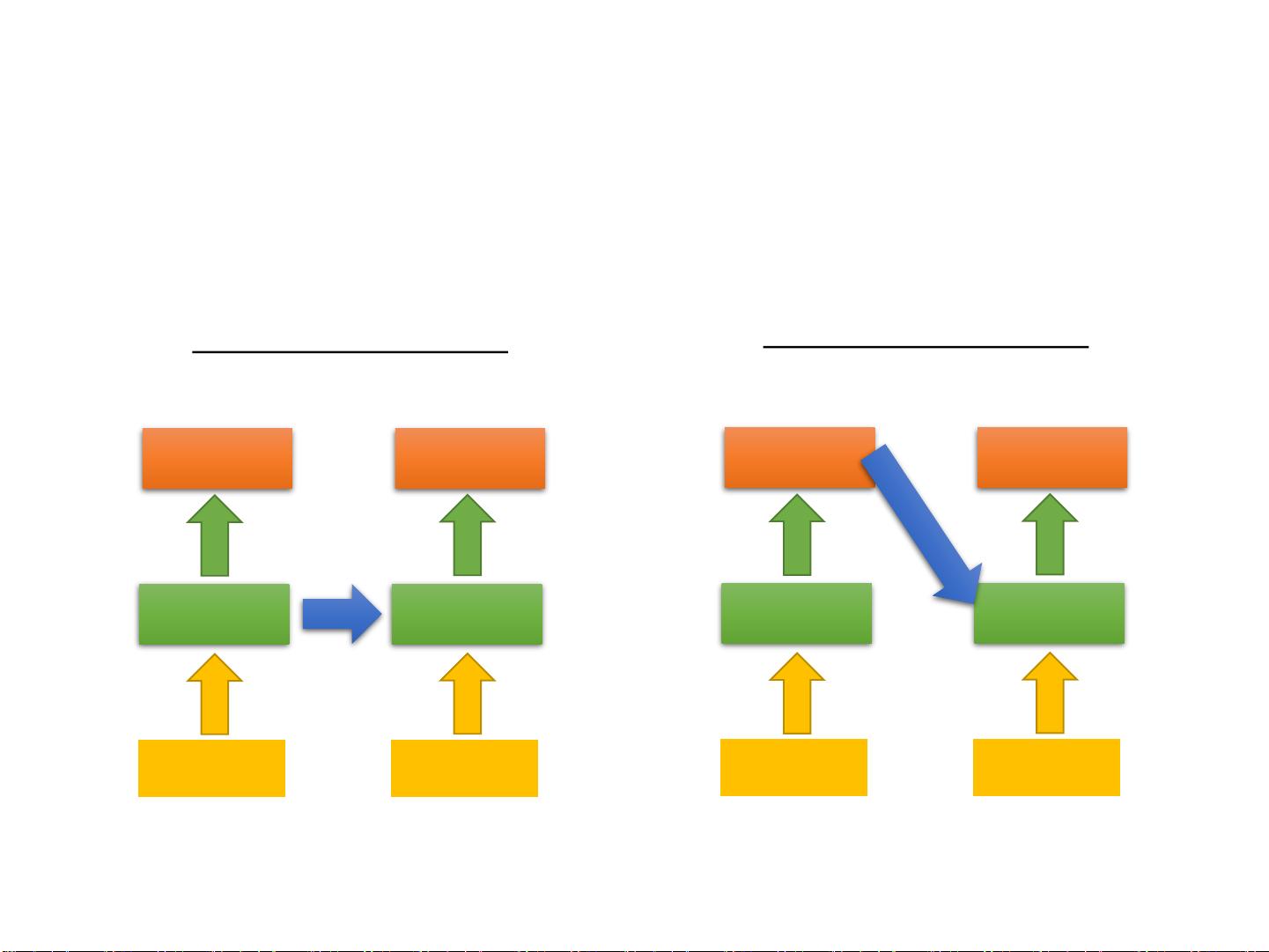

- **Elman网络**:是最早的RNN形式之一,通过一个简单的反馈连接来保留过去的信息。

- **Jordan网络**:与Elman网络类似,但输入层连接到隐藏层的循环,使得RNN能更好地处理先发生事件对当前输出的影响。

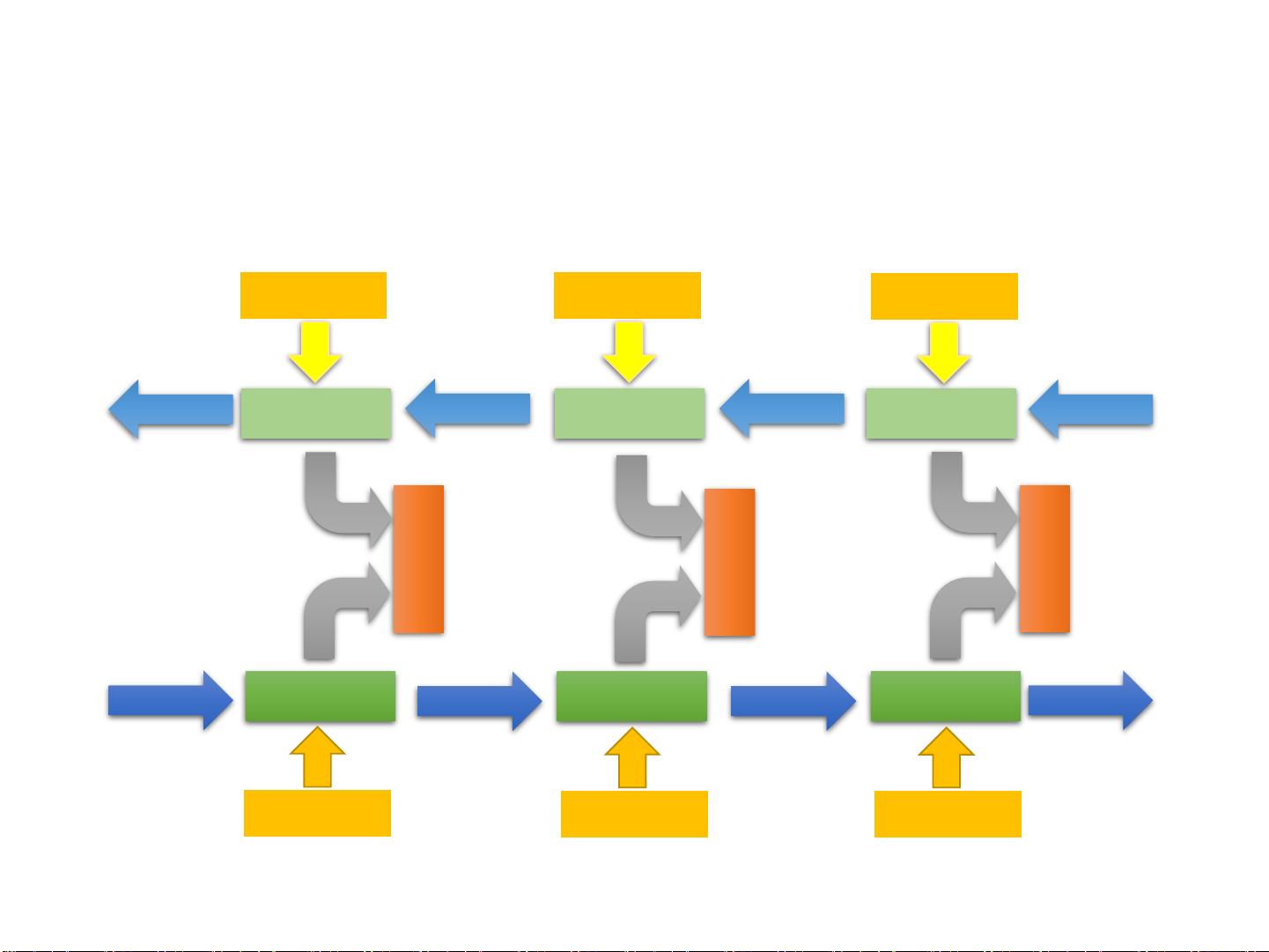

- **双向RNN**:结合了前向和后向RNN,可以同时利用过去的和未来的上下文信息。

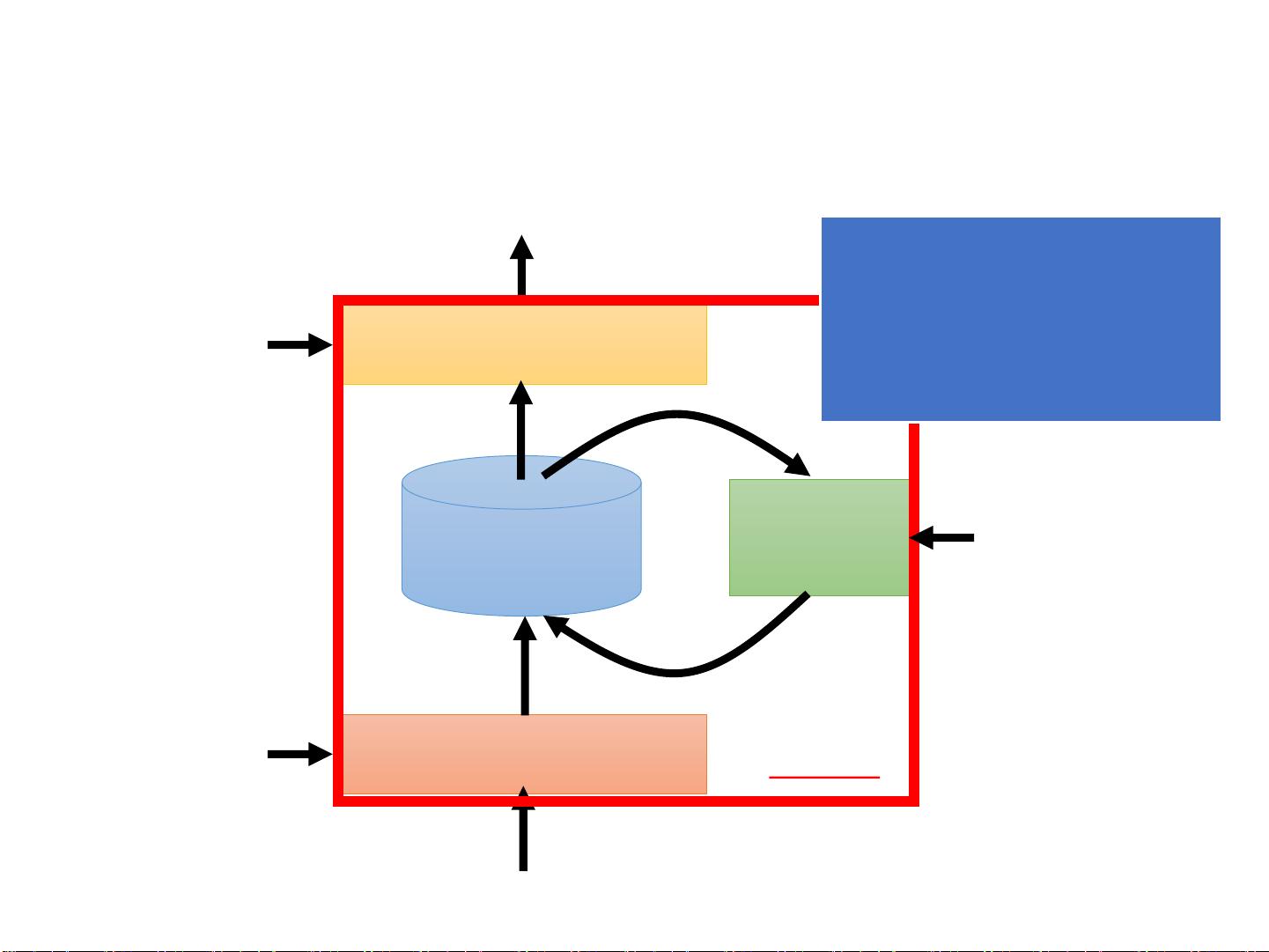

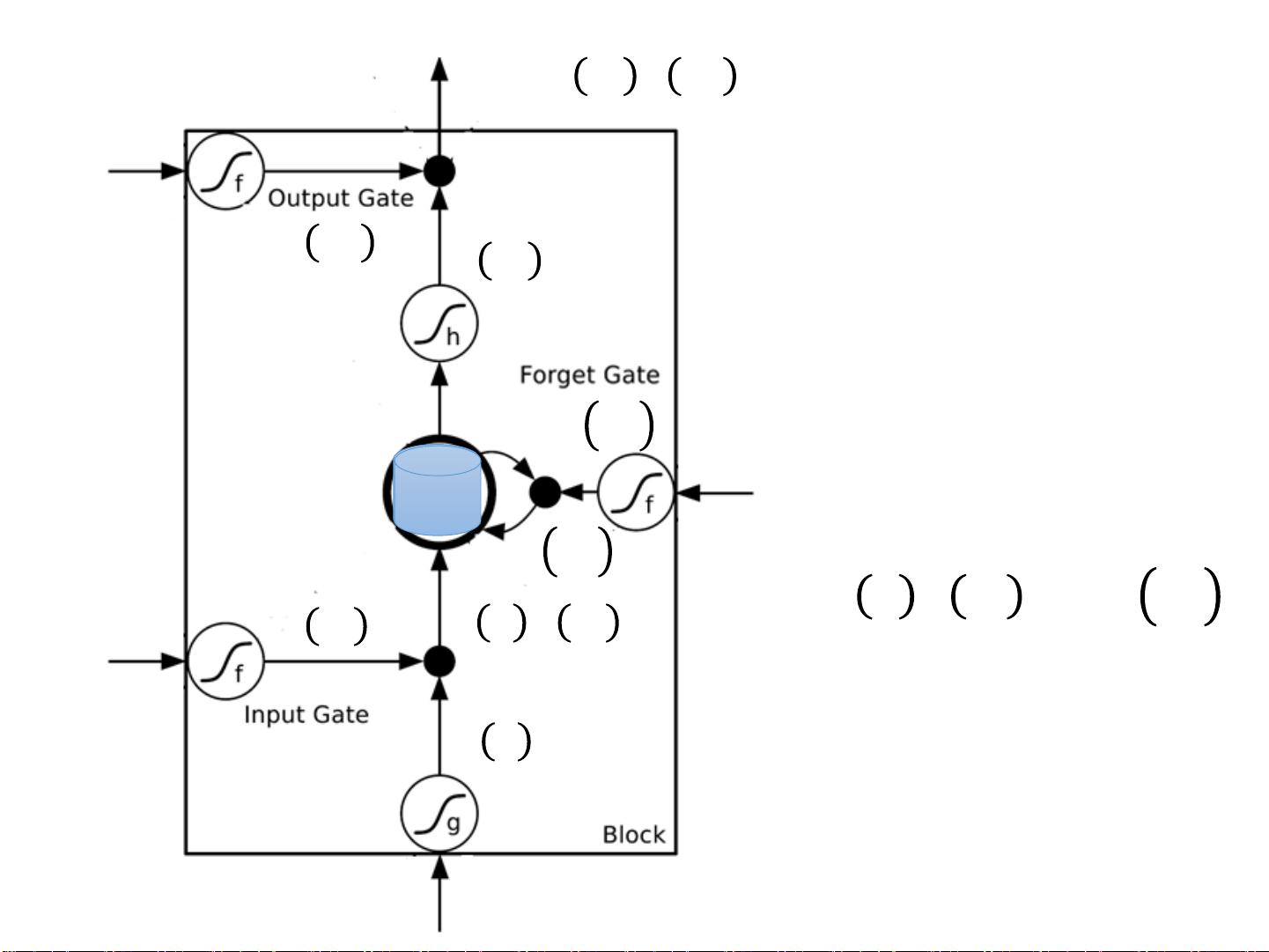

- **长短期记忆网络(LSTM)**:为了解决传统RNN的梯度消失问题,LSTM引入了门控机制,能够更有效地捕获长期依赖,成为现代NLP任务中广泛使用的模型。

通过以上讨论,我们可以看到RNN及其变体在处理序列数据时的强大能力,尤其在处理语言等复杂序列任务中,RNN的动态记忆特性使其在机器学习领域占有重要地位。

2018-11-12 上传

2018-06-19 上传

2023-02-28 上传

2023-06-09 上传

2023-04-22 上传

2023-05-12 上传

2023-05-25 上传

2024-02-05 上传

fdtsaid

- 粉丝: 146

- 资源: 88

最新资源

- IPQ4019 QSDK开源代码资源包发布

- 高频组电赛必备:掌握数字频率合成模块要点

- ThinkPHP开发的仿微博系统功能解析

- 掌握Objective-C并发编程:NSOperation与NSOperationQueue精讲

- Navicat160 Premium 安装教程与说明

- SpringBoot+Vue开发的休闲娱乐票务代理平台

- 数据库课程设计:实现与优化方法探讨

- 电赛高频模块攻略:掌握移相网络的关键技术

- PHP简易简历系统教程与源码分享

- Java聊天室程序设计:实现用户互动与服务器监控

- Bootstrap后台管理页面模板(纯前端实现)

- 校园订餐系统项目源码解析:深入Spring框架核心原理

- 探索Spring核心原理的JavaWeb校园管理系统源码

- ios苹果APP从开发到上架的完整流程指南

- 深入理解Spring核心原理与源码解析

- 掌握Python函数与模块使用技巧