LabVIEW性能优化:内存管理与执行系统深入解析

需积分: 50 197 浏览量

更新于2023-05-19

收藏 392KB PPTX 举报

在"LabVIEW性能优化与内存管理"的研讨中,Adam Kemp,作为LabVIEW编译器团队的软件工程师,引导我们深入理解LabVIEW的执行系统。LabVIEW是一款独特且强大的编程环境,其执行系统负责实际运行代码,提供了自动并行处理的能力,区别于其他需要手动线程管理的语言。通过优化代码来提升性能是关键,主要方法包括减少数据复制和整体内存消耗。

首先,了解LabVIEW执行系统的运行原理是优化的基础。这个系统就像一个工作池,包含一个任务队列和一组线程,它们按照特定顺序处理来自队列的工作单元,即VI代码片段(称为"queue elements")。每个执行系统都可能拥有多个线程,比如UI、标准、仪器I/O、数据采集等,但用户界面(UI)部分通常只有一条主线程,确保了图形用户界面的响应性和一致性。

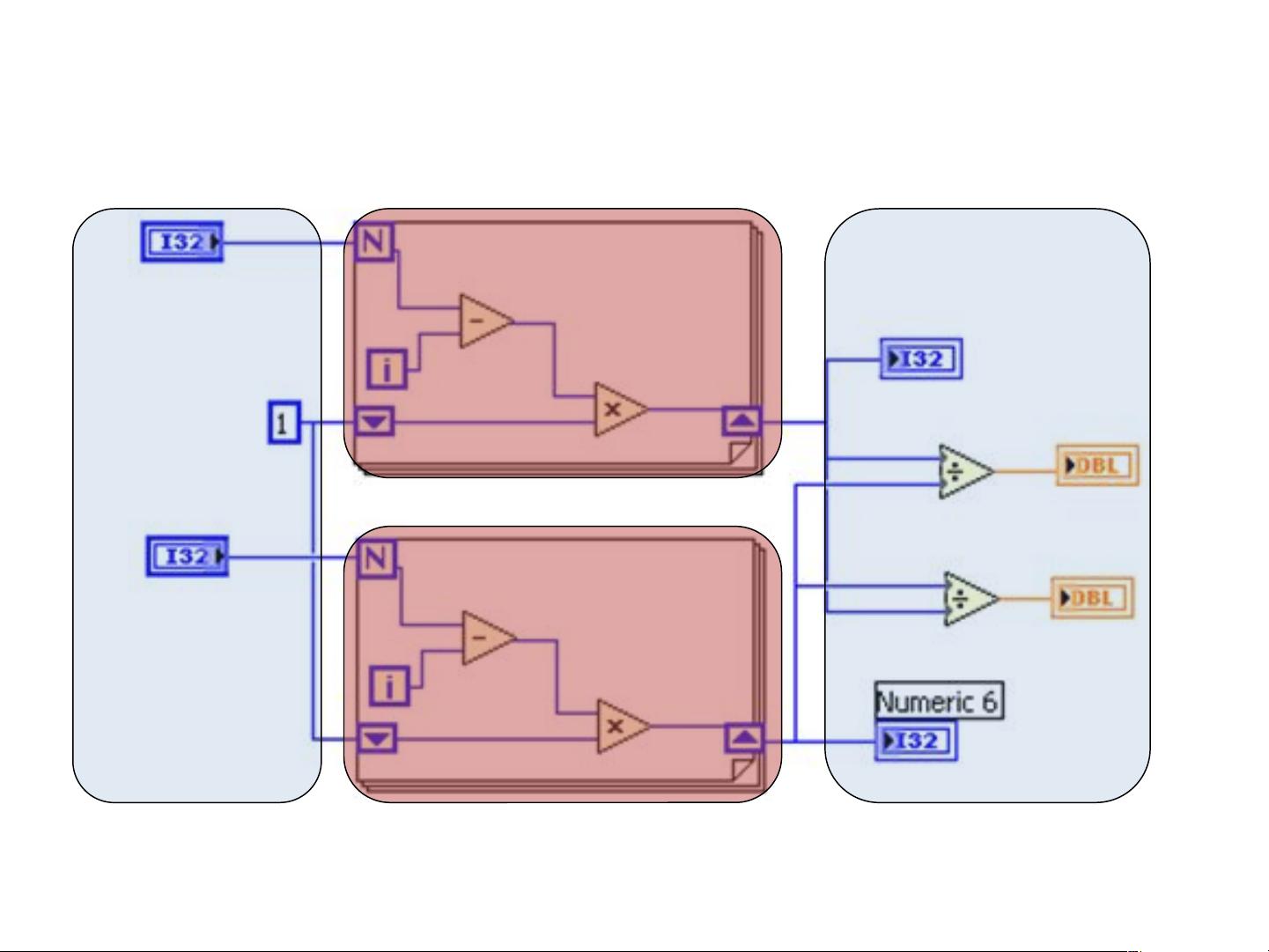

在代码执行过程中,LabVIEW采用了"clumping algorithm",这是一种特殊的任务调度策略。它将程序流程划分为不同的"clump"(簇),根据优先级和可用性进行执行。当图(VI diagram)开始时,会读取控件,然后按照clump的逻辑分组执行,直到整个图完成,显示指标后程序退出。在这个过程中,不同clump之间的睡眠状态管理和调度对性能有显著影响。

优化策略主要包括:

1. **减少数据复制**:避免不必要的数据拷贝可以节省时间和内存资源。通过合理的数据结构设计和引用传递,减少内存中的副本。

2. **内存管理**:理解LabVIEW内存分配模式,及时释放不再使用的变量和数据结构,以降低内存占用。此外,可以通过设置合适的数据类型和规模来限制内存使用。

3. **利用并行性**:利用LabVIEW的多线程特性,将能并行处理的任务分解到不同的执行系统中,提高程序运行效率。

4. **分析和调整VI执行属性**:理解每个VI的执行特性,如执行时间、资源需求等,有助于优化整体程序流程。

5. **合理使用timed loops**:避免在UI线程中长时间运行循环,可能导致界面冻结。应将耗时操作放在非阻塞或后台线程中执行。

通过深入理解LabVIEW执行系统的工作原理,开发者能够针对具体场景采取有效的性能优化措施,同时注意内存管理,以实现更高效、更稳定的代码运行。这在处理大型复杂项目或实时应用时尤其重要,能够帮助提升用户体验和整体系统的可靠性。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2011-08-13 上传

2021-10-05 上传

2023-06-20 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

hui198780916

- 粉丝: 3

- 资源: 8

最新资源

- CoreOS部署神器:configdrive_creator脚本详解

- 探索CCR-Studio.github.io: JavaScript的前沿实践平台

- RapidMatter:Web企业架构设计即服务应用平台

- 电影数据整合:ETL过程与数据库加载实现

- R语言文本分析工作坊资源库详细介绍

- QML小程序实现风车旋转动画教程

- Magento小部件字段验证扩展功能实现

- Flutter入门项目:my_stock应用程序开发指南

- React项目引导:快速构建、测试与部署

- 利用物联网智能技术提升设备安全

- 软件工程师校招笔试题-编程面试大学完整学习计划

- Node.js跨平台JavaScript运行时环境介绍

- 使用护照js和Google Outh的身份验证器教程

- PHP基础教程:掌握PHP编程语言

- Wheel:Vim/Neovim高效缓冲区管理与导航插件

- 在英特尔NUC5i5RYK上安装并优化Kodi运行环境