Transformer驱动的KGE:序列到序列方法缩小模型规模,提升KGQA性能

150 浏览量

更新于2024-06-19

收藏 772KB PDF 举报

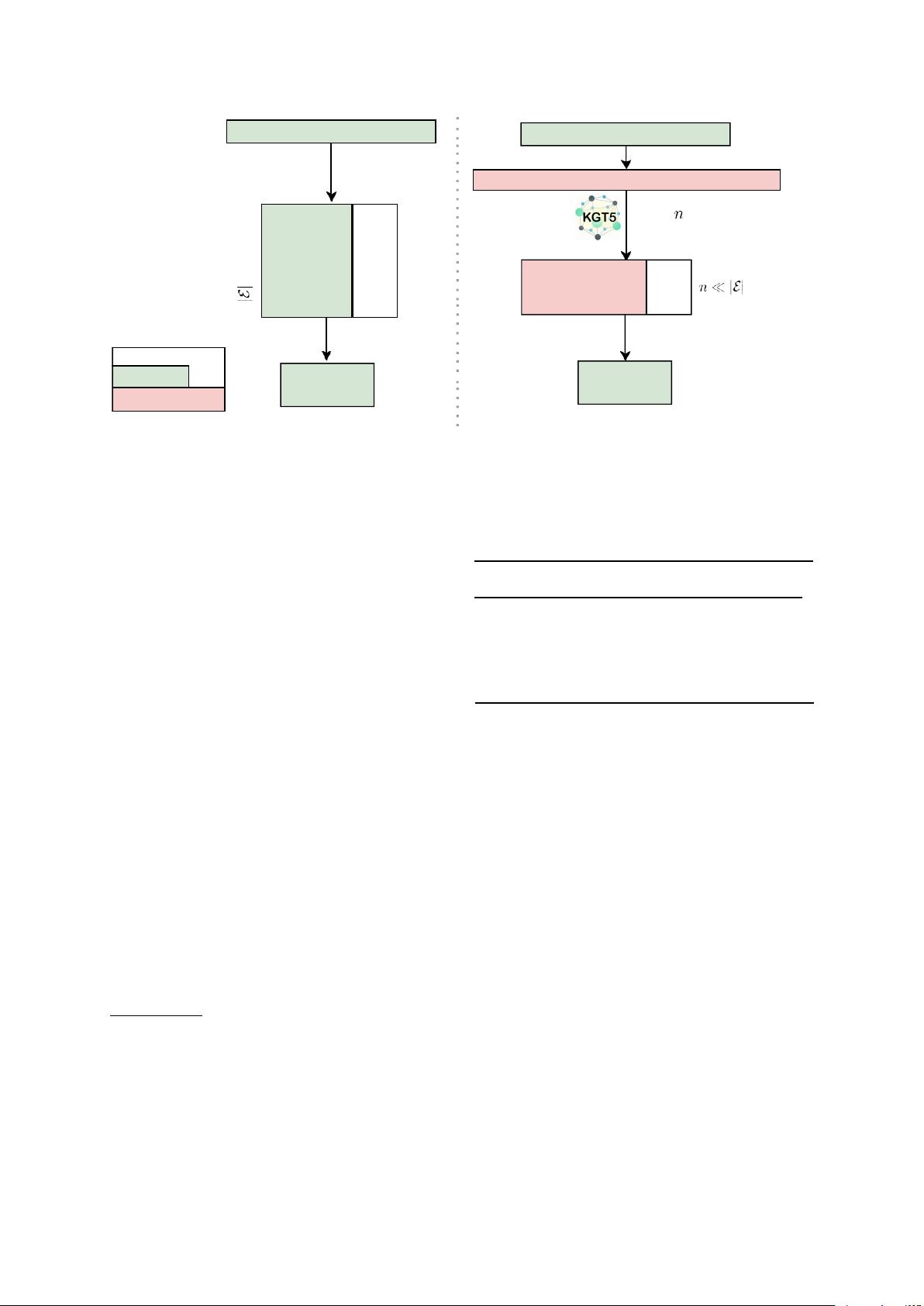

本文主要探讨了序列到序列(Sequence-to-Sequence, Seq2Seq)技术在知识图谱(Knowledge Graph, KG)领域的应用,特别是针对知识图的自动补全和问题分类。知识图嵌入(Knowledge Graph Embedding, KGE)模型是研究热点,它通过将实体和关系映射到低维向量空间中,实现KG中的实体和关系的有效表示。然而,传统KGE模型在处理大规模知识图时,由于每个实体都独立建模,导致模型规模庞大,不利于实际应用中的高效集成。

作者指出,Transformer模型,作为一种编码器-解码器架构,被证明能够作为一种扩展性和通用的KGE替代方案。他们创新地将KG链接预测任务转化为Seq2Seq形式,提出了使用交换的三重评分(Triple Scoring)方法,这种方法在自回归解码之前进行,显著缩小了模型大小,相比传统KGE方法,模型尺寸减少高达98%,同时保持了推理过程的效率。

此外,论文展示了在对不完整知识图进行KGQA(Knowledge Graph Question Answering)任务微调后,他们的方法在多个大规模数据集上表现出色,且不需要过多的超参数调优。这表明,Transformer-KGE模型在保持高效性的同时,能够更好地处理实际场景中的知识图谱挑战,具有广泛的应用潜力,如网络搜索、问答系统和推荐系统等知识密集型应用。

本研究的重要贡献在于将复杂的问题解决任务简化为可扩展的Seq2Seq框架,并证明了其在提升知识图谱处理能力、模型效率和实用性方面的优势。这对于推动知识图谱技术的发展以及提高其在实际应用中的表现具有重要意义。

2010-08-16 上传

149 浏览量

2023-04-17 上传

2021-03-11 上传

2021-04-01 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- freemarker中文手册

- 关于公平的竞赛评卷系统的研究

- NS2实例,Tcl语法

- ArcDGis9.2 系列产品介绍及开发

- 基于工作流的信息管理系统研究

- php常用算法(doc)

- 展望系统辨识(Perspectives on System Identification, by Ljung, 2008)

- 2009年信息系统项目管理师考试大纲

- 网管手册:三十五例网络故障排除方法

- 中望CAD2008标准教程

- ajax实战中文版.pdf

- C++ Templates 全览.pdf

- 串口通信编程大全.pdf

- 史上最全电脑键盘每个键的作用

- JavaScript.DOM编程

- Microsoft Visio详尽教程.pdf