决策树学习详解:分类与构建原理

需积分: 0 160 浏览量

更新于2024-08-05

收藏 1.11MB PDF 举报

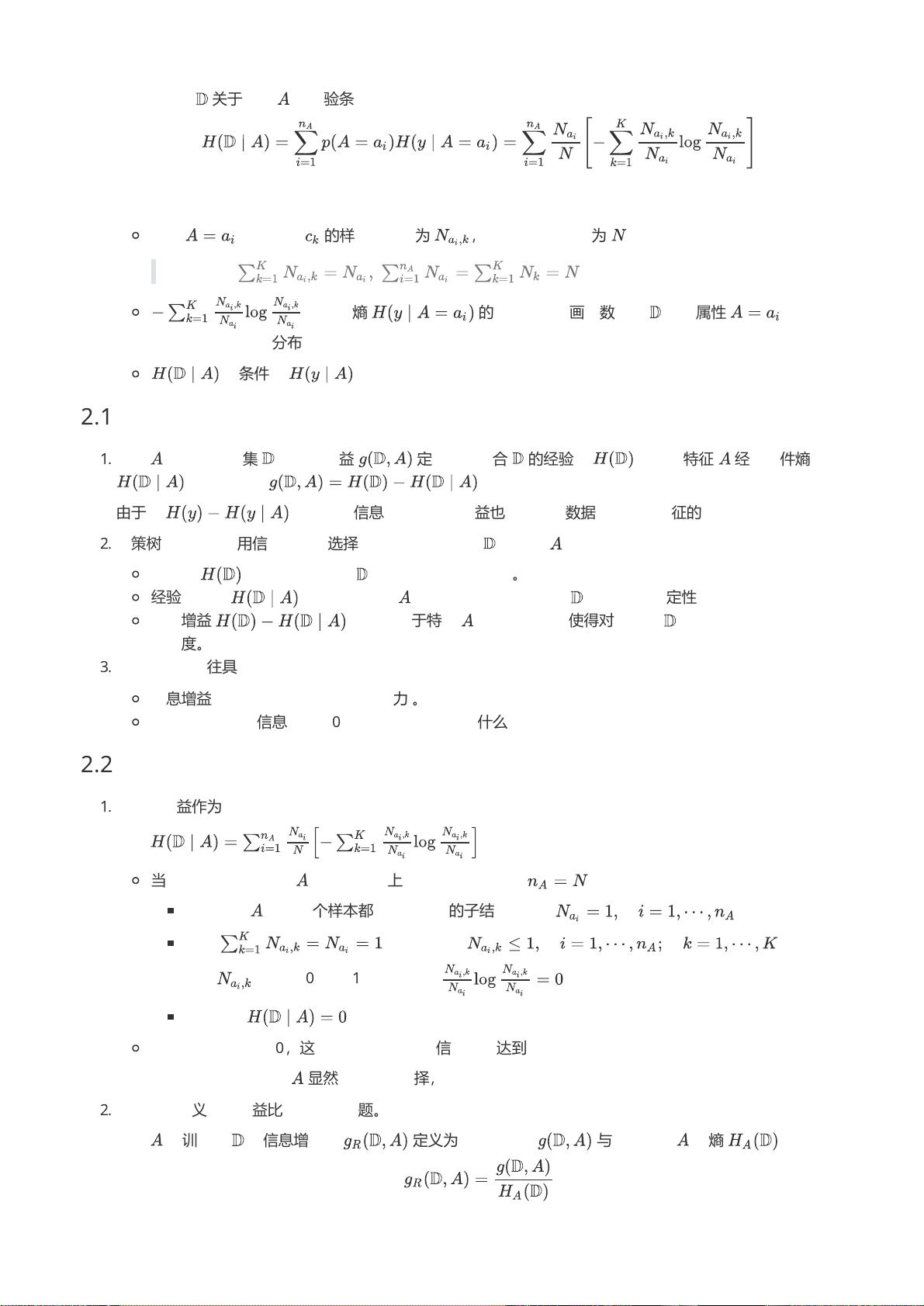

"决策树是一种基于树状结构进行分类和回归的机器学习算法,常用于数据分析和预测建模。它的模型由节点和有向边构成,其中内部节点代表特征或属性,叶子节点代表最终的分类结果。在分类过程中,决策树通过自顶向下地对样本进行特征测试,按照测试结果将样本分配到相应的子节点,直至达到叶子节点,从而完成分类。此过程形成了互斥且完备的分类路径。决策树学习主要包括特征选择、决策树生成和决策树剪枝三个步骤。

决策树的优点在于其模型直观易懂,便于解释,同时分类效率高。在特征选择阶段,算法会选择最具区分度的特征来划分数据;决策树生成时,算法会递归地将数据集分割成更小的部分,直到满足停止条件,如达到预设的最小叶子节点数或所有样本属于同一类别等。决策树剪枝则是为了防止过拟合,通过牺牲一定的泛化能力来提高模型的稳定性和泛化性能。

损失函数最小化是决策树优化的主要策略,通常采用正则化的极大似然估计。然而,寻找最优决策树是一个NP完全问题,因此实践中多采用启发式算法,如ID3、C4.5、CART等,它们可以生成近似的次优决策树。这些算法在每次分裂时选择最优特征,依据信息增益、基尼不纯度或其他相似度度量标准。

在实际应用中,决策树可以单独使用,也可以作为集成学习方法的一部分,如随机森林和梯度提升机。随机森林通过构建多个决策树并取多数投票或平均预测结果来提高模型的准确性和鲁棒性,而梯度提升机则逐步迭代地添加决策树,每棵树专注于纠正前一棵树的错误,从而实现整体性能的提升。

决策树是一种强大的工具,适用于多种类型的数据和任务,尤其适合处理具有离散特征的分类问题。通过理解和掌握决策树的基本原理和算法,可以有效地解决许多实际问题,并为后续的深度学习和复杂模型提供基础。"

2020-06-27 上传

2024-08-30 上传

2021-08-09 上传

2024-06-13 上传

2023-06-11 上传

2023-06-08 上传

2023-06-12 上传

2022-08-03 上传

2022-07-15 上传

Crazyanti

- 粉丝: 26

- 资源: 302

最新资源

- MyBib: Free Citation Generator-crx插件

- 世界语:已弃用:一种将ES6模块转换为AMD和CommonJS的简便方法

- PyPI 官网下载 | templ8-1.1.1.tar.gz

- jiaozhi.zip_VHDL/FPGA/Verilog_Others_

- udemyPetrachenko

- AndroidVSCode:带有Termux上代码服务器的Android上的Visual Studio Code

- iScroll2-开源

- 爱心公益儿童html5网站模板

- 参考资料-中国书法史话.zip

- SW-CD-HMI-V0.9.rar_Windows_CE_Visual_C++_

- tkdn_vault_site

- dispatch-action:GitHub行动免费部署合并给利益相关者的电子邮件

- wp-dbmanager:允许您优化数据库,修复数据库,备份数据库,还原数据库,删除备份数据库,空表和运行选定的查询。 支持自动计划备份,优化和修复数据库

- sigil.github.io:印记

- repeat-aware:脚手架工具的重复感知性能评估

- hamburgerMenu:Html Css ve Javascript ile Hamburger Menuyapımı