矩阵分解与图模型基础解析

"矩阵分解与图模型导论(Slides)"

在本次微软专家Lei Zhang主讲的矩阵分解与图模型的介绍中,主要涵盖了两个核心主题:矩阵分解及其应用,以及图模型的基础概念。这份资料是针对机器学习初学者的一份优秀教程,通过讲解这些基础理论,帮助读者更好地理解数据表示和建模方法。

首先,矩阵分解是数据分析和机器学习领域中的一个关键工具。矩阵分解旨在将大而复杂的矩阵拆解为多个较简单矩阵的乘积,以揭示隐藏的结构和模式。具体来说,它包括了主成分分析(PCA)、奇异值分解(SVD)和非负矩阵分解(NMF)等方法。

1. 主成分分析(PCA)是一种常见的降维技术,通过寻找数据方差最大的方向来压缩数据,保留主要特征,同时减少噪声和冗余信息。

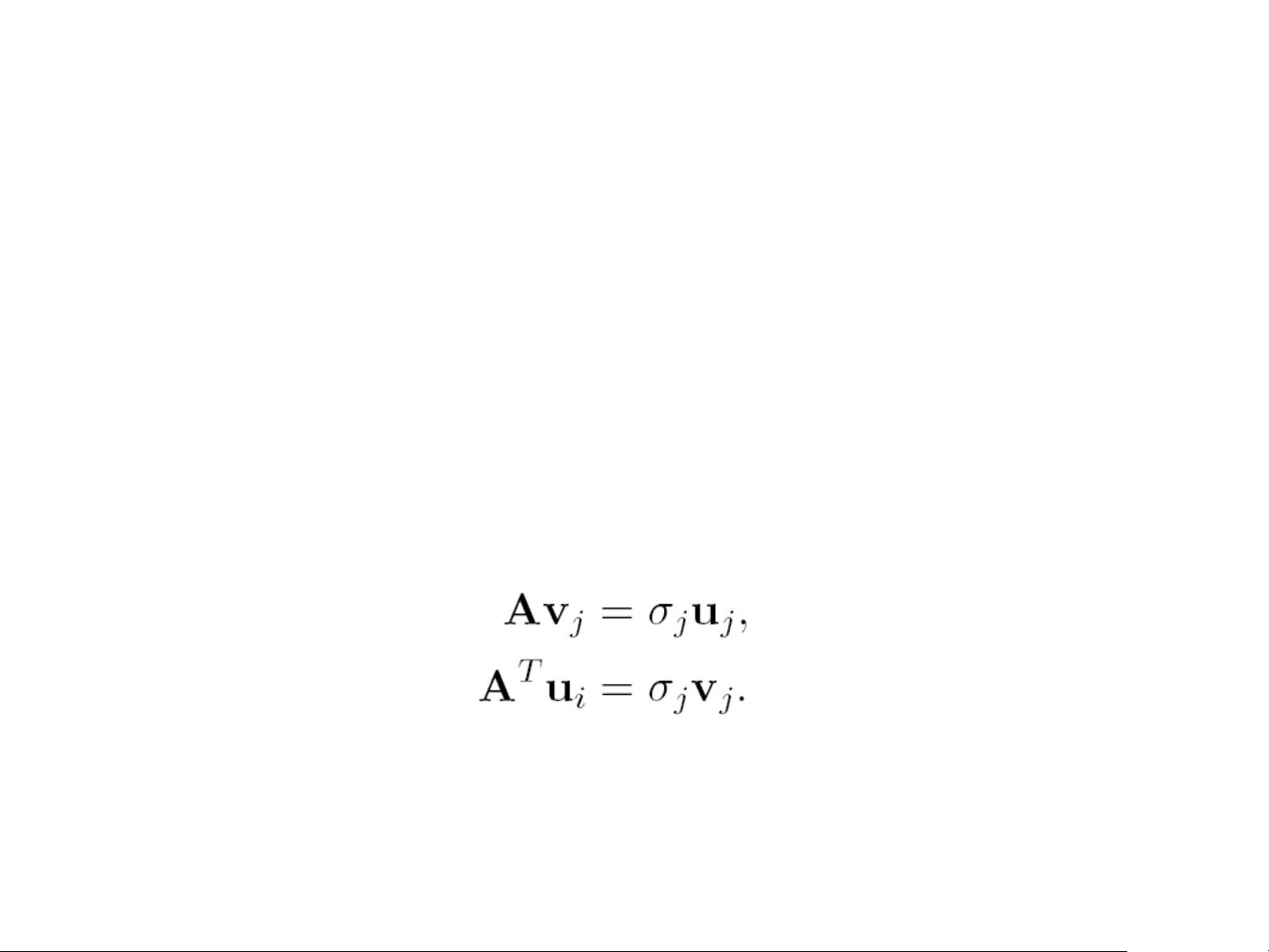

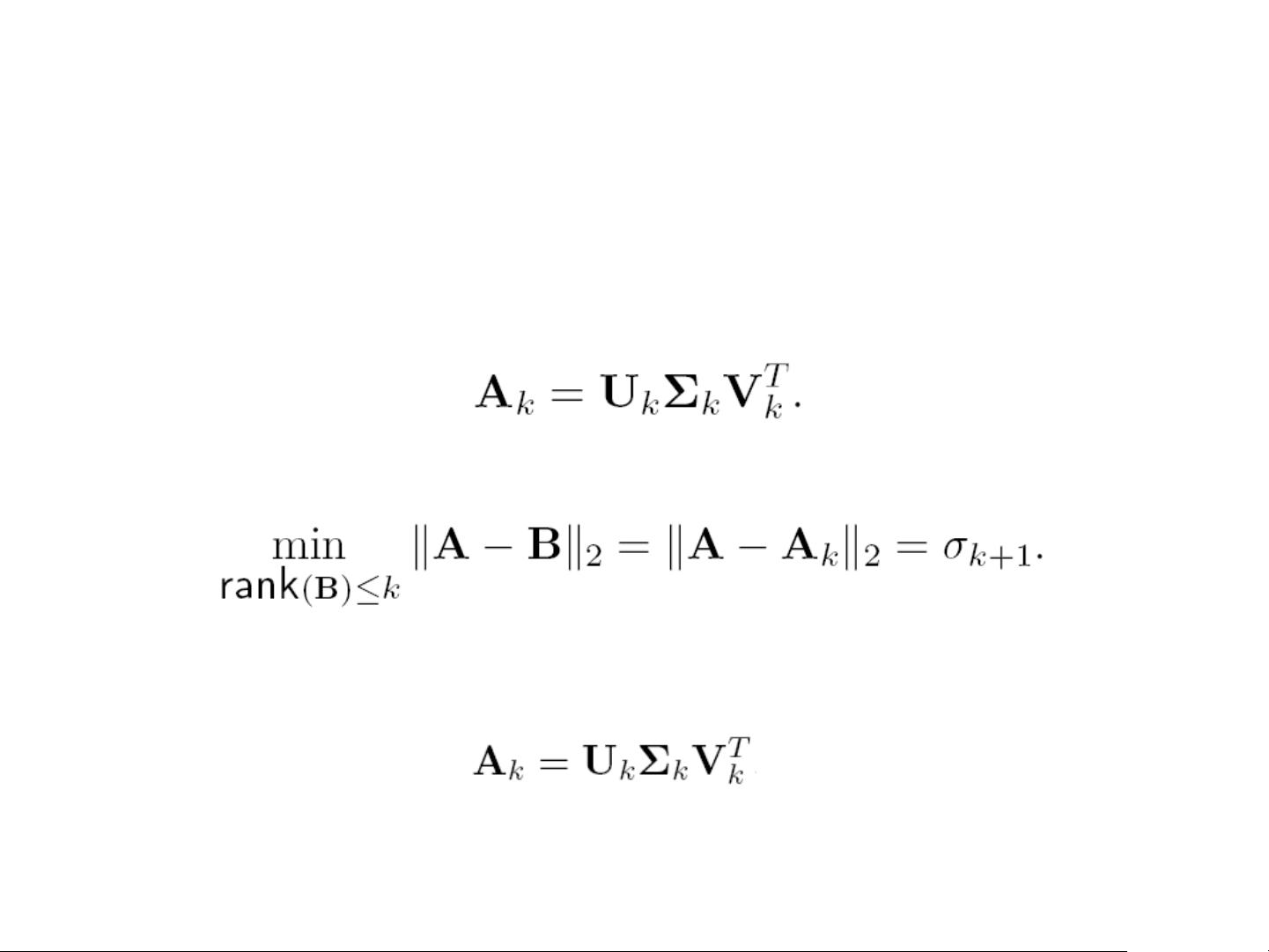

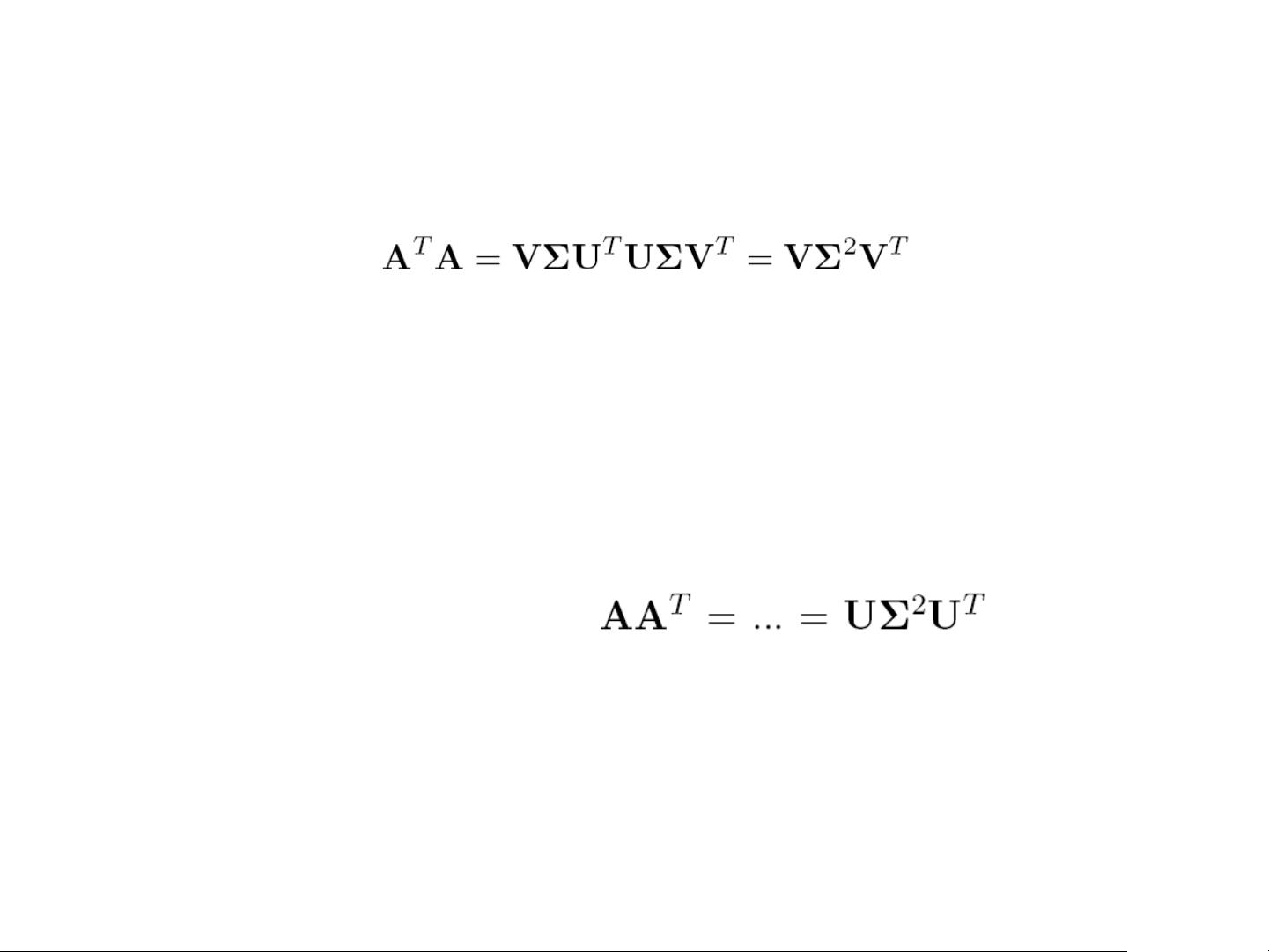

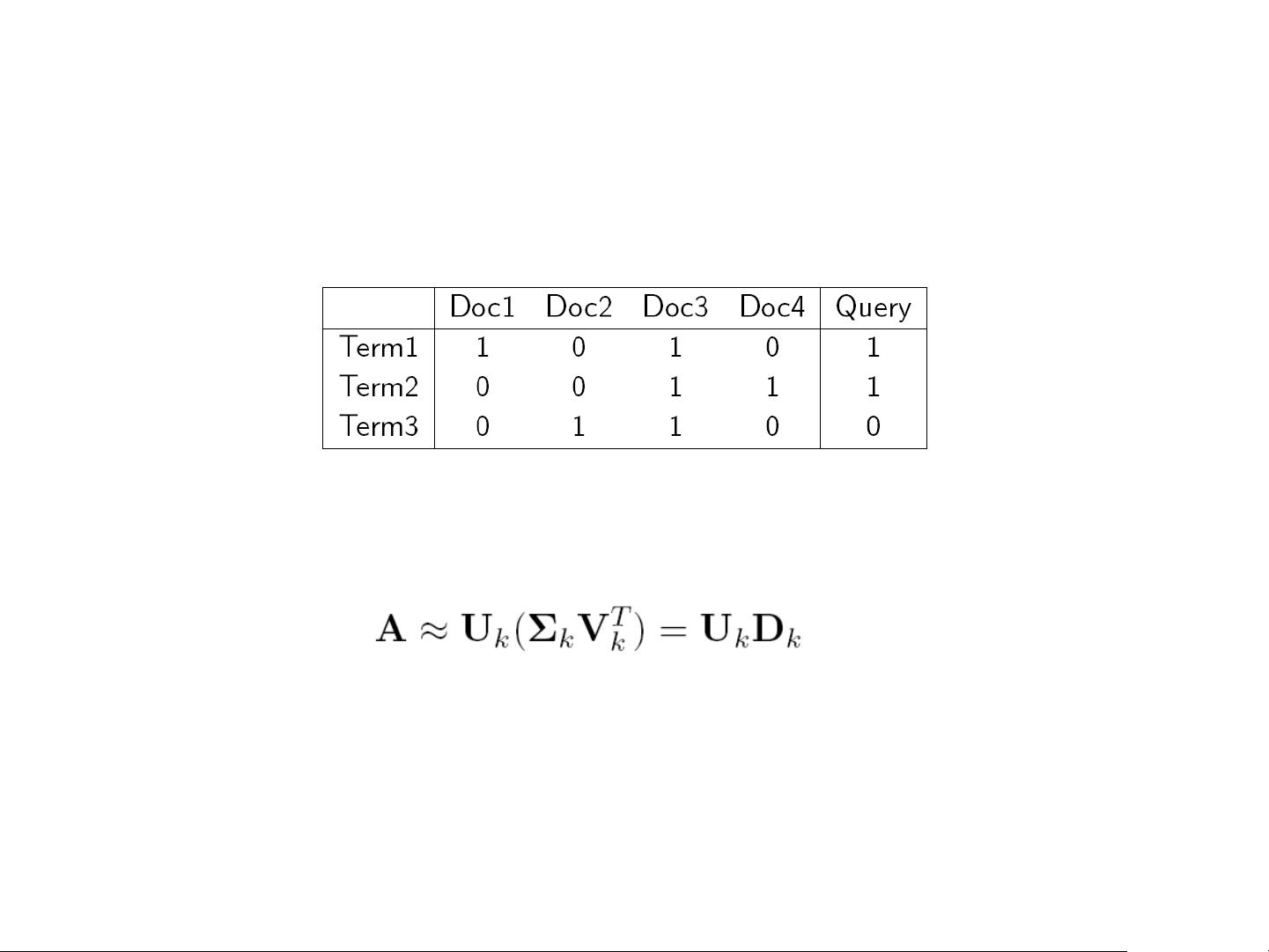

2. 奇异值分解(SVD)是线性代数中的一个重要概念,可以将任意矩阵分解为三个矩阵的乘积。SVD在图像处理、推荐系统和文本分析等领域有广泛应用。

3. 非负矩阵分解(NMF)则假设分解出的矩阵元素都是非负的,这在处理如图像、文本或用户行为数据时非常有用,因为它可以直接解释为各个元素的贡献度。

矩阵分解的主要用途在于数据压缩、特征提取、推荐系统和图像分析等方面。通过找到数据的主要特征向量(基),可以将原始数据映射到一个低维度空间,简化问题并提高计算效率。

接下来,图模型在概率机器学习中扮演着重要角色。这些模型通过图形化的方式表示随机变量之间的条件依赖关系。

1. 图形模型的基本概念包括贝叶斯网络和马尔科夫随机场,它们都利用图结构来描述变量间的概率关系。

2. 贝叶斯网络是一种定向图模型,用于表示变量间的因果关系,其中边代表概率依赖,节点表示随机变量。

3. EM算法(期望最大化算法)是估计参数的一种迭代方法,常用于有隐含变量的概率模型,如混合高斯模型和pLSA。

4. pLSA(潜在语义分析)是一种文本挖掘技术,通过分解文档-词项矩阵来发现主题,其中主题被视为文档的潜在分布。

5. LDA(主题模型)是pLSA的一个扩展,引入了文档级别的主题分布,更适应实际的文本数据。

图模型的运用广泛,包括自然语言处理、计算机视觉、生物信息学等多个领域。通过构建合适的图模型,可以有效地进行概率推断和学习,从而揭示数据背后的模式和规律。

这份资料为学习者提供了一个了解矩阵分解和图模型的良好起点,帮助他们建立起对这两个重要概念的理解,并为进一步深入研究机器学习和数据科学打下坚实基础。

2018-03-10 上传

2018-08-22 上传

2023-07-28 上传

2023-10-10 上传

2024-06-05 上传

2023-07-13 上传

2023-06-08 上传

2023-05-16 上传

2024-08-23 上传

gjhdy

- 粉丝: 1

- 资源: 7

最新资源

- Postman安装与功能详解:适用于API测试与HTTP请求

- Dart打造简易Web服务器教程:simple-server-dart

- FFmpeg 4.4 快速搭建与环境变量配置教程

- 牛顿井在围棋中的应用:利用牛顿多项式求根技术

- SpringBoot结合MySQL实现MQTT消息持久化教程

- C语言实现水仙花数输出方法详解

- Avatar_Utils库1.0.10版本发布,Python开发者必备工具

- Python爬虫实现漫画榜单数据处理与可视化分析

- 解压缩教材程序文件的正确方法

- 快速搭建Spring Boot Web项目实战指南

- Avatar Utils 1.8.1 工具包的安装与使用指南

- GatewayWorker扩展包压缩文件的下载与使用指南

- 实现饮食目标的开源Visual Basic编码程序

- 打造个性化O'RLY动物封面生成器

- Avatar_Utils库打包文件安装与使用指南

- Python端口扫描工具的设计与实现要点解析