深度视频增强:基于感知的时空相关算法

2 浏览量

更新于2024-08-26

收藏 2.85MB PDF 举报

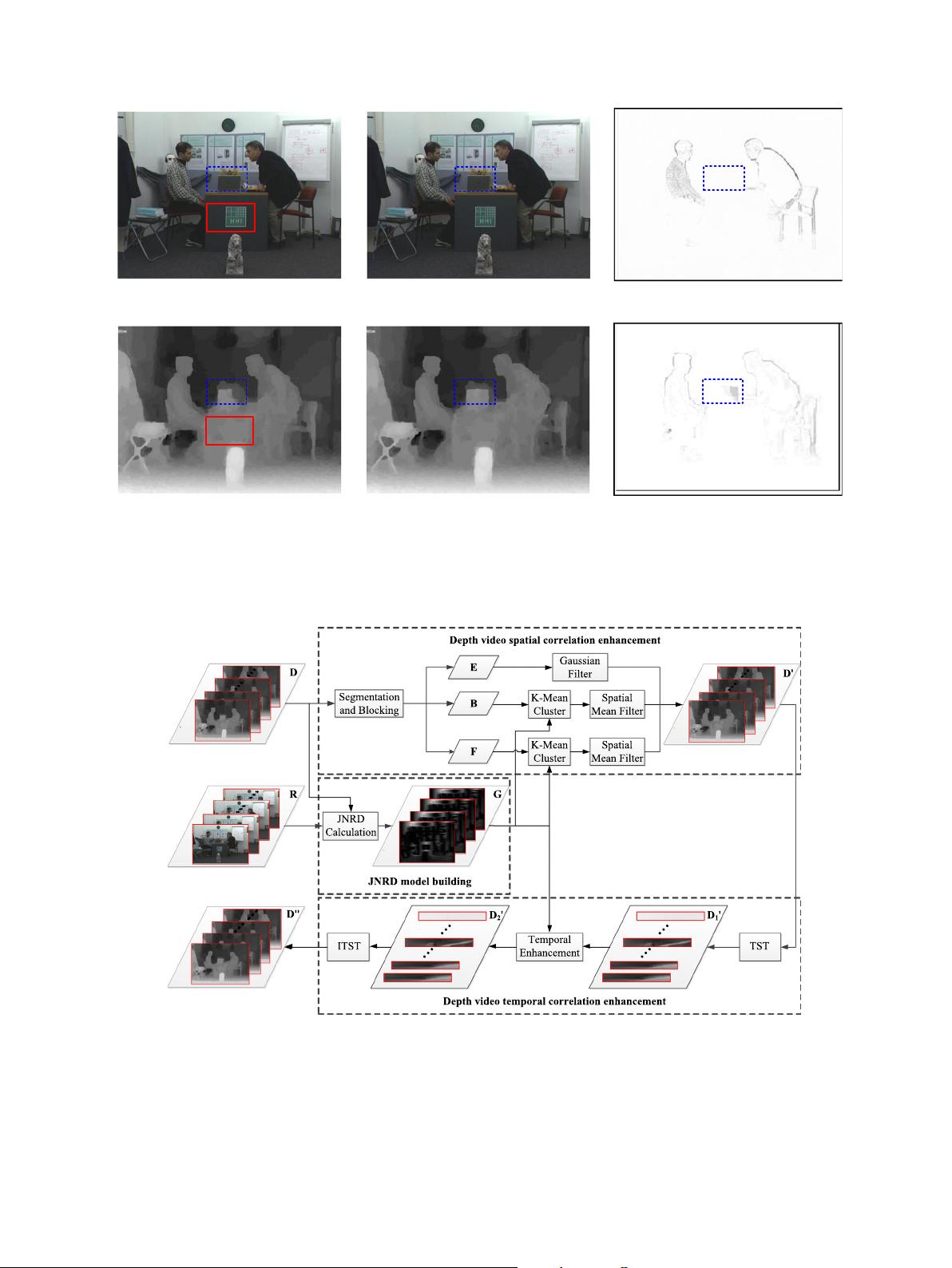

"这篇研究论文探讨了一种基于恰到好处的渲染失真模型的深度视频时空相关增强算法,旨在解决三维视频系统中的深度视频编码效率问题。通过结合虚拟视图渲染与人类视觉感知分析,作者提出了一个能感知深度失真的模型,并在此基础上设计了处理深度视频的空间和时间一致性增强策略,以提升观看体验并节省码率。"

在当前的三维视频系统中,深度视频的空间和时间不一致性会导致编码效率降低,影响观看质量。针对这一问题,该论文提出了一种创新的算法,该算法的核心是建立了一个恰到好处的渲染失真模型(Just Noticeable Rendering Distortion, JNRD)。JNRD模型旨在模拟人类视觉系统对深度失真的敏感度,即只有当失真达到一定程度时,人们才会察觉到。

首先,论文深入分析了深度失真对虚拟视图渲染的影响。在三维视频中,用户可以从不同的角度观看场景,这就需要通过对原始视频和深度信息的处理来生成虚拟视图。如果深度信息存在错误或不一致,那么生成的虚拟视图将出现失真,影响用户体验。

接着,论文结合了人类视觉感知的研究,理解人在观看视频时对图像细节、运动和深度变化的敏感程度。这种理解有助于确定在不失真可接受范围内,如何优化深度视频的编码和渲染,以减少对视觉质量的负面影响。

在JNRD模型的基础上,论文提出了一种深度视频的空间和时间增强策略。这个策略通过检测和修复深度信息的不一致性,增强了视频在空间上的连续性。同时,它还考虑了时间维度,通过分析帧间的深度变化,实现了时间上的一致性增强,减少了因深度信息跳变导致的视觉不舒适感。

此外,论文还提到了深度视频分割方法的应用,这有助于更精细地处理深度信息,提高增强效果。通过智能地分配编码资源,该算法能够在保持视频质量的同时,实现码率的节省,这对于实时传输和存储深度视频尤其重要。

这篇研究论文通过构建一个基于人类视觉感知的渲染失真模型,提供了一种有效的方法来增强深度视频的空间和时间一致性,从而改善三维视频系统的性能,并在一定程度上节省了码率。这一成果对于未来三维视频技术的发展,特别是虚拟现实和增强现实应用,具有重要的理论和实践意义。

973 浏览量

812 浏览量

2021-04-06 上传

184 浏览量

2021-08-18 上传

2020-10-18 上传

2021-07-05 上传

2021-03-23 上传

weixin_38547532

- 粉丝: 5

最新资源

- 掌握PerfView:高效配置.NET程序性能数据

- SQL2000与Delphi结合的超市管理系统设计

- 冲压模具设计的高效拉伸计算器软件介绍

- jQuery文字图片滚动插件:单行多行及按钮控制

- 最新C++参考手册:包含C++11标准新增内容

- 实现Android嵌套倒计时及活动启动教程

- TMS320F2837xD DSP技术手册详解

- 嵌入式系统实验入门:掌握VxWorks及通信程序设计

- Magento支付宝接口使用教程

- GOIT MARKUP HW-06 项目文件综述

- 全面掌握JBossESB组件与配置教程

- 古风水墨风艾灸养生响应式网站模板

- 讯飞SDK中的音频增益调整方法与实践

- 银联加密解密工具集 - Des算法与Bitmap查看器

- 全面解读OA系统源码中的权限管理与人员管理技术

- PHP HTTP扩展1.7.0版本发布,支持PHP5.3环境