"从CHAT-GPT到生成式AI模型: 人工智能新范式的重定义"

需积分: 0 83 浏览量

更新于2024-01-27

收藏 6.13MB PDF 举报

本报告从CHAT-GPT到生成式AI(Generative AI)进行了较为详细的描述和分析。在2023年1月29日发布的这份研究报告中,中信建投证券股份有限公司提供了关于生成式AI模型的最新观点和见解。此次研究报告由分析师武超则和杨艾莉以及研究助理杨晓玮共同撰写,他们的工作单位分别为中信建投证券股份有限公司和中信建投(国际)证券有限公司。

报告中首先对近期OpenAI推出的聊天机器人模型CHAT-GPT进行了介绍,并指出该模型受到了广泛关注。根据Semafor援引的知情人士报道,微软正准备对OpenAI进行一笔巨额投资,预计投资金额约为100亿美元,公司估值达到290亿美元。这一动向表明,生成式AI模型成为了人工智能领域的一个新范式。

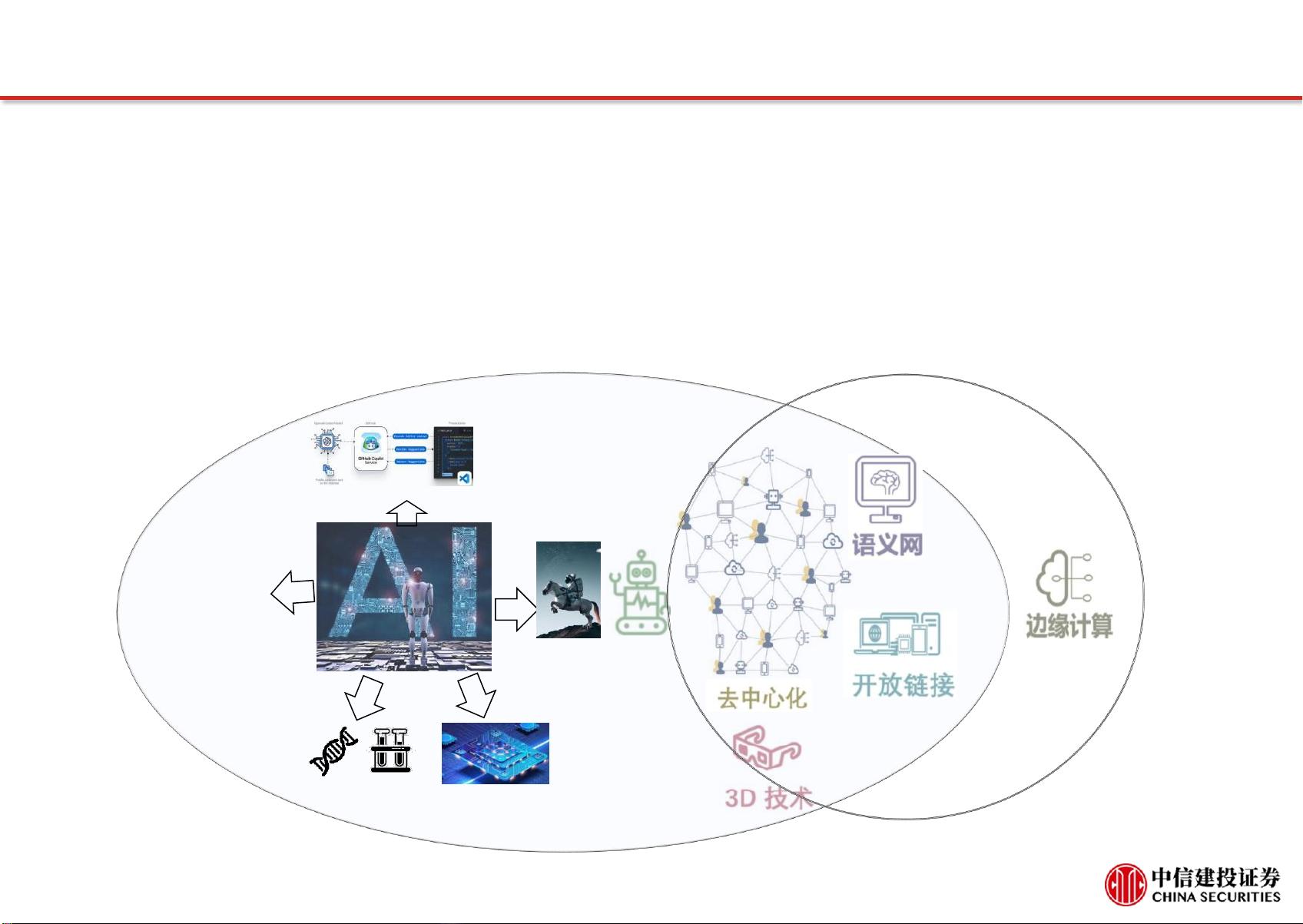

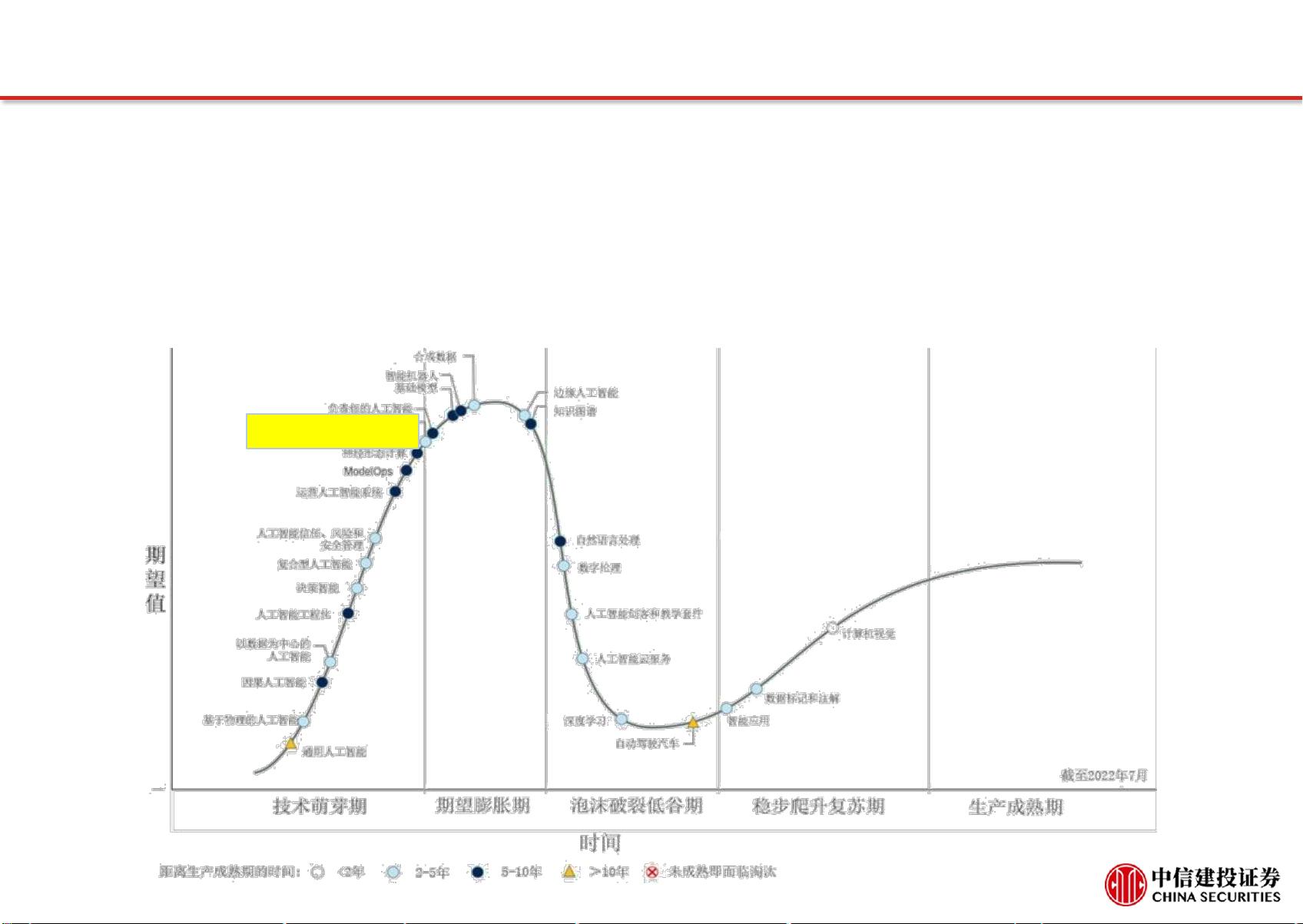

与此前的决策式AI模型不同,生成式AI模型是基于已有数据的生成模型,具有较高的自主性和创造性。它不仅可以分析和识别已有数据中的模式和规律,还可以根据这些规律生成全新的内容。这种模型的出现引发了广泛的讨论和关注,许多人看好生成式AI模型在各个领域的应用前景。

此外,报告还详细分析了生成式AI模型的优势和挑战。生成式AI模型可以应用于自然语言处理、图像生成、音乐创作等多个领域,并取得了一系列令人瞩目的成果。然而,生成式AI模型也存在一些问题,如模型的不稳定性、数据集的收集和隐私保护等方面存在挑战。报告指出,未来需要在技术、法律、伦理等方面进行更深入的研究和探讨。

最后,报告总结了生成式AI模型的市场前景和发展趋势。生成式AI模型在金融、娱乐、教育等领域都具有广阔的应用前景,并有望带来巨大的经济效益和社会效益。然而,与此同时,我们也需要认识到生成式AI模型带来的一些风险和挑战,包括数据隐私、人机协作等方面的问题。因此,需要在技术、监管和伦理等多个方面进行综合考虑和规划。

总而言之,这份研究报告对生成式AI模型进行了全面的介绍和分析,指出了该模型的优势、挑战以及市场前景。生成式AI模型作为人工智能领域的一个新范式,将为各行各业带来巨大的变革和机遇,但同时也需要我们认真面对其中的问题和困境,并积极探索解决之道。生成式AI模型的发展和应用有赖于广大研究人员、政府和企业的共同努力,希望能够为人类社会的进步和发展做出积极的贡献。

1087 浏览量

130 浏览量

1105 浏览量

467 浏览量

213 浏览量

294 浏览量

146 浏览量

155 浏览量

1081 浏览量

2023-06-07 上传

IT徐师兄

- 粉丝: 2482

- 资源: 2862

最新资源

- Apache Kafka的Python客户端-Python开发

- matlab_code:与论文相关的一些代码

- lean-intl:Lean-Intl是针对尚不支持此API的浏览器的Intl-API的精益polyfill。 这是Intl.js的现代分支,具有最新数据,已根据现代开发工作流程和工具要求进行了调整

- 一组dashboard仪表盘图标 .svg .png素材下载

- 易语言多彩文本

- 浅析屏蔽电缆的接地方式.rar

- LengthConverter:该长度转换器应用程序将给定的长度(以米为单位)转换为毫米,厘米,英寸,英尺,码,公里等。此应用程序是使用HTML,CSS,BOOTSTRAP,JAVASCRIPT开发的

- laravel引入自定义composer包文件.zip

- jdbc-jar,数据库连接驱动,三个jar包。包括druid连接池,ojdbc1.6,lombok。

- PokemonApp:应用程序列出宠物小精灵

- QT5网络通讯TCP服务器端代码,linux和win兼容,亲测可用

- 单目标动态发电调度粒子群算法,c语言档案管理界面的源码,c语言

- 使用Arduino和环氧树脂制作的夜灯-电路方案

- Playwright是一个Python库,可通过单个API自动化Chromium,Firefox和WebKit浏览器-Python开发

- 气旋物理学:《游戏物理引擎设计》一书随附的物理引擎

- homebrew-pythons::beer_mug::snake:一个Hombrew Tap,字面上充满了Python解释器