Hadoop2.0集群配置实战指南

“这是关于在Linux环境下使用虚拟机配置Hadoop2.0集群的详细教程,涉及四台物理机的配置,包括Master和Slave角色的分配,以及相关目录、JDK的安装与环境变量配置。”

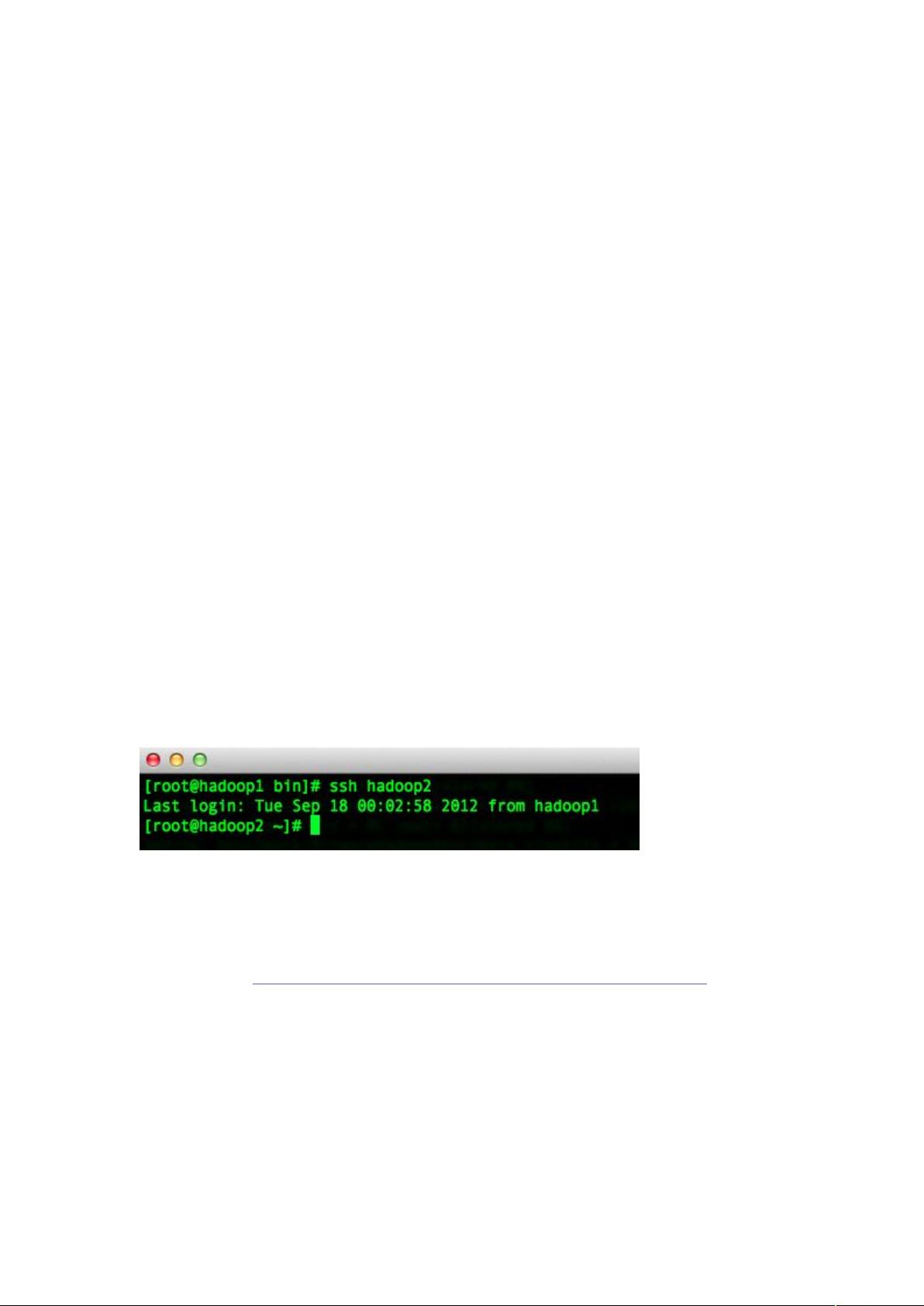

在搭建Hadoop集群之前,首先需要进行充分的准备工作。这个例子中,我们有四台物理机器,它们都将被配置为集群的一部分,其中一台作为Master,其余三台作为Slave。每台机器都应处于同一个局域网中,并且彼此之间能够ping通。IP地址分别为:

192.168.216.131 - hadoop1 (Master)

192.168.216.132 - hadoop2 (Slave)

192.168.216.133 - hadoop3 (Slave)

192.168.216.134 - hadoop4 (Slave)

操作系统选用的是CentOS 6.2 64位。在所有机器上,首先使用root用户登录,然后创建名为“hadoop”的新用户,以便于管理和操作Hadoop集群。

```

useradd hadoop

passwd hadoop

```

接着,创建Hadoop所需的目录结构。这些目录用于存放代码、工具、数据节点以及日志文件等:

```

mkdir -p /home/hadoop/source

mkdir -p /home/hadoop/tools

mkdir -p /hadoop/hdfs

mkdir -p /hadoop/tmp

mkdir -p /hadoop/log

```

确保这些目录具有可写权限,以供Hadoop服务使用:

```

chmod -R 777 /hadoop

```

接下来,我们需要安装Java开发工具包(JDK)。这里选择了JDK 1.7的64位版本,从Oracle官方网站下载并解压:

```

tar zvxf jdk-7u10-linux-x64.tar.gz

mv jdk1.7.0_10 /usr/java/jdk1.7

```

配置环境变量是必不可少的步骤,这可以通过编辑`/etc/profile`文件来实现:

```

echo 'export JAVA_HOME=/usr/java/jdk1.7' >> /etc/profile

echo 'export CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar' >> /etc/profile

echo 'export PATH=$PATH:$JAVA_HOME/bin' >> /etc/profile

```

完成上述配置后,别忘了使改动生效:

```

source /etc/profile

```

至此,硬件和软件环境已基本就绪。在Master机器上,我们将配置NameNode和JobTracker,而Slave机器将配置DataNode和TaskTracker。值得注意的是,为了高可用性,通常会有一个备用Master节点,以防主Master宕机。然而,这个教程仅涉及基础配置,没有立即设置备用Master。随着经验的积累,可以考虑添加额外的物理机作为备用Master。

总结来说,本教程涵盖了Hadoop2.0集群的基本配置步骤,包括机器准备、用户创建、目录结构建立、JDK安装以及环境变量配置。这为后续的Hadoop集群搭建提供了坚实的基础。在实际部署时,还需要进一步配置Hadoop的配置文件(如`hdfs-site.xml`、`mapred-site.xml`、`core-site.xml`等),以及启动和检查集群的服务状态。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2015-04-07 上传

2018-03-06 上传

2017-09-08 上传

2023-08-13 上传

coppher

- 粉丝: 705

- 资源: 12

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器