深入解析Hadoop源代码:分布式基石与MapReduce机制

需积分: 9 91 浏览量

更新于2024-07-25

收藏 5.91MB DOC 举报

"Hadoop源代码分析"

在深入探讨Hadoop源代码之前,首先理解Hadoop的背景至关重要。Hadoop是一个开源框架,最初受到Google的分布式计算技术启发,旨在支持大规模数据处理。它由两个主要组件构成:Hadoop Distributed File System (HDFS) 和 MapReduce。HDFS是一个分布式文件系统,模仿了Google的GFS,而MapReduce则是基于Google的MapReduce模型,用于并行处理大量数据。

HDFS是Hadoop的基础,提供了高容错性的数据存储能力。它将大文件分割成块,并在集群中的多个节点上复制这些块,确保数据的可用性和冗余。Hadoop的MapReduce组件则负责数据的处理,通过“映射”(map)和“规约”(reduce)阶段将任务分解到各个节点,然后汇总结果。

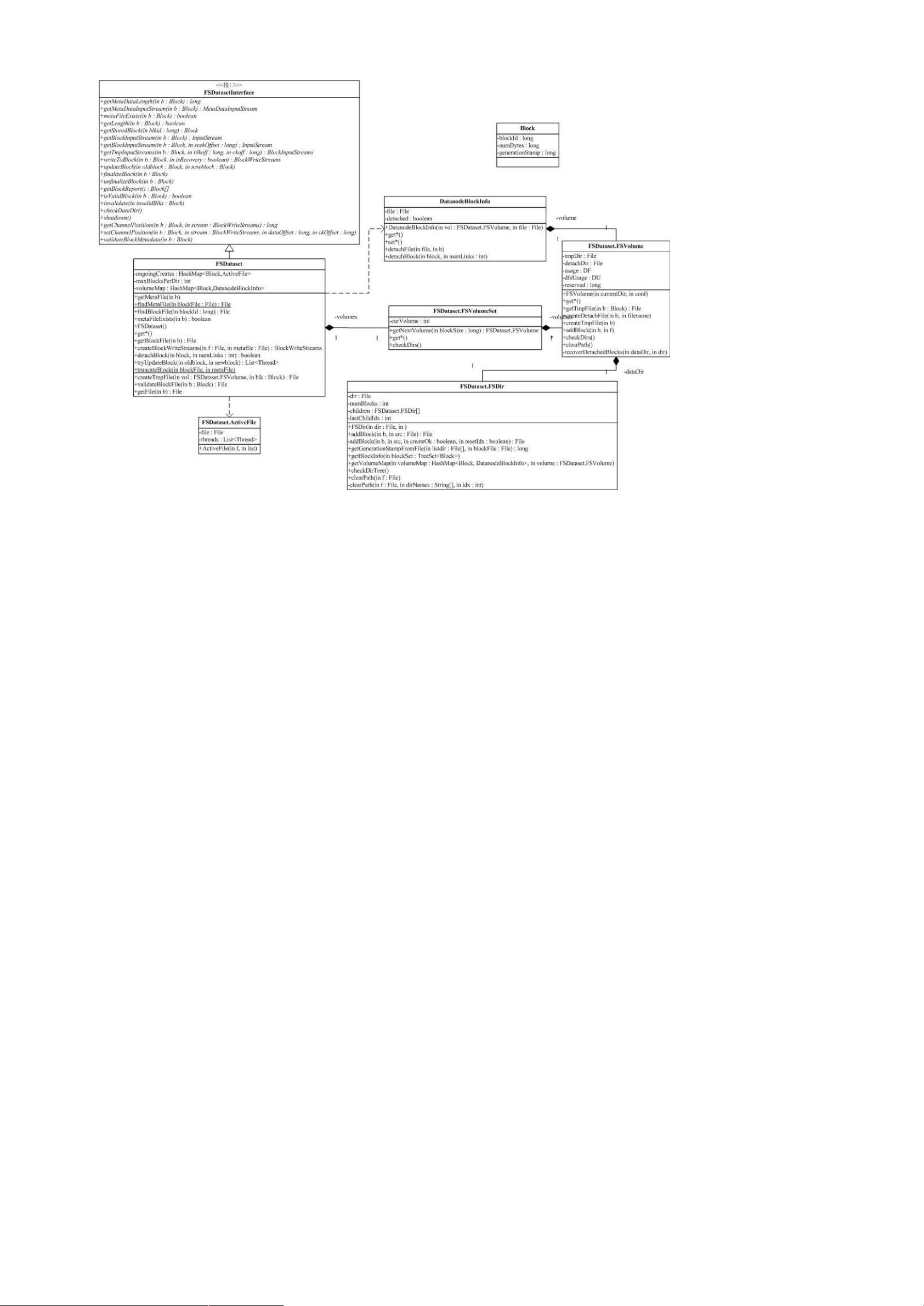

在源代码层面,Hadoop的结构较为复杂,其中包含了大量的包和类。例如,`fs`包抽象了文件系统接口,使得HDFS可以透明地与本地文件系统或像Amazon S3这样的云存储服务交互。`conf`包用于读取和管理配置,它依赖于`fs`包来访问配置文件。这种交叉依赖关系导致了复杂的包间关系。

Hadoop的关键组件包括:

1. `hdfs`: 实现HDFS,包括NameNode、DataNode和客户端接口等。

2. `mapred`: 包含MapReduce的实现,包括JobTracker、TaskTracker和JobClient等。

3. `common`: 提供了Hadoop的通用工具和库,如网络通信、I/O操作和配置管理。

在包的功能分析中,我们可以看到如下组织:

- `tool`包:包含各种命令行工具,如Hadoop自带的`fs`工具,用于与HDFS交互,以及`jar`工具,用于运行MapReduce作业。

- `io`包:实现了各种输入/输出格式和压缩算法,适应不同的数据处理需求。

- `net`包:处理网络通信,如Socket和TCP/IP协议栈的实现。

- `util`包:提供一般性帮助类和实用方法,如日志、时间管理和并发控制。

在源代码分析过程中,理解这些包的职责和它们之间的交互是至关重要的。通过研究源代码,开发者可以深入理解Hadoop如何处理分布式存储和计算,从而优化应用程序性能,排查问题,或者开发新的Hadoop扩展。

对于Hadoop源代码的详细分析,需要对分布式系统、网络编程和Java有深入的理解。这包括理解HDFS的数据存储策略,如数据块的分配和复制,以及MapReduce的工作流程,如任务调度和数据分发。此外,还需要关注Hadoop的容错机制,如NameNode的高可用性和DataNode的故障检测。

Hadoop源代码分析是一项深入的任务,它涵盖了分布式系统设计的许多核心概念。通过这样的分析,开发者可以更好地利用Hadoop构建大规模数据处理应用,同时也为优化和改进Hadoop本身提供可能。

2022-03-12 上传

2014-12-01 上传

2014-07-20 上传

2012-04-17 上传

2024-10-27 上传

2024-10-27 上传

roadsign

- 粉丝: 0

- 资源: 8

最新资源

- Material Design 示例:展示Android材料设计的应用

- 农产品供销服务系统设计与实现

- Java实现两个数字相加的基本代码示例

- Delphi代码生成器:模板引擎与数据库实体类

- 三菱PLC控制四台电机启动程序解析

- SSM+Vue智能停车场管理系统的实现与源码分析

- Java帮助系统代码实现与解析

- 开发台:自由职业者专用的MEAN堆栈客户端管理工具

- SSM+Vue房屋租赁系统开发实战(含源码与教程)

- Java实现最大公约数与最小公倍数算法

- 构建模块化AngularJS应用的四边形工具

- SSM+Vue抗疫医疗销售平台源码教程

- 掌握Spring Expression Language及其应用

- 20页可爱卡通手绘儿童旅游相册PPT模板

- JavaWebWidget框架:简化Web应用开发

- 深入探讨Spring Boot框架与其他组件的集成应用