揭示数据简化奥秘:PCA原理详解与实际应用

PCA(主成分分析)是统计学和机器学习中常用的一种降维技术,其全称为Principal Component Analysis。它通过线性变换,将原始数据集中高度相关的特征线性组合成一组新的、不相关或低度相关的特征,即主成分。这些主成分按其对数据方差贡献程度排列,第一个主成分解释了最多的数据变异,第二个主成分解释剩余变异的大部分,以此类推。

PCA的核心思想在于找到数据集中的最大方差方向,从而提取出最重要的信息。其主要步骤包括数据标准化、计算协方差矩阵、特征值分解和特征向量选择。在数据处理中,PCA能帮助我们减少冗余信息,消除噪声,使得复杂的数据变得更容易理解和可视化。由于其无参数限制且易于理解,PCA被广泛应用于诸如生物信息学(如基因表达数据)、图像处理(如人脸识别)、金融风险分析等众多领域。

在实际应用中,如神经科学实验,可能需要记录大量变量以描述潜在的影响因素,如光谱、电压、速度等。然而,这些数据通常会受到实验条件和测量误差的影响,导致数据复杂且冗余。PCA能够通过减少维度,揭示隐藏在复杂数据背后的简单模式,帮助科学家们识别出关键变量和它们之间的关系。比如在物理实验中,通过记录球在三维空间中的运动,PCA可以帮助分析出仅在x轴上的运动模式,即使原始数据包含了多个维度。

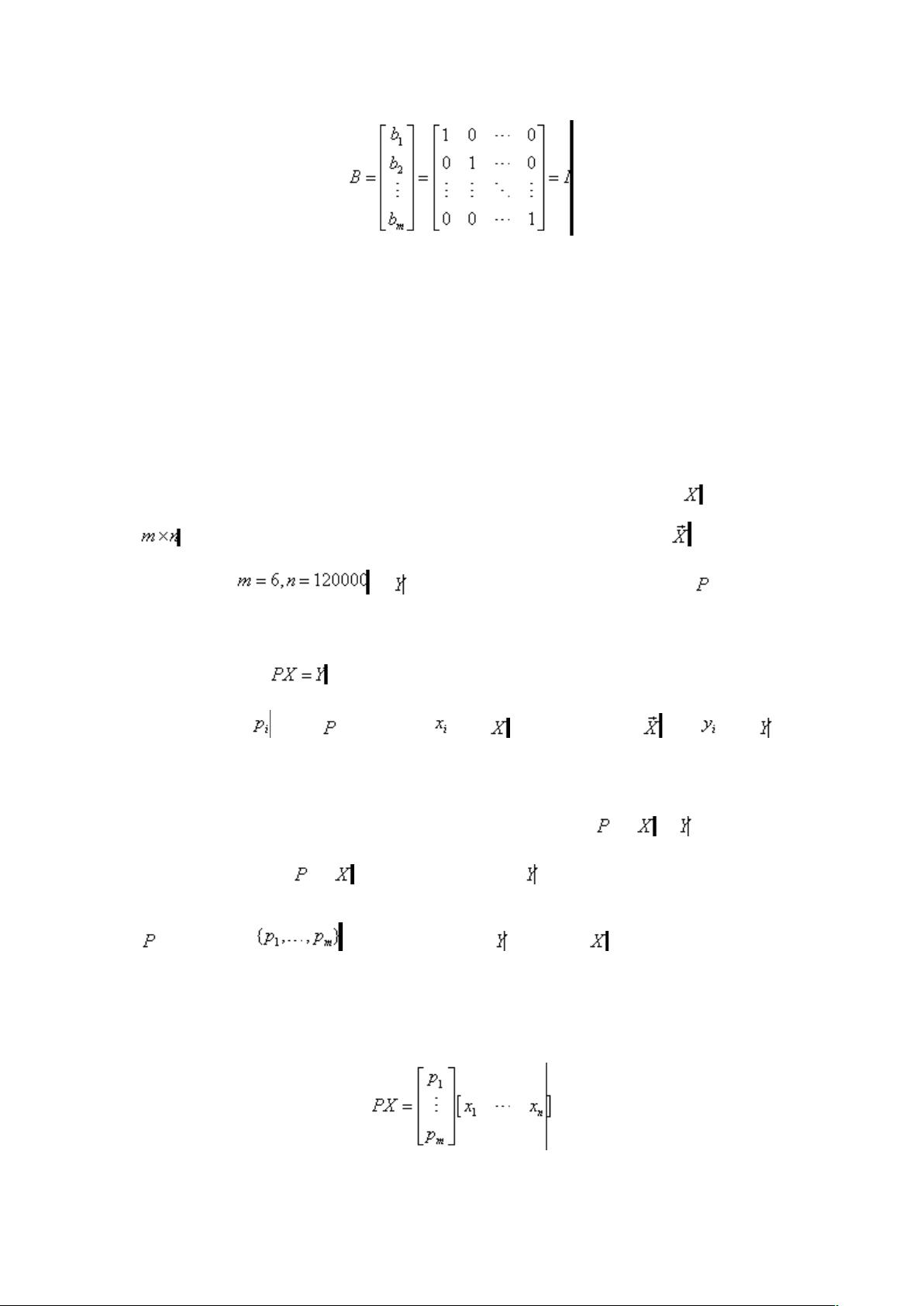

PCA的理论基础建立在矩阵运算和线性代数上,特别是与Singular Value Decomposition(SVD,奇异值分解)紧密相关。SVD提供了对矩阵的完整分解,而PCA正是利用SVD来找到数据的主成分。在PCA中,数据矩阵经过SVD后,主成分对应于最大的奇异值对应的左奇异向量,这些向量构成了新坐标系,原数据在新坐标系下的投影就是主成分。

值得注意的是,PCA假设输入数据是正态分布的,且数据间存在线性相关性。如果这些假设不成立,可能会导致分析结果偏离实际。对此,可以通过其他方法如Partial Least Squares(PLS,偏最小二乘法)或Kernel PCA(核主成分分析)等进行改进,以适应非线性或非正态数据的情况。

PCA是一个强大的工具,其原理深入到线性代数的核心,但在实际应用中需要根据具体问题灵活调整和优化。理解PCA的原理和优势,并结合适当的修正方法,可以大大提高数据分析的效率和准确性。

111 浏览量

2021-09-29 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-09-23 上传

sinsou

- 粉丝: 7

- 资源: 15

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常