强化学习基础与应用

版权申诉

166 浏览量

更新于2024-06-25

收藏 15.81MB PPTX 举报

"这份资源是关于强化学习的 PowerPoint 演示文稿,包含了多个学习者的名字以及课程的概要内容。强化学习是一种机器学习的方法,通过与环境的交互来优化决策策略,以获得最大的累计奖励。"

在强化学习中,核心概念包括环境(Environment)、状态空间(State Space)、动作空间(Action Space)、状态转移概率(State Transition Probability)和奖赏函数(Reward Function)。环境E由状态X和动作A组成,机器通过执行动作A在状态X之间进行转移,并依据奖赏函数R获取反馈。策略π是强化学习的核心,它决定了机器在特定状态下应采取的动作。策略可以分为确定性策略和随机性策略:

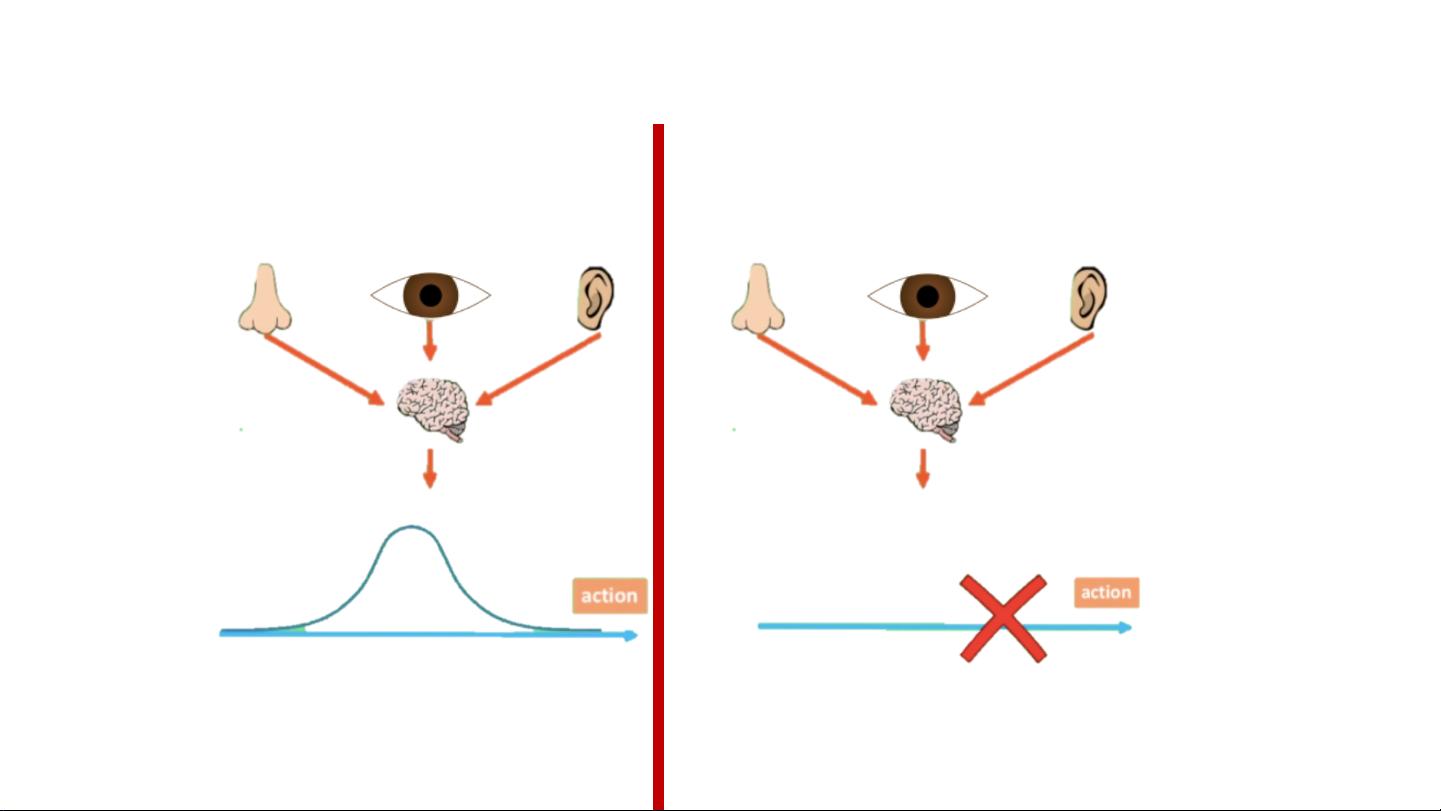

1. 确定性策略(Deterministic Policy):在状态x下,策略π直接给出一个确定的动作a。这种策略简单且计算效率高,但缺乏探索新经验的能力。

2. 随机性策略(Stochastic Policy):策略π以一定的概率P给出动作a。虽然需要更多样本数据和较长的学习时间,但它能更好地探索环境,有助于发现最优策略。

强化学习与监督学习的主要区别在于:

- 监督学习依赖于已标记的样本,而强化学习则通过试错来学习。

- 监督学习通常有即时的反馈,强化学习的反馈可能在未来的状态中才会体现。

- 强化学习分为基于模型(Model-based RL)和免模型(Model-free RL),前者利用环境模型来预测,后者直接从经验中学习。

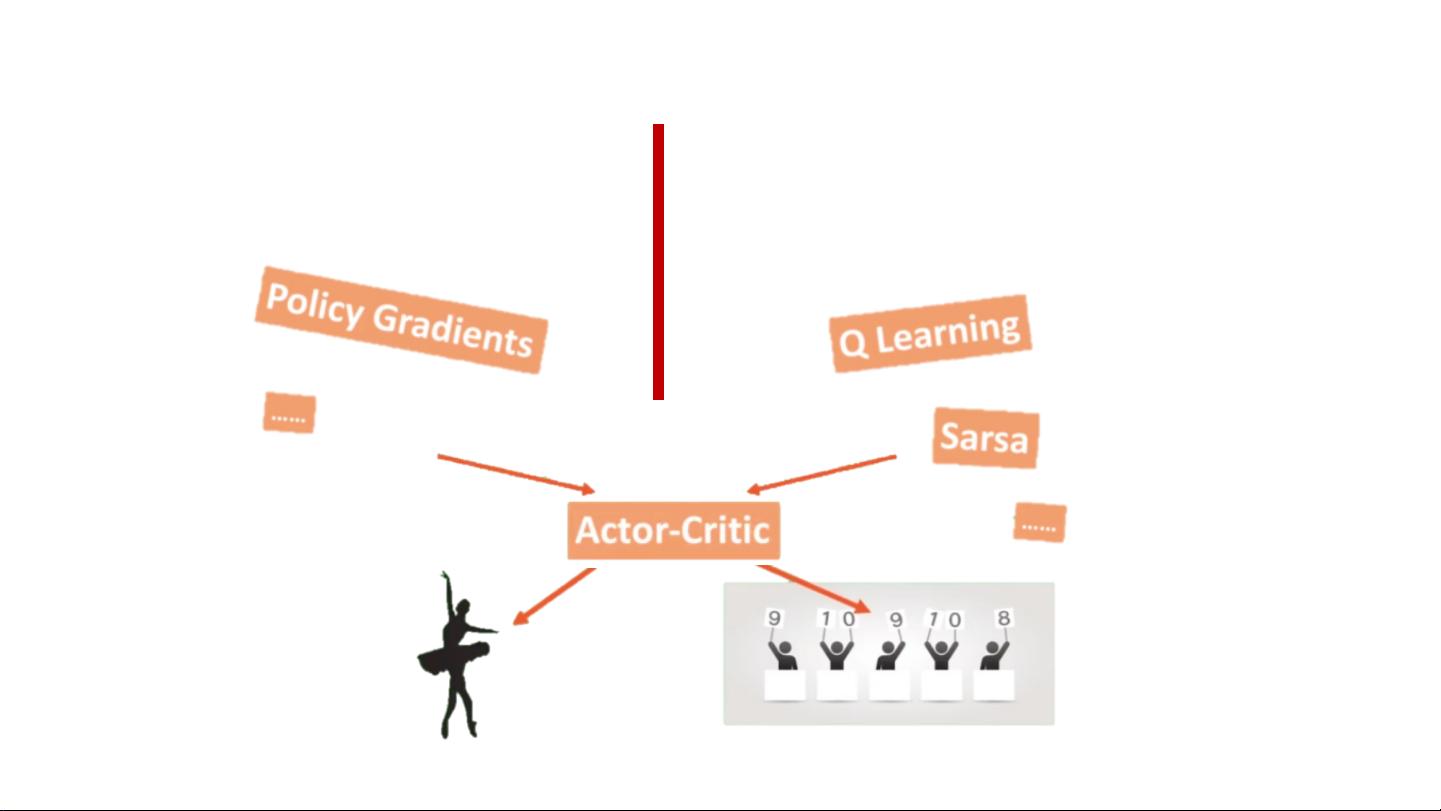

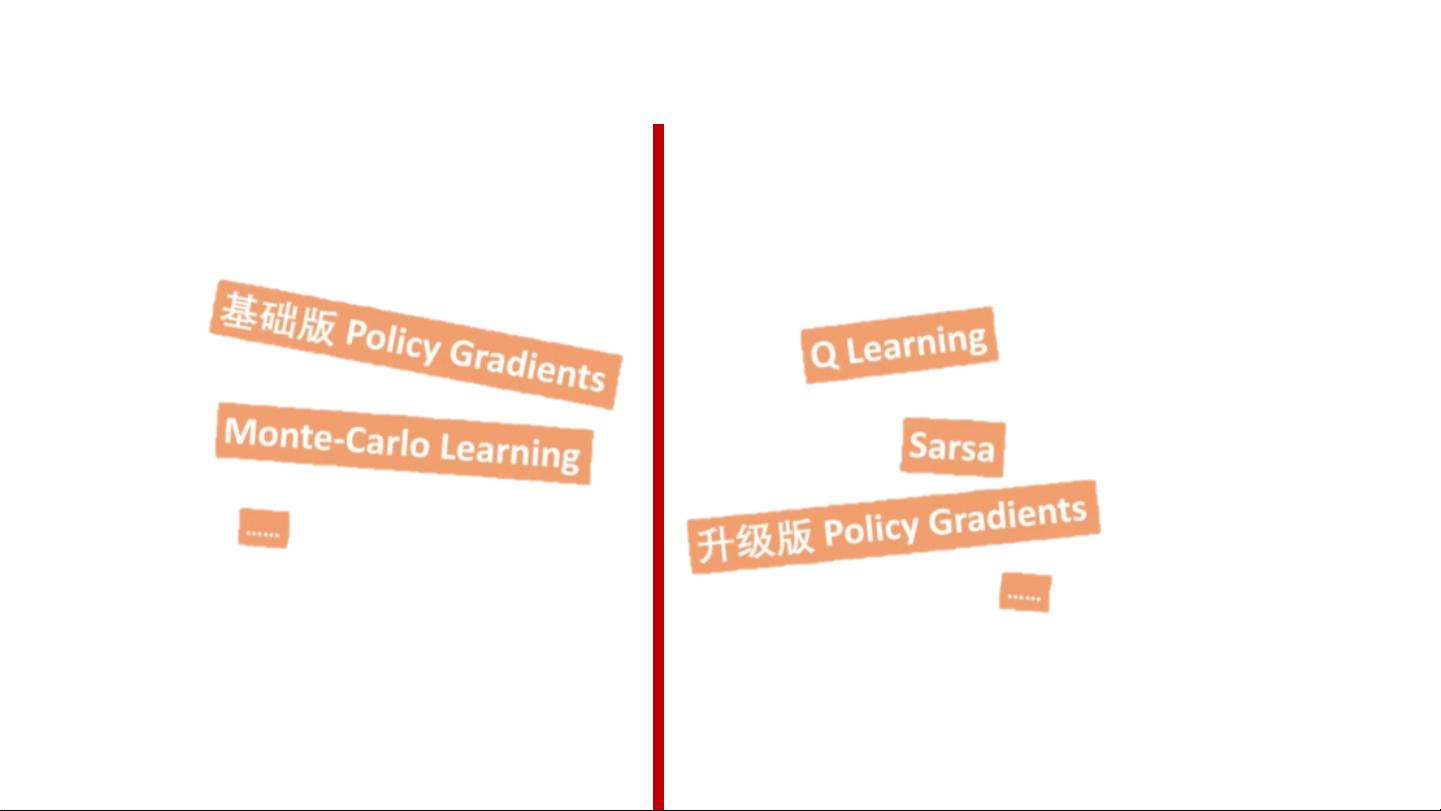

- 强化学习方法还包括值函数近似(Value-based RL)和策略搜索(Policy-based RL)两种策略优化方法,以及蒙特卡洛更新(Monte Carlo Update)和时序差分学习(Temporal-difference Update)等学习算法。

强化学习中的探索与利用(Exploration and Exploitation)是一个关键问题,如何在追求当前最大奖赏(exploitation)和发现潜在更好策略(exploration)之间找到平衡,是实现长期最优策略的关键。

强化学习是一种通过不断与环境互动,学习如何做出最大化长期收益决策的机器学习方法。它涉及多种策略和算法,适用于需要智能决策的任务,如游戏、机器人控制、资源管理等领域。

2021-07-06 上传

2018-07-27 上传

2021-01-27 上传

2023-06-12 上传

2023-06-12 上传

2023-04-08 上传

2024-01-28 上传

2023-04-11 上传

2023-04-01 上传

白话机器学习

- 粉丝: 1w+

- 资源: 7672

最新资源

- 前端协作项目:发布猜图游戏功能与待修复事项

- Spring框架REST服务开发实践指南

- ALU课设实现基础与高级运算功能

- 深入了解STK:C++音频信号处理综合工具套件

- 华中科技大学电信学院软件无线电实验资料汇总

- CGSN数据解析与集成验证工具集:Python和Shell脚本

- Java实现的远程视频会议系统开发教程

- Change-OEM: 用Java修改Windows OEM信息与Logo

- cmnd:文本到远程API的桥接平台开发

- 解决BIOS刷写错误28:PRR.exe的应用与效果

- 深度学习对抗攻击库:adversarial_robustness_toolbox 1.10.0

- Win7系统CP2102驱动下载与安装指南

- 深入理解Java中的函数式编程技巧

- GY-906 MLX90614ESF传感器模块温度采集应用资料

- Adversarial Robustness Toolbox 1.15.1 工具包安装教程

- GNU Radio的供应商中立SDR开发包:gr-sdr介绍