哈工大机器学习课件-6:无监督学习与聚类分析

需积分: 5 182 浏览量

更新于2024-07-06

收藏 1.85MB PDF 举报

"哈工大机器学习课程的第六部分专注于Clustering,即无监督学习的一种方法。无监督学习是指在没有标记或注释的数据上进行学习,不依赖于监督信号。Clustering是寻找数据中是否存在‘组’的过程,探索每个组的特征以及它们的数量,并找出识别这些组的方法。

Clustering的基本概念:

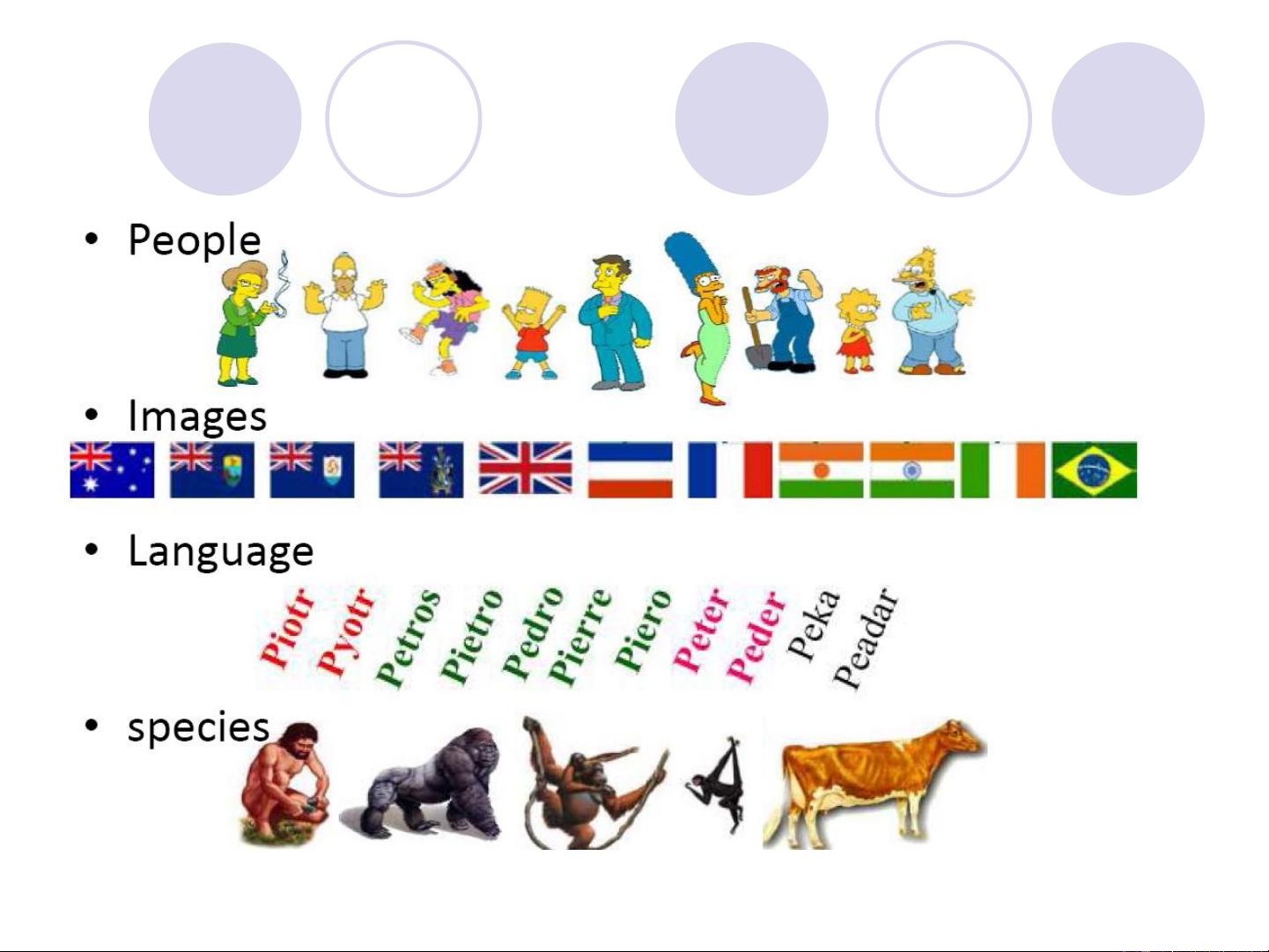

- Clustering是一种将一组对象根据相似性归类到不同类别的过程,目标是确保同一类别内的对象相似度高(高内聚),而不同类别间的对象相似度低(低耦合)。

- 它是无监督学习最常见的形式,在科学研究、工程、信息科学和其他领域有广泛应用。

- 应用场景包括:归类执行相同功能的基因、识别具有相似政治观点的个体、分类相似主题的文档以及从图片中识别相似物体。

Clustering面临的问题与挑战:

- 如何定义自然的群体结构?即如何确定哪些对象应该归为一类,这个‘群体性’的标准是什么?

- 什么因素使得对象之间相关?需要确定哪些属性或特征可以用来度量对象之间的相似性。

- 如何选择合适的聚类算法?不同的聚类方法有不同的假设和适用场景,如K-means、层次聚类、DBSCAN等。

- 聚类的稳定性与可解释性:一个好的聚类结果应该是稳定的,即使小的输入变化不会导致显著的类别变化;同时,结果应易于理解和解释。

- 初始化敏感性:某些聚类算法对初始中心的选择非常敏感,如K-means,不恰当的初始化可能导致较差的聚类结果。

- 数据噪声和异常值处理:真实世界的数据往往包含噪声和异常值,这些可能会影响聚类质量,需要适当的预处理策略来处理。

为了实现有效的聚类,通常需要进行以下步骤:

1. 数据预处理:清洗数据,处理缺失值,标准化或归一化数值特征,去除噪声和异常值。

2. 特征选择:选择对聚类最有影响力的特征。

3. 确定合适的聚类数量:可以使用肘部法则、轮廓系数或其他方法来评估不同K值的效果。

4. 应用聚类算法:如K-means、层次聚类、DBSCAN等。

5. 评估聚类效果:通过内部或外部指标,如轮廓系数、Calinski-Harabasz指数等来验证聚类的质量。

哈工大的这节机器学习课件深入介绍了Clustering这一无监督学习技术,旨在帮助学生理解和掌握如何在无标签数据中发现潜在的结构和模式。"

2022-01-25 上传

2022-01-25 上传

2022-01-25 上传

2024-11-09 上传

2024-11-09 上传

2024-11-10 上传

2024-10-28 上传

2023-05-20 上传

2023-10-20 上传

sghwjp

- 粉丝: 1

- 资源: 13

最新资源

- 自动夜灯:自动夜灯在天黑时打开 - 使用 Arduino 和 LDR-matlab开发

- RadarEU-crx插件

- torchinfo:在PyTorch中查看模型摘要!

- FFT的应用,所用数据为局部放电信号,实测可用。matalab代码有详细注释

- 邦德游戏

- LTI 系统的 POT:LTI 系统的参数化[非线性]优化工具-matlab开发

- Information-System-For-Police:警务协助申请系统

- Mondkalender-crx插件

- 麦田背景的商务下载PPT模板

- tsdat:时间序列数据实用程序,用于将标准化,质量控制和转换声明性地应用于数据流

- ubersicht-quote-of-the-day:他们说Übersicht的当日行情

- intensivao_python:主题标签treinamentosintensivãopython

- 豆瓣网小说评论爬虫程序

- bdf_ChanOps:在 BDF 上读、写和执行任何数学运算的函数。-matlab开发

- 幕墙节点示意图

- Shalini-Blue55:蓝色测试55