林轩田《机器学习基石》笔记:线性回归原理与最小二乘法应用

需积分: 0 72 浏览量

更新于2024-08-05

收藏 1.47MB PDF 举报

林轩田在《机器学习基石》课程的第九章中深入探讨了线性回归这一核心概念。他首先回顾了在噪声环境中VCBound理论的应用,并强调了不同误差测量方法的重要性,如最小二乘法,它是线性回归中最常用的一种。

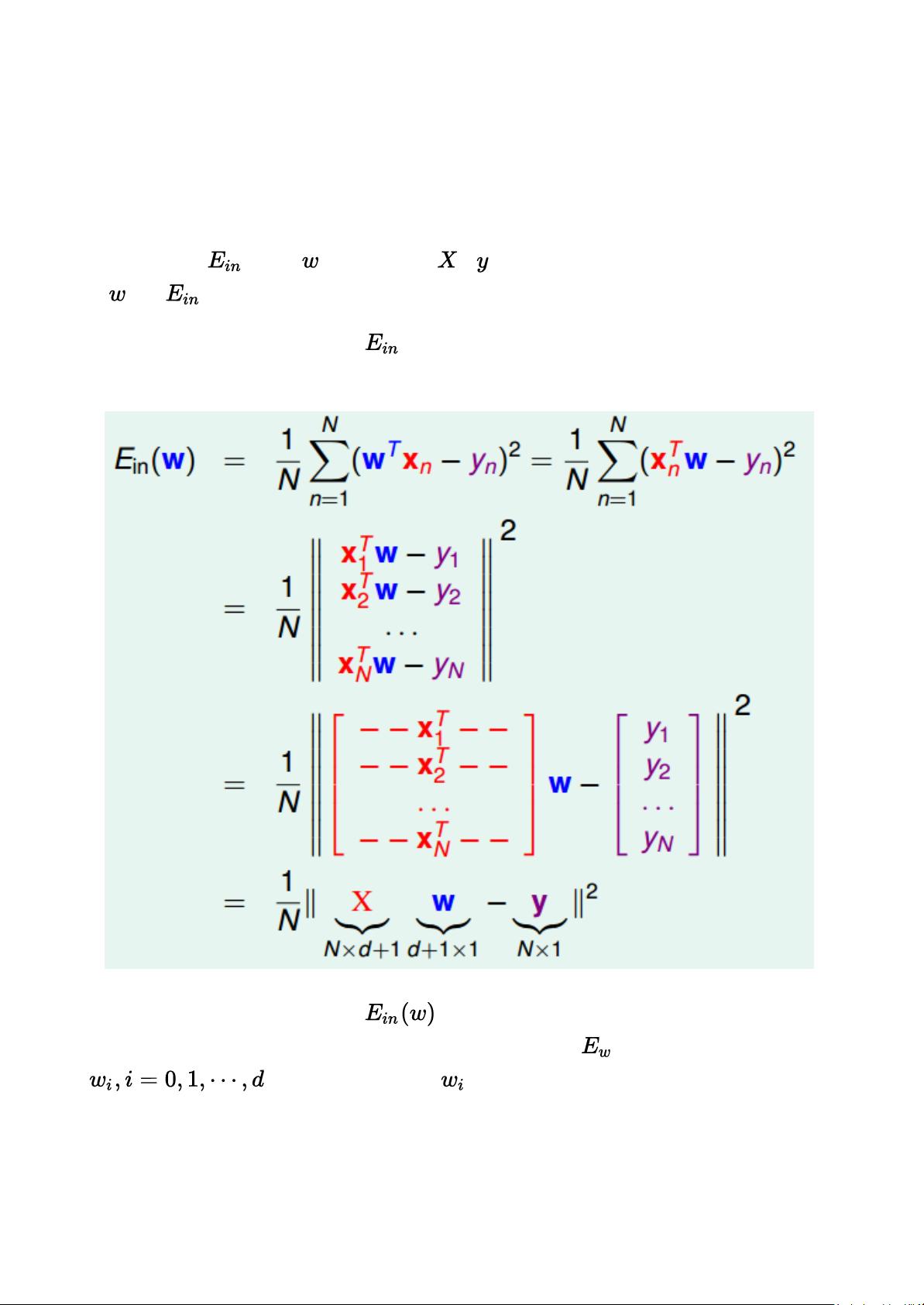

在本节课程中,林轩田通过信用卡额度分配问题来引入线性回归的实际应用。用户特征集被表示为一个d维空间,加入一个常数项后,形成了d+1维的输入向量。线性回归的目标是找到一个权重向量w,使得预测函数Hypothesis(记为hθ)与实际观测值y之间的残差误差最小化。线性回归预测函数的值域是整个实数空间,与线性分类有所区别。

最小二乘法作为误差测量的基础,它的目的是寻找使总平方误差(如平方误差和)最小化的权重。尽管线性最小二乘问题有closed-form解,即可以通过一次求解得到权重,而非线性问题则通常需要迭代方法。课程中提到的权重向量w的计算公式利用了矩阵运算,特别是对目标函数J(w)进行偏导数分析,当偏导数为零时,达到了最优解。

具体来说,通过矩阵转换,将权重向量w和特征矩阵X的关系表达为矩阵形式,然后利用伪逆矩阵(记作X⁺,维度为(d+1)xN),得出权重向量w = X⁺y。这里的X⁺是X的伪逆,它在解决欠定或奇异矩阵问题时发挥关键作用。

值得注意的是,当遇到欠定问题(特征矩阵的列数小于行数)时,X可能没有逆矩阵,但伪逆的存在确保了线性回归问题的可解性。本节内容详细介绍了线性回归问题的数学基础、求解策略以及权重向量的推导过程,这些都是理解和实践机器学习算法不可或缺的部分。

2023-03-29 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

点击了解资源详情

2023-03-28 上传

2023-03-28 上传

2015-10-15 上传

2023-03-28 上传

嘻嘻哒的小兔子

- 粉丝: 35

- 资源: 321

最新资源

- 零基础DSP实战TMS320F28035:第五节,SCI(uart)通讯实战.zip

- java版餐厅点菜系统.zip

- 医疗app 医生日程页UI + 加载进度UI .fig素材下载

- 钢结构施工组织设计-钢结构工程施工组织设计方案

- 侧馈矩形微带天线 - HFSS

- ASP理发管理系统设计(源代码+论文).rar

- 第十五届蓝桥杯大赛软件赛省赛-C++A组题目

- 用DAC0832产生锯齿波电压-综合文档

- node-v8.6.0-darwin-x64.tar.gz

- 小程序源码 NavigationDrawer完整代码.rar

- VB考勤管理程序源代码

- 可解决合并单元对前端需求的应用方案-电路方案

- es6-workflow:使用 Gulp、Babel 和 Browserify 使用 ES6 的简单工作流

- 侧滑甜蜜婚礼相册展示程序源码.zip

- 公路桥梁隧道施工组织设计-宜昌某高速公路施工组织设计方案

- node-v12.10.0-win-x86.zip