大数据技术解析:Hadoop生态与处理框架

需积分: 2 161 浏览量

更新于2024-06-14

收藏 1.33MB PDF 举报

"大数据基础平台实施及运维涵盖了大数据技术的运用、处理框架和Hadoop生态系统的详细介绍,旨在帮助读者理解大数据的重要性和应用领域,并熟悉大数据处理的工具与平台。"

大数据技术是应对海量数据增长、实时分析需求以及广泛应用场景的关键手段。随着数据量的爆炸式增长,传统的数据处理方式已无法满足需求,大数据技术应运而生,提供高效的数据存储、管理和分析能力。大数据不仅涉及大量数据,更强调快速处理和发现有价值的信息。大数据的应用广泛渗透到各个行业,如广告的精准投放、电信领域的深度包检测、金融的风险识别、能源生物的基因组分析、网络安全的入侵检测、社交游戏的用户行为分析以及电商零售的推荐系统等。

大数据处理框架是支撑这些应用的核心工具,它们分为批处理、流处理和混合处理三大类。批处理框架如Apache Hadoop,基于MapReduce算法处理大规模数据集,适合离线计算;流处理框架如Apache Storm和Apache Samza,专注于实时数据流处理,确保低延迟和高吞吐;混合处理框架如Apache Spark和Apache Flink,兼顾批处理和流处理,提供更灵活的数据处理方案。

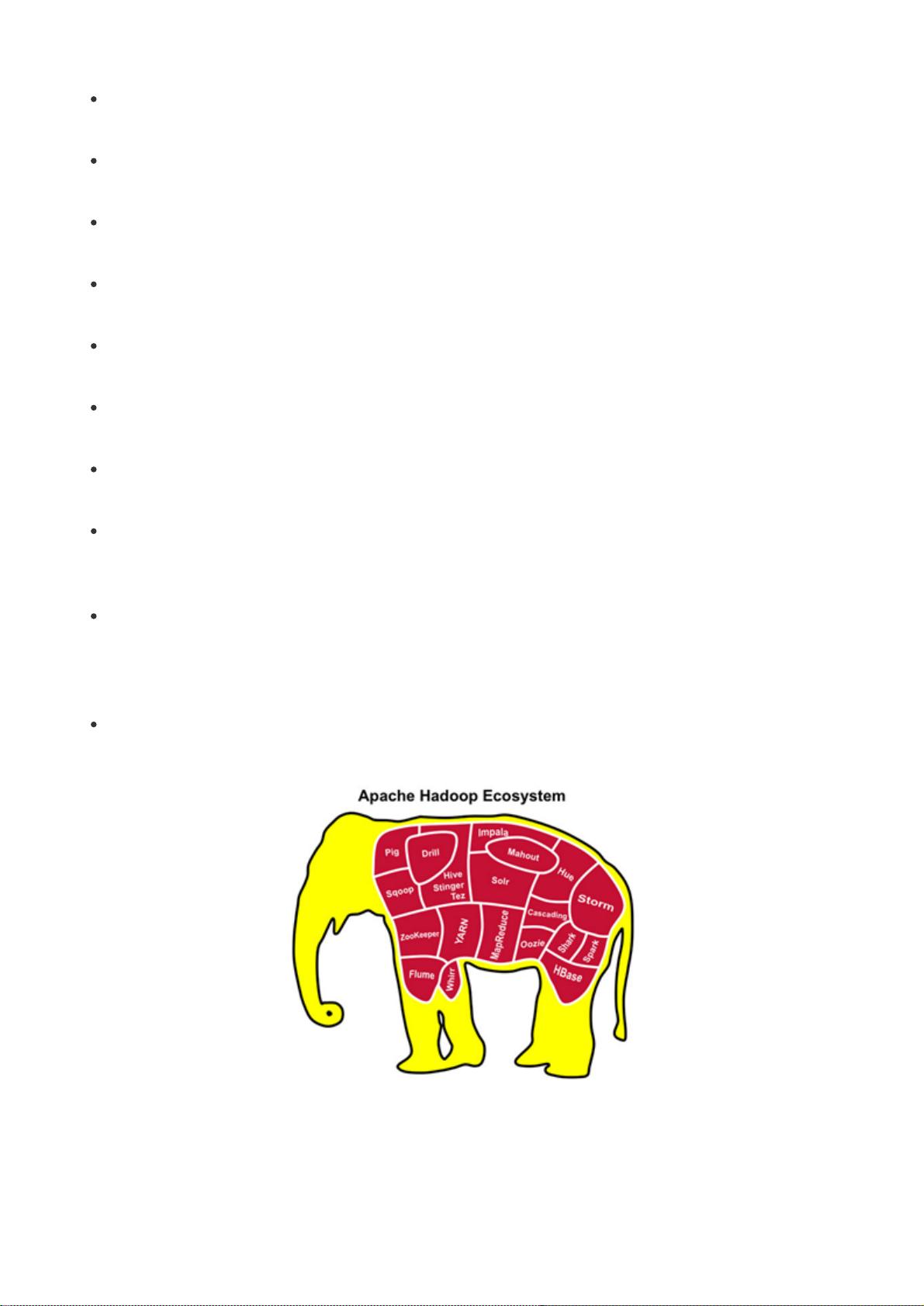

Hadoop作为一个开源项目,起源于2002年的Nutch搜索引擎项目,后来在Google的GFS和MapReduce论文启发下逐渐发展和完善。Hadoop项目主要包含两个核心组件:HDFS(Hadoop Distributed File System)分布式文件系统和MapReduce计算框架。此外,Hadoop生态系统还包括一系列相关项目,如HBase(分布式数据库)、Hive(数据仓库工具)、Pig(数据处理语言)、Zookeeper(协调服务)和YARN(资源管理系统),这些工具共同构建了一个强大的大数据处理平台。

在大数据基础平台的实施与运维中,理解并掌握这些关键技术至关重要。这包括选择合适的处理框架、搭建稳定可靠的Hadoop集群、优化数据处理流程、保障数据安全和进行高效的运维管理。只有深入了解大数据技术的原理和实践,才能有效地利用大数据为业务带来价值。

175 浏览量

2022-11-21 上传

2021-07-05 上传

220 浏览量

2022-10-31 上传

2022-10-31 上传