MATE:Transformer在表格理解与检索上的革新

版权申诉

151 浏览量

更新于2024-08-04

收藏 2.17MB PDF 举报

"Google Research发布的新成果MATE (Multi-view Attention for Table Transformer Efficiency) 是针对表格理解和检索的改进版Transformer模型,旨在解决处理大量行的表格数据时的效率和建模能力问题。"

在自然语言处理领域,Transformer模型已经成为了处理序列数据的首选,尤其在诸如机器翻译、问答系统等任务中表现出色。然而,对于表格这类半结构化数据,尤其是含有大量行的表格,Transformer的传统应用面临着挑战。由于其通常限制输入序列长度为512个token,当表格行数过多时,无法有效处理和理解整个表格结构。

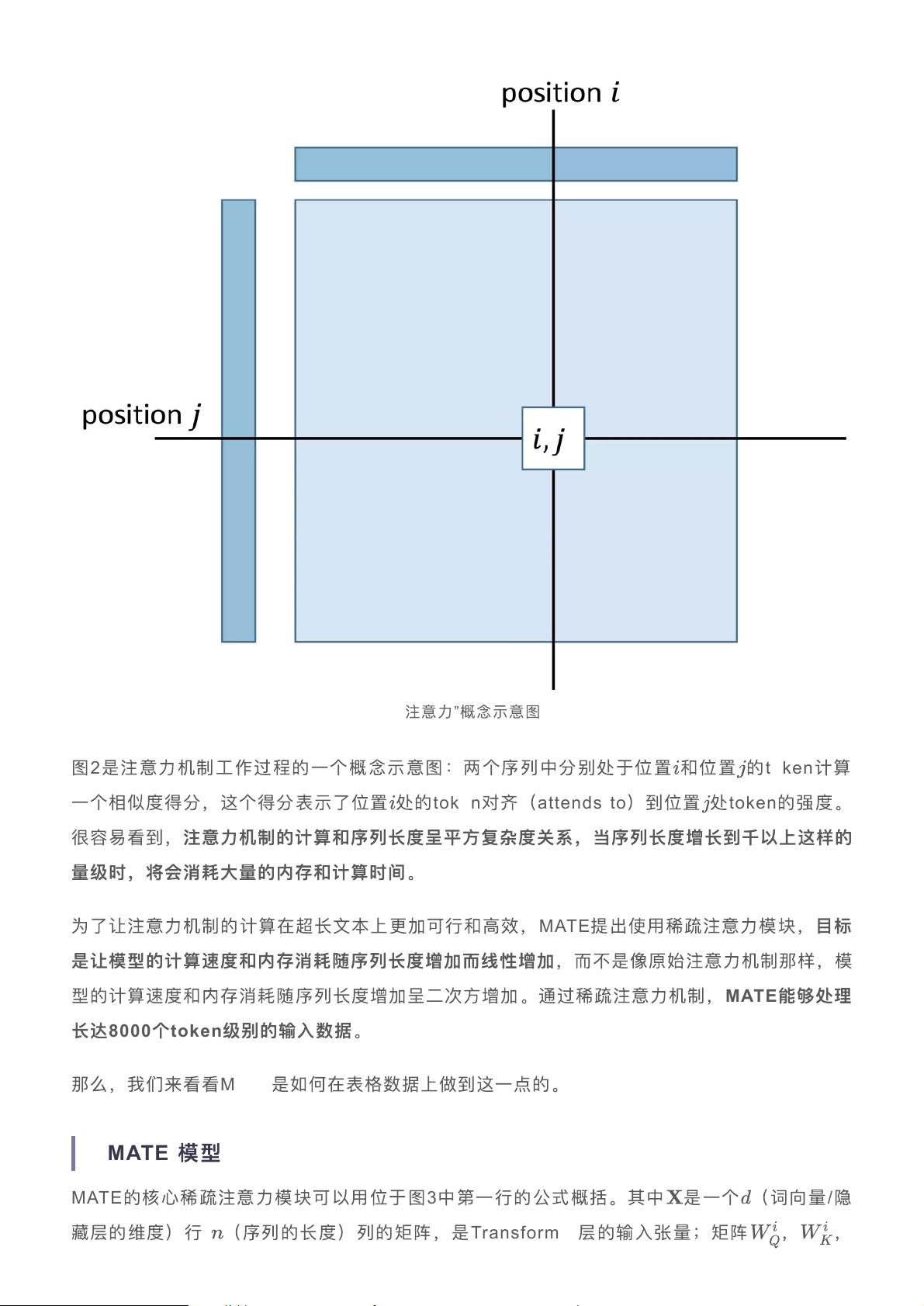

MATE模型应运而生,它专门设计用于高效学习和理解含有众多行的表格数据。论文《MATE: Multi-view Attention for Table Transformer Efficiency》中提出了多视图注意力机制,这一机制能够捕捉表格的行间关系和列间关系,同时解决了长序列处理的效率问题。MATE的核心在于将表格分解为多个较短的视图,每个视图关注表格的不同部分,这样可以避免一次性处理整个表格导致的计算复杂度增加。

在表格问答任务中,MATE模型能够通过理解行和列的关系来定位问题答案,就像人们查找信息时会根据行和列交叉点来找寻答案一样。通过多视图注意力,MATE能够在不牺牲性能的情况下,显著提高处理大规模表格数据的速度,这对于搜索引擎和信息检索系统来说是一个巨大的进步。

此外,半结构化文本如关系型表格,虽然有一定程度的结构,但并不完全符合预定义的数据模式,这使得它们在传统结构化数据处理方法中难以应对。MATE模型的出现,为处理此类数据提供了一个更为灵活且高效的解决方案,推动了表格理解和检索技术的发展。

Google Research的这项工作揭示了Transformer模型在处理表格数据上的潜力,并通过MATE模型提出了一种优化策略,以应对大型表格数据的挑战。这对于AI技术在处理现实世界中的结构化和半结构化数据,尤其是在大数据分析、信息检索和智能助手等场景中,有着深远的影响。

2023-10-18 上传

2023-08-12 上传

2019-01-02 上传

2023-07-28 上传

2023-11-07 上传

2023-04-30 上传

2024-01-12 上传

2024-07-26 上传

2024-01-25 上传

普通网友

- 粉丝: 1272

- 资源: 5619

最新资源

- HYActivityView(iPhone源代码)

- Nacos oracle专用

- rjmco-tfc-gcp-experiments:Terraform Cloud w GCP集成实验

- fontpath-renderer:字体路径字形的通用渲染器

- drl-trainers:深度强化模型训练师

- 手机APP控制,蓝牙LED彩灯制作+ARDUINO源码-电路方案

- Shoply-App-React-Redux

- JoliTypo:Web微型打字机修复程序

- FitnessTracker

- Android文字动画效果源代码

- GLSL-live-editor:基于 Codemirror 的 GLSL 实时编辑器

- 电子功用-大功率中频电源电子平波电抗器

- 基于AT89S52单片机的电子万年历(原理图+汇编程序)-电路方案

- SpeechMatics:简称语音自动识别(ASR),是一种技术,它可以使人们使用自己的声音通过计算机界面以一种最复杂的方式类似于普通人类对话的方式来讲话

- IVEngine(iPhone源代码)

- MATLAB神经网络优化算法.zip