Hadoop云平台上的Apriori算法优化与实现

本文主要探讨了如何利用Hadoop这个大数据处理框架来优化和提升Apriori算法的性能,针对传统Apriori算法在处理大规模、高维度GIS数据时存在的硬件瓶颈、计算效率低和数据库扫描频繁等问题。Hadoop平台,特别是其MapReduce模型和HBase组件,为解决这些问题提供了可能。

Hadoop简介:

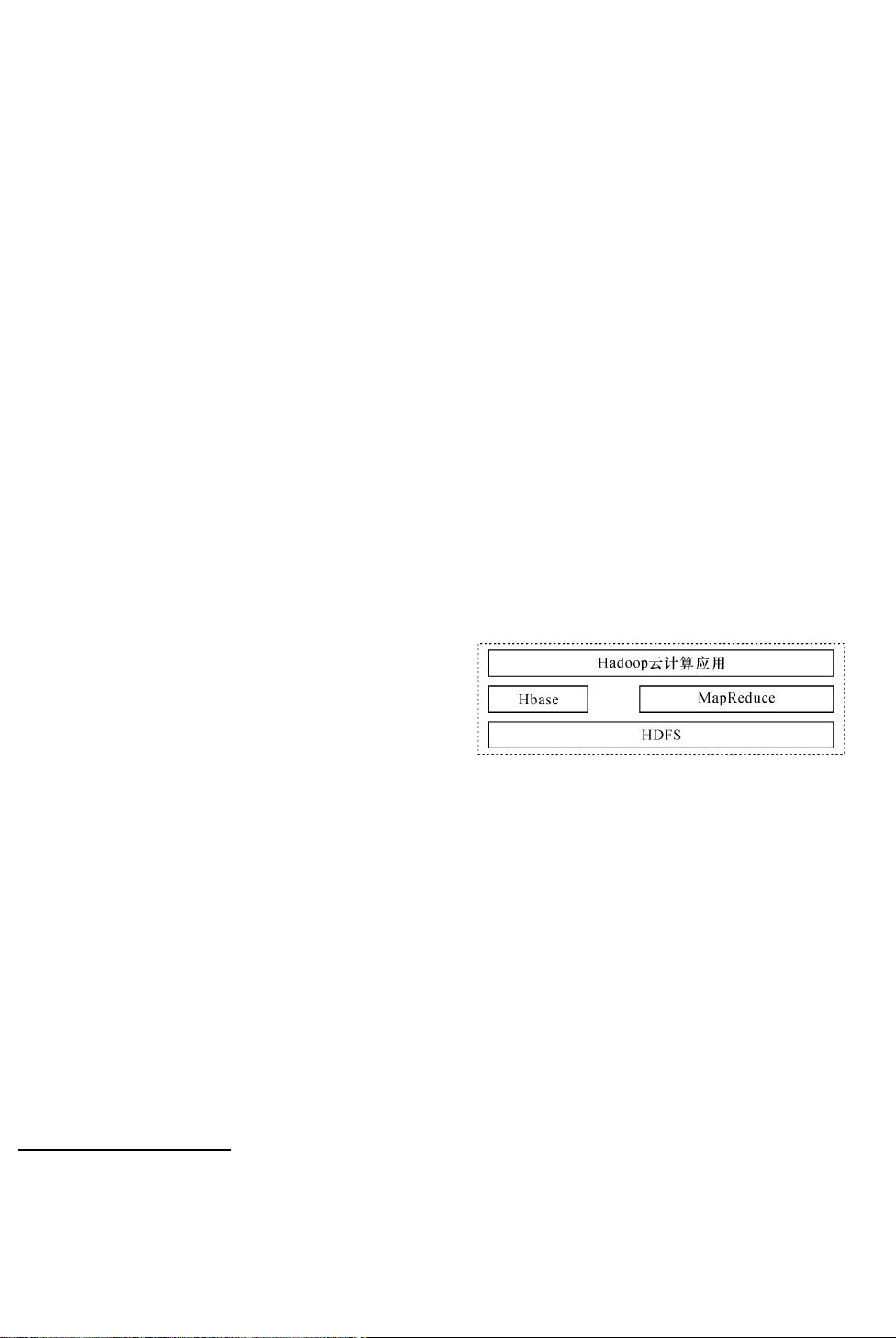

Hadoop是一个开源的分布式计算框架,由Apache软件基金会开发,旨在简化大规模数据集的分布式处理。Hadoop的核心技术包括HDFS(Hadoop分布式文件系统)和MapReduce,前者用于存储和管理海量数据,后者则是一种并行编程模型,通过将复杂的计算任务分解成一系列小任务,分布到集群中的多个节点上执行,极大地提高了处理效率。

HBase作为Hadoop生态系统的一部分,是一个分布式列式数据库,特别适合于处理大量半结构化或非结构化数据,与Hadoop MapReduce模型相结合,可以实现实时数据处理和查询。

基于Hadoop的Apriori算法设计与实现:

文章提出了一个基于Hadoop平台的Apriori算法优化版本,利用MapReduce模型的并行特性,避免了传统Apriori算法中的数据库重复扫描,有效减少了算法运行时间。HBase被用来作为数据存储层,提供高效的数据访问和查询,使得算法在云计算环境下运行,实现了对海量GIS数据的高效挖掘。

与传统Apriori算法相比,新算法在时间和空间复杂度上有所降低,能够更好地应对大规模数据的处理需求。通过对比实验,作者展示了新算法在处理性能上的显著提升,证明了Hadoop和相关技术在大数据挖掘场景中的实际应用价值。

总结:

本文的研究对于大数据时代下的GIS数据分析具有重要意义,展示了如何借助Hadoop和MapReduce的并行计算优势,结合HBase数据库,有效地优化Apriori算法,降低计算成本,提高数据挖掘的效率。这对于推动云计算在数据挖掘领域的广泛应用以及解决实际问题具有重要的参考价值。

788 浏览量

298 浏览量

286 浏览量

311 浏览量

吴小码的IT生涯

- 粉丝: 3

- 资源: 2

最新资源

- salvageo-crx插件

- 空中数控移动

- 易语言专用MP3播放器

- simplelog

- 按键输入与蜂鸣器 - .zip

- libGLESv2_libglesv2_leafga7_sdhyuj_

- 易语言bass可视化效果器

- ArticutAPI:Articut的API中文断词(兼具语意词性标记):「断词」又称「分词」,是中文资讯处理的基础。Articut不用机器学习,不需资料模型,只用现代白话中文语法规则,即能达到SIGHAN 2005 F1-measure 94%以上,召回96%以上的成绩

- local

- Logene归档

- chrome谷歌浏览器驱动(100.0.4896.60)

- sweetheart.py:在Speedlight上构建包括AI在内的全栈Web应用程序

- expansion_game:用 HTML 和 JS 重新制作“生命游戏”

- 标题::beach_with_umbrella:轻松培训和部署seq2seq模型

- react-webpack-starter:使用React,Webpack和Bootstrap的入门

- proxmox-dns