Hadoop2.7.4 & Spark2.2.1 集群环境搭建指南

该资源提供了一种在三台服务器上构建Hadoop 2.7.4和Spark 2.2.1集群环境的方法,适用于学习环境搭建。在Linux系统中,使用JDK 1.8作为运行环境。文档涵盖了用户添加、文件权限设置以及Hadoop和Scala的安装步骤。

集群环境搭建主要涉及以下知识点:

1. **Linux基础操作**:

- **增加用户**:在Linux中,使用`useradd`命令创建新用户,例如`useradd bigdata`,然后通过`passwd bigdata`设置用户密码。

- **文件权限管理**:利用`chgrp`和`chown`命令改变文件或目录的所有者和组。`-R`选项用于递归更改,适用于整个目录结构。

2. **目录结构规划**:

- 创建一个特定的应用程序目录,如`/usr/application`,并将其所有权分配给新用户。这可以通过`mkdir`创建目录,`chgrp`和`chown`改变所有者和组来实现。

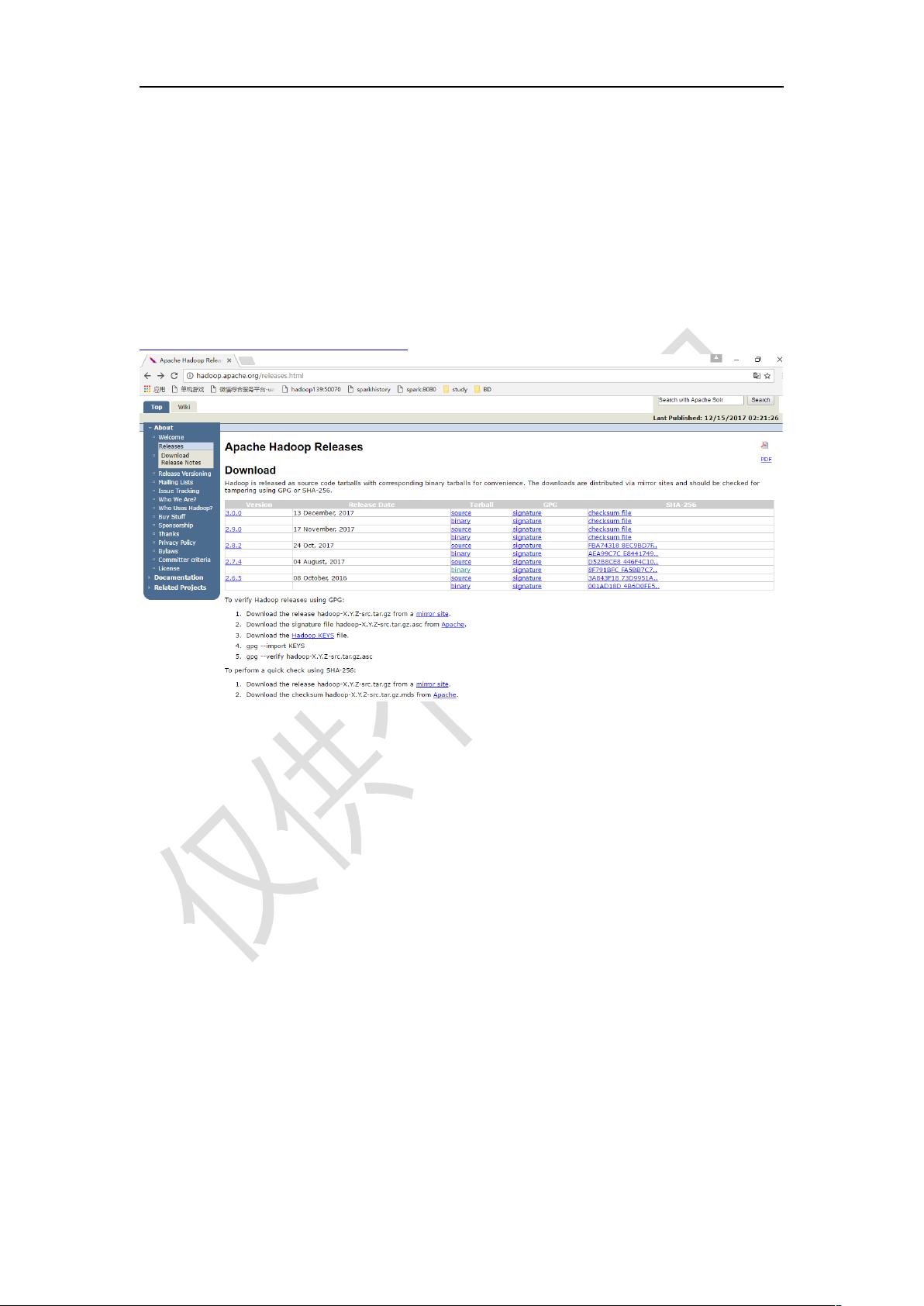

3. **Hadoop安装**:

- **集群规划**:Hadoop安装通常涉及多台机器,这里是在现有的Hadoop 2.7.4集群上添加Spark集群。在一台机器上部署Master(例如,IP为150的节点),在其他机器上部署Slave(例如,IP为151和152的节点)。

4. **Scala安装**:

- **版本选择**:选择安装Scala 2.11.8。

- **解压缩**:使用`chmod`改变文件权限,然后用`tar`命令解压缩。

- **创建软链接**:为了方便未来版本切换,创建一个指向Scala安装目录的软链接。

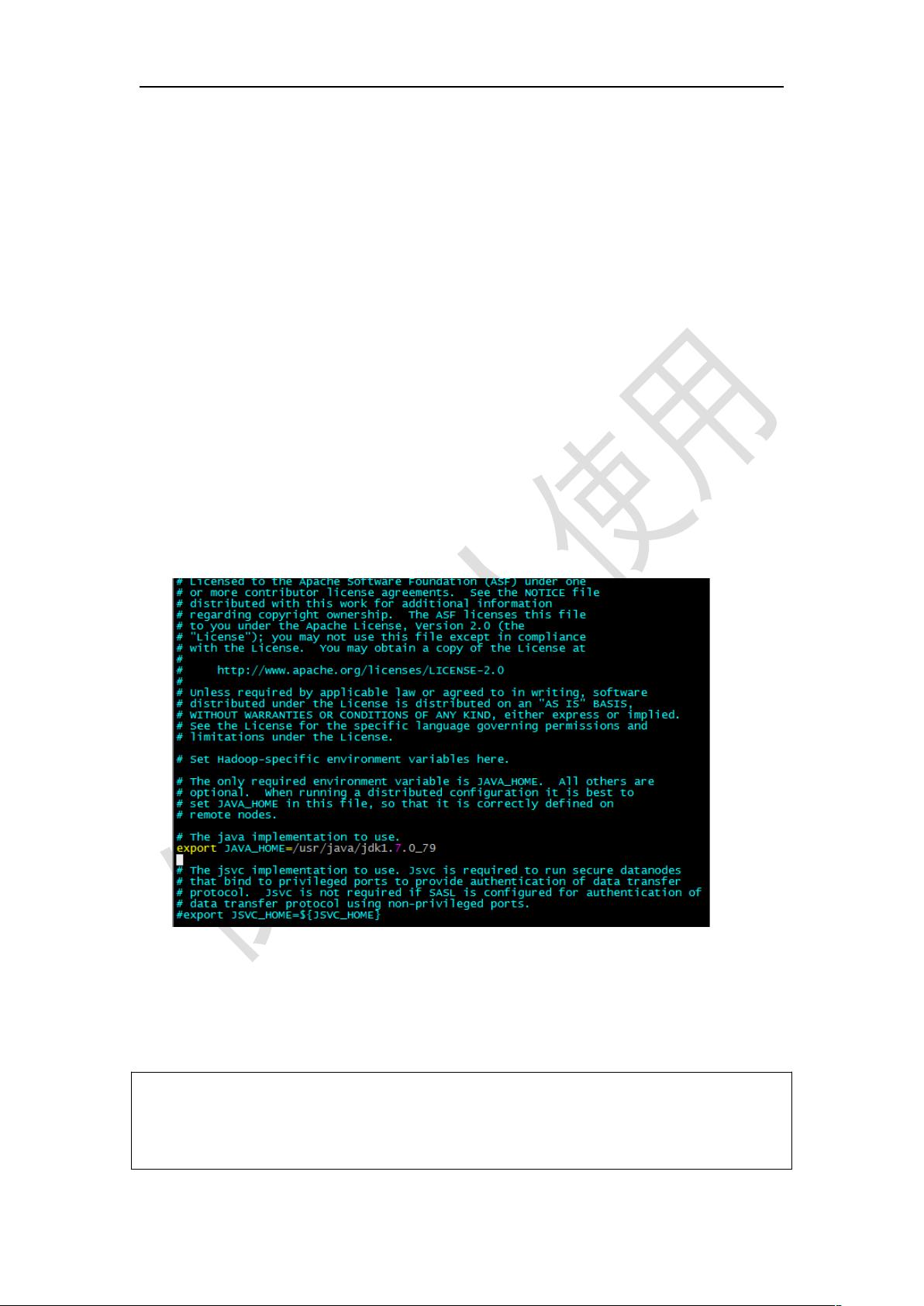

- **配置环境变量**:通过编辑`/etc/profile`文件,设置`JAVA_HOME`, `SCALA_HOME`和`SPARK_HOME`等环境变量。

5. **Spark安装**:

- 安装路径没有在摘要中详细说明,但通常会类似Scala,将Spark解压缩到`/usr/application`目录下,并创建相应的环境变量。

6. **环境变量配置**:

- 在`/etc/profile`中,除了设置`JAVA_HOME`和`SCALA_HOME`,还需要配置`SPARK_HOME`,并确保`CLASSPATH`包含所有必要的库。

请注意,这个摘要仅提供了基本的环境搭建步骤,不涉及具体的开发技术逻辑。对于实际的开发工作,还需要进一步了解Hadoop和Spark的相关API、数据处理模型以及集群管理等方面的知识。此外,为了保证集群的稳定运行,还需要关注网络配置、安全性设置以及监控等高级主题。

235 浏览量

189 浏览量

点击了解资源详情

449 浏览量

644 浏览量

189 浏览量

216 浏览量

254 浏览量

335 浏览量

favorbob

- 粉丝: 2

最新资源

- SVN服务器搭建与客户端使用指南

- 修复Google Maps v2-crx插件,解决2013年后地图显示问题

- STM32F103ZET6下AS608指纹模块ID库获取程序

- allpairs软件测试工具:参数组合的高效解决方案

- Quarkus框架开发的Smart Hub,构建可持续智能家居系统

- Flux Hot Loader:革新 Flux 商店开发的热替换工具

- 折叠工具栏布局效果展示与实现

- 基于Struts2+Spring+Hibernate的SSH开发环境部署指南

- J2Team Dark Theme插件发布:优化你的浏览体验

- 李亦农《信息论基础教程》课后答案2-4章详细解析

- 霍尼韦尔PC42t打印机配置工具使用指南

- JDK 1.8 免安装压缩包下载

- CC3D飞控电路图及PCB设计资源包下载

- 探索Kotlin打造的ImageBrowserApp

- 解决Windows下Nginx PHP环境问题的Nginx辅助器

- 精选20款商务风小清新PPT模板下载