Spark入门与高效实践: RDD核心与使用模式详解

Spark使用总结与分享

在IT领域中,Spark是一种广泛应用于大数据处理的开源框架,特别受到数据科学和机器学习团队的青睐。本文主要针对初学者和项目组成员,总结了作者在使用Spark过程中积累的经验和关键知识点。

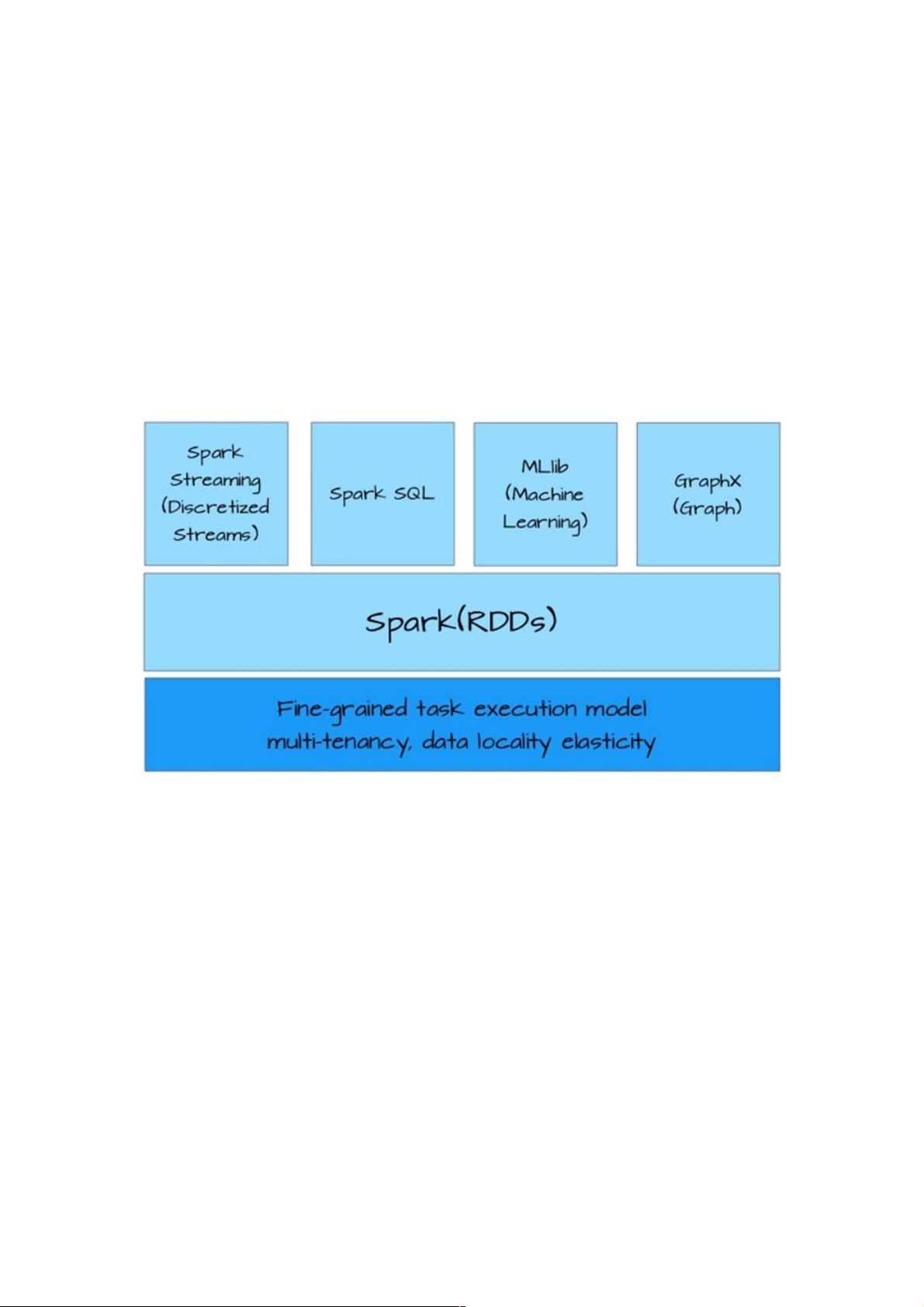

首先,Spark的核心组件是RDD(弹性分布式数据集),它是Spark架构的基础。RDD是一个不可变、分布式的数据结构,它封装了诸如map、filter、reduce等基本数据操作,提供了一种高效的数据共享抽象。与其他大数据处理框架如MapReduce、Pig、DryadLINQ和Hive相比,RDD的优势在于其数据共享的能力,使得它更适用于通用的数据处理任务。

在Spark的工作流程中,操作主要分为两类:转换(Transformation)和动作(Action)。转换是对数据进行操作但不立即产出结果,而是返回一个新的RDD,例如filter或map,这利用了懒加载的策略,即只在实际需要时才执行计算。动作则相反,它们直接产出结果,如count或collect,这些操作会触发真正的数据计算。

使用RDD时,推荐遵循一定的模式:首先加载外部数据并创建RDD,然后根据需求进行转换,如筛选或变换数据,接着对重要的数据进行缓存以提高性能,最后通过动作触发并行计算。这种模式有助于简化逻辑,避免在MapReduce中因过度优化导致代码复杂。

Spark的性能卓越,官方声称在某些特定场景下其计算效率可达Hadoop的20倍。这得益于RDD的高效设计,如数据的分区和并行计算能力,以及惰性执行策略。然而,实际效能的提升还取决于具体的应用场景、数据规模和硬件配置。

理解并熟练运用RDD是掌握Spark的关键。通过遵循正确的使用模式,结合Spark的高效特性,可以极大地提升大数据处理的效率和代码的可读性。对于团队协作来说,分享这样的经验能够帮助新成员更快地融入和成长。

701 浏览量

2024-07-18 上传

2024-07-18 上传

2024-07-18 上传

2024-07-18 上传

371 浏览量

2024-07-18 上传