回归算法详解:机器学习基石与应用

需积分: 50 52 浏览量

更新于2024-07-19

收藏 2.23MB DOCX 举报

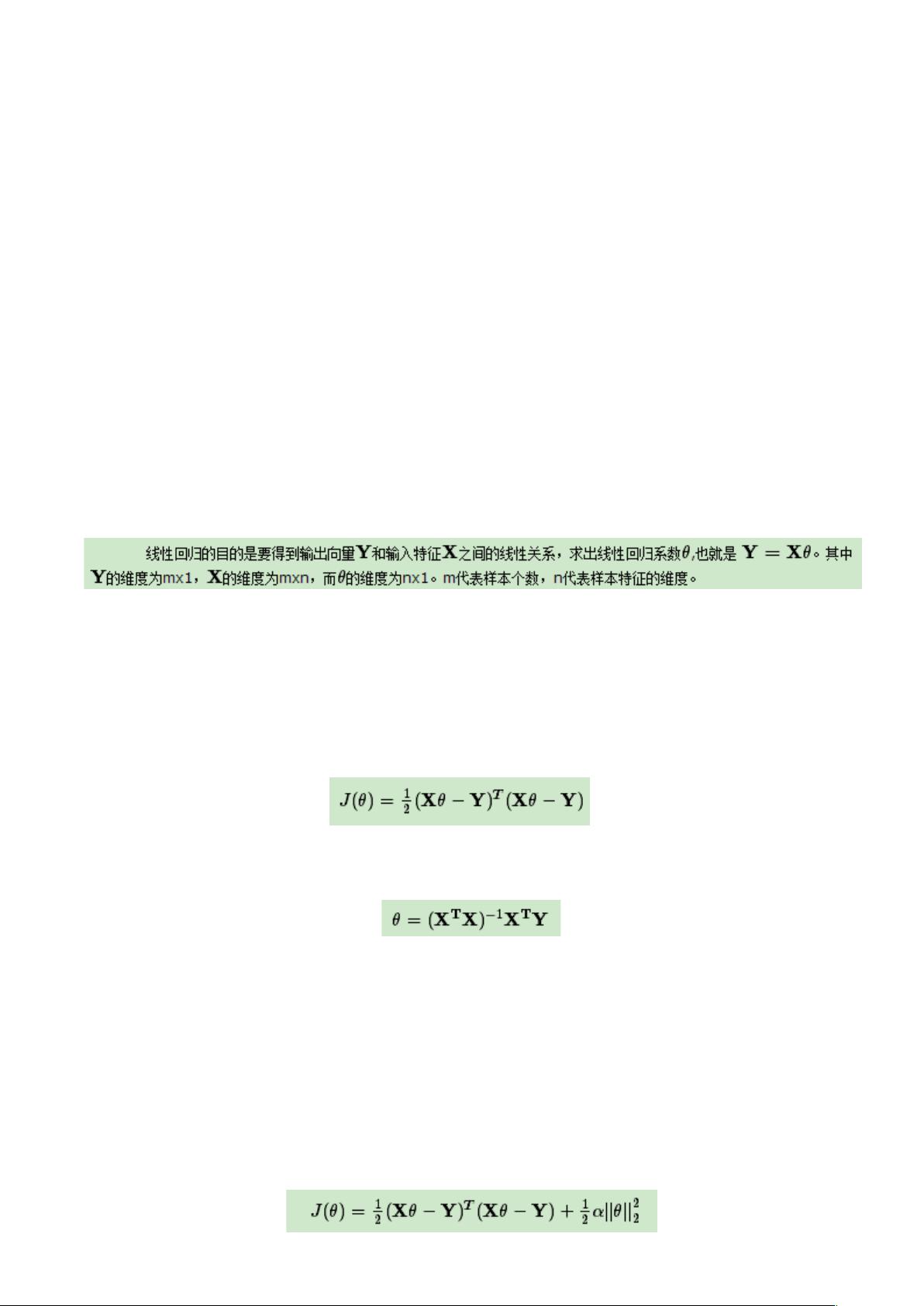

本文档深入总结了机器学习中常用的回归算法以及相关的核心概念。回归算法是通过数学模型找到输入特征与输出值之间关系的一种方法,主要分为线性回归和逻辑回归两类。线性回归用于处理连续数值预测,其基本模型为y = w'x + e,其中e为随机误差,满足正态分布。线性回归在工业界常用于预测任务,并在如SVM、GBDT、AdaBoost等算法中有重要应用。

逻辑回归则针对离散值或类别预测,虽然输出的是类别概率,但它也可视为回归的一种特殊形式。逻辑回归常被用于分类问题中的排序,是面试中常见的考核知识点。损失函数在此扮演关键角色,它衡量模型预测的准确度,定义为预测值与实际值的平均距离,目标是通过调整参数使损失函数减小。

梯度下降算法是优化损失函数的有效方法,它模拟下山过程,每次根据梯度方向调整参数,使得损失函数逐步降低。学习率(α)控制着更新步长,过大可能引发震荡,过小可能导致收敛缓慢。在实际应用中,通常采用自适应学习率策略,或者根据经验选择合适的固定值,如0.01。

牛顿法作为另一种优化手段,尽管计算复杂度较高,但在小数据集上表现优异。在机器学习的实际项目中,理解并熟练掌握这些基础算法及其背后的原理,对于构建高效准确的模型至关重要。无论是理论研究还是工程实践,回归算法都是机器学习不可或缺的一部分,值得深入学习和实践。

555 浏览量

111 浏览量

104 浏览量

2203 浏览量

256 浏览量

324 浏览量

wangyawei602

- 粉丝: 0

最新资源

- 全面详实的大学生电工实习报告汇总

- 利用极光推送实现App间的消息传递

- 基于JavaScript的节点天气网站开发教程

- 三星贴片机1+1SMT制程方案详细介绍

- PCA与SVM结合的机器学习分类方法

- 钱能版C++课后习题完整答案解析

- 拼音检索ListView:实现快速拼音排序功能

- 手机mp3音量提升神器:mp3Trim使用指南

- 《自动控制原理第二版》习题答案解析

- 广西移动数据库脚本文件详解

- 谭浩强C语言与C++教材PDF版下载

- 汽车电器及电子技术实验操作手册下载

- 2008通信定额概预算教程:快速入门指南

- 流行的表情打分评论特效:实现QQ风格互动

- 使用Winform实现GDI+图像处理与鼠标交互

- Python环境配置教程:安装Tkinter和TTk