基于Multi-Camera Joint 3D检测和分割的BEV表示

需积分: 0 124 浏览量

更新于2024-06-13

收藏 10.85MB PPTX 举报

"Multi-Camera Joint 3D Detection and Segmentation with Unified Bird's-Eye View Representation"

基于Multi-Camera Joint 3D Detection and Segmentation with UnifiedBird's-Eye View Representation的技术,旨在解决自动驾驶行业中两个关键任务:3D物体检测和BEV分割。该方法提出了一种统一的BEV特征表示,称为M²BEV架构,该架构可以实现高效的BEV编码器和检测头。

**技术背景**

当前自动驾驶行业的主要任务包括3D物体检测和BEV分割。3D物体检测是指在图像中检测和定位三维物体的位置、大小和方向,而BEV分割是指将图像分割成不同的区域,以便更好地理解场景中的物体和环境。这些任务都是自动驾驶系统中的关键组件,但它们也存在一些挑战,例如如何处理多个摄像机的数据、如何实现高效的BEV特征表示等。

**M²BEV架构**

M²BEV架构是该方法的核心组件,它可以实现高效的BEV编码器和检测头。该架构由多个组件组成,包括可变形卷积、ResNet-50、ResNeXt-101、检测头和分割头。可变形卷积用于图像主干网络,ResNet-50和ResNeXt-101用于特征提取,检测头用于预测类别、边界框和方向,分割头用于分割图像。

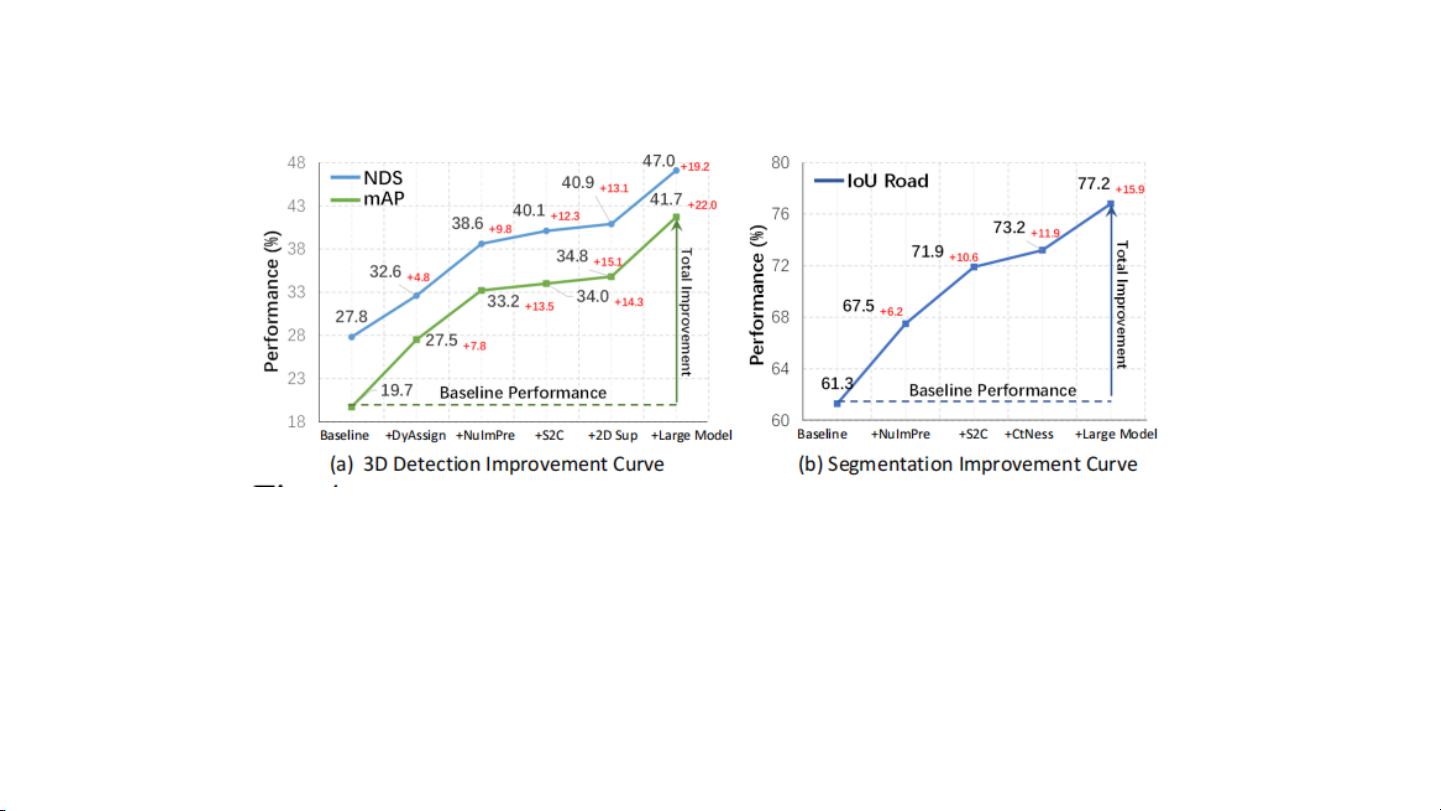

**消融实验**

为了验证M²BEV架构的有效性,作者进行了一系列消融实验。这些实验包括:

* 大规模2D预训练(+NuImPre):该实验表明了预训练的重要性,它可以提高模型的性能。

* 空间到通道的操作(+S2C):该实验表明了空间到通道的操作可以提高模型的性能。

* 2D辅助监督(+2DSup):该实验表明了2D辅助监督可以提高模型的性能。

* BEV中心度(+CtNess):该实验表明了BEV中心度可以提高模型的性能。

* 使用更大的模型(+LargeModel):该实验表明了使用更大的模型可以提高模型的性能。

**实验结果**

该方法在nuScenes数据集上的实验结果表明,它可以实现state-of-the-art的性能。nuScenes数据集包含1000个视频序列,每个序列包含一个LiDAR扫描和六个摄像机的图像。实验结果表明,该方法可以实现高精度的3D物体检测和BEV分割。

**网络架构**

该方法的网络架构包括可变形卷积、检测头和分割头。可变形卷积用于图像主干网络,检测头用于预测类别、边界框和方向,分割头用于分割图像。该架构可以实现高效的BEV编码器和检测头。

**实现细节**

该方法的实现细节包括:

* 优化器:AdamW优化器,学习率为1e-3,权重衰减为1e-2。

* 训练周期:12个epochs,使用“poly”策略逐渐减少学习率。

* 批量大小:每GPU1个样本,每个样本有6张图像。

* 输入分辨率:固定为1。

该方法提出了一种统一的BEV特征表示,称为M²BEV架构,该架构可以实现高效的BEV编码器和检测头。该方法可以实现state-of-the-art的性能,并且可以应用于自动驾驶行业中。

2021-06-01 上传

252 浏览量

346 浏览量

2024-05-10 上传

2022-09-24 上传

2021-02-07 上传

2024-10-27 上传

409 浏览量

m0_72986368

- 粉丝: 0

最新资源

- React中创建带步骤的进度条库ReactStepProgressBar解析

- VC ListCtrl 控件使用示例分析

- JLink V648B官方版发布:下载安全无毒的调试软件

- 跨平台TCP终端:脚本化自动响应与串行通信

- 使用证书验证连接Couchbase的Spring-boot查询服务教程

- YUYV图像工具:高效打开YUYV格式图片

- 蓝色经典企业WAP网站源码包:包含各类技术项目资源与使用说明

- 传真配置必备DLL组件:安装与验证指南

- 构建通用API桥梁:在多平台中实现灵活应用开发

- ECSHOP支付宝个人免签快速支付插件安装教程

- 掌握Ruby应用错误监控:Bugsnag深度解析

- Java METAR和TAF数据分析器WeatherParser介绍

- fanuc机器人地轨附加轴设定与操作教程

- XP系统SNMP安装与配置指南

- MATLAB多项式混沌展开工具箱

- 深入解析二回路过载自动驾驶仪程序设计