通用网络爬虫详解:架构、策略与工作流程

需积分: 50 125 浏览量

更新于2024-09-03

收藏 683KB PDF 举报

通用网络爬虫综述深入探讨了现代网络信息获取的重要工具——爬虫。网络爬虫是一种程序,能够遵循一定的规则,有组织地从互联网上抓取URL链接和页面内容,主要用于搜索引擎的数据源,但随着数据量的增长,也被广泛应用于各种专业领域,如金融、信贷、基金和社交媒体信息获取。

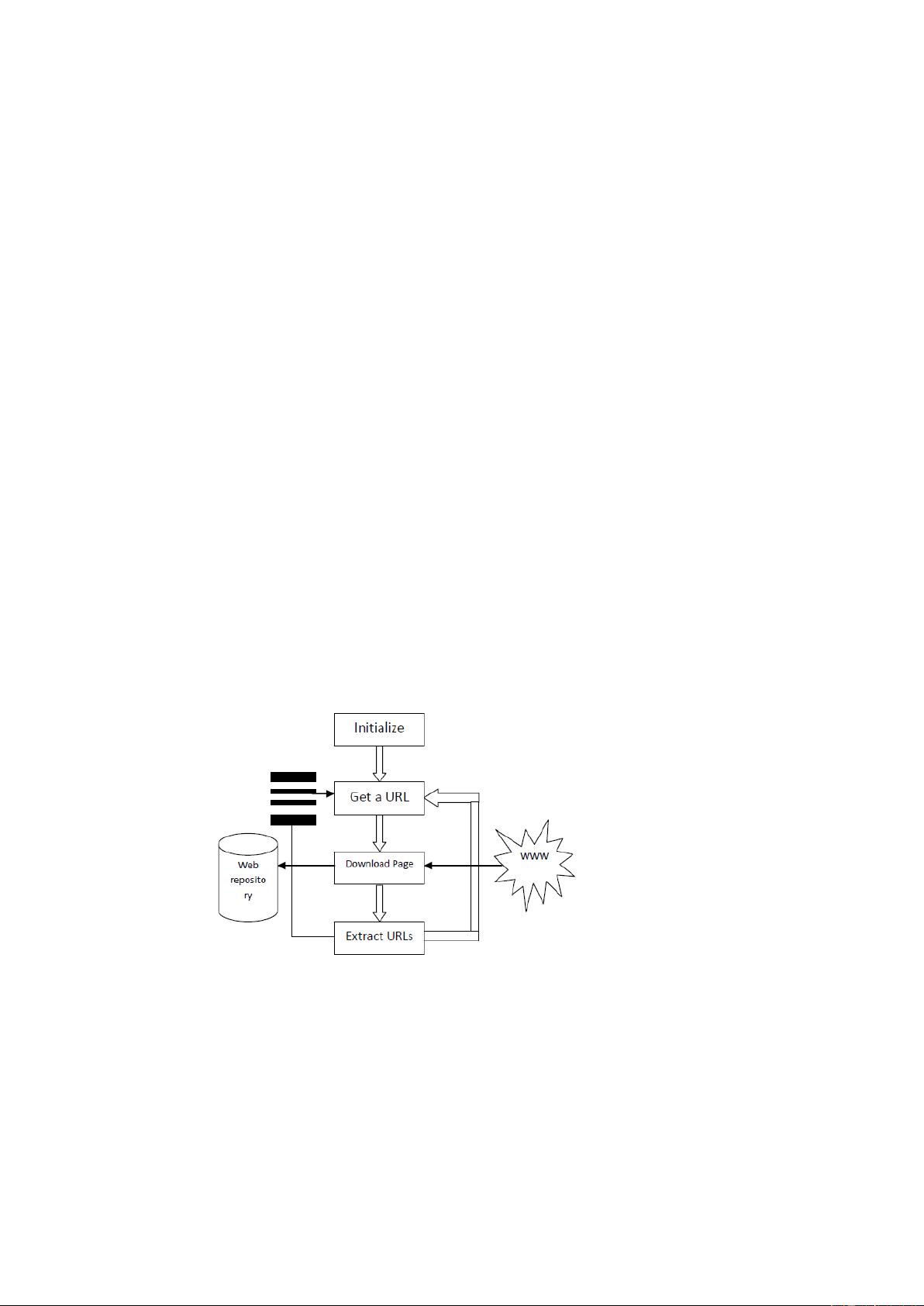

爬虫的核心工作流程包括:首先设定种子URL集合,然后将其加入待爬取队列;接着从队列中取出URL,获取网页内容并保存,解析网页以发现新的URL;这个过程会持续进行,直到满足停止条件,如队列为空。整体架构上,网络爬虫可分为集中式和分布式。集中式适合小型任务,但由于资源限制,对于大规模的通用爬虫,分布式架构更优,它能实现任务的高效分发和爬取器的协同工作。

分布式爬虫设计的关键在于任务管理和页面爬取的分离。在主从式架构中,有一个中央控制器节点管理所有运行的爬虫,负责URL排序、任务分配和节点间的通信。此外,还有增量爬取和系统稳定性控制等功能,确保爬虫能持续、稳定地执行任务。其他可能的分布式架构类型还包括基于消息队列的架构,以及P2P(点对点)网络结构,它们各自有其优缺点,适用于不同的应用场景和需求。

在技术细节上,通用爬虫涉及多种关键技术,例如高效的URL筛选和排序算法以减少重复抓取,网页去重策略防止重复资源占用带宽,以及应对动态网页的抓取策略,如使用Selenium等工具模拟用户行为。同时,还需要考虑如何对抗网站的反爬虫机制,如设置User-Agent、处理验证码等,以保持爬虫的合规性和有效性。

通用网络爬虫作为一种强大的信息采集工具,不仅要求开发者具备编程技能(如Python),还需深入理解网络协议、数据结构、算法优化以及如何适应不断变化的互联网环境。随着数据科学和人工智能的发展,爬虫技术将在数据分析、知识挖掘等领域发挥更大的作用。

2021-11-08 上传

2023-09-07 上传

2023-10-15 上传

2023-11-21 上传

2023-05-17 上传

2023-05-17 上传

2023-12-23 上传

2023-06-08 上传

2023-05-31 上传

DataWizard~

- 粉丝: 2666

- 资源: 5

最新资源

- ASP.NET数据库高级操作:SQLHelper与数据源控件

- Windows98/2000驱动程序开发指南

- FreeMarker入门到精通教程

- 1800mm冷轧机板形控制性能仿真分析

- 经验模式分解:非平稳信号处理的新突破

- Spring框架3.0官方参考文档:依赖注入与核心模块解析

- 电阻器与电位器详解:类型、命名与应用

- Office技巧大揭秘:Word、Excel、PPT高效操作

- TCS3200D: 可编程色彩光频转换器解析

- 基于TCS230的精准便携式调色仪系统设计详解

- WiMAX与LTE:谁将引领移动宽带互联网?

- SAS-2.1规范草案:串行连接SCSI技术标准

- C#编程学习:手机电子书TXT版

- SQL全效操作指南:数据、控制与程序化

- 单片机复位电路设计与电源干扰处理

- CS5460A单相功率电能芯片:原理、应用与精度分析