"深层神经网络优化算法及Mini-batch梯度下降方法探讨"

需积分: 0 117 浏览量

更新于2024-01-02

收藏 4.39MB PDF 举报

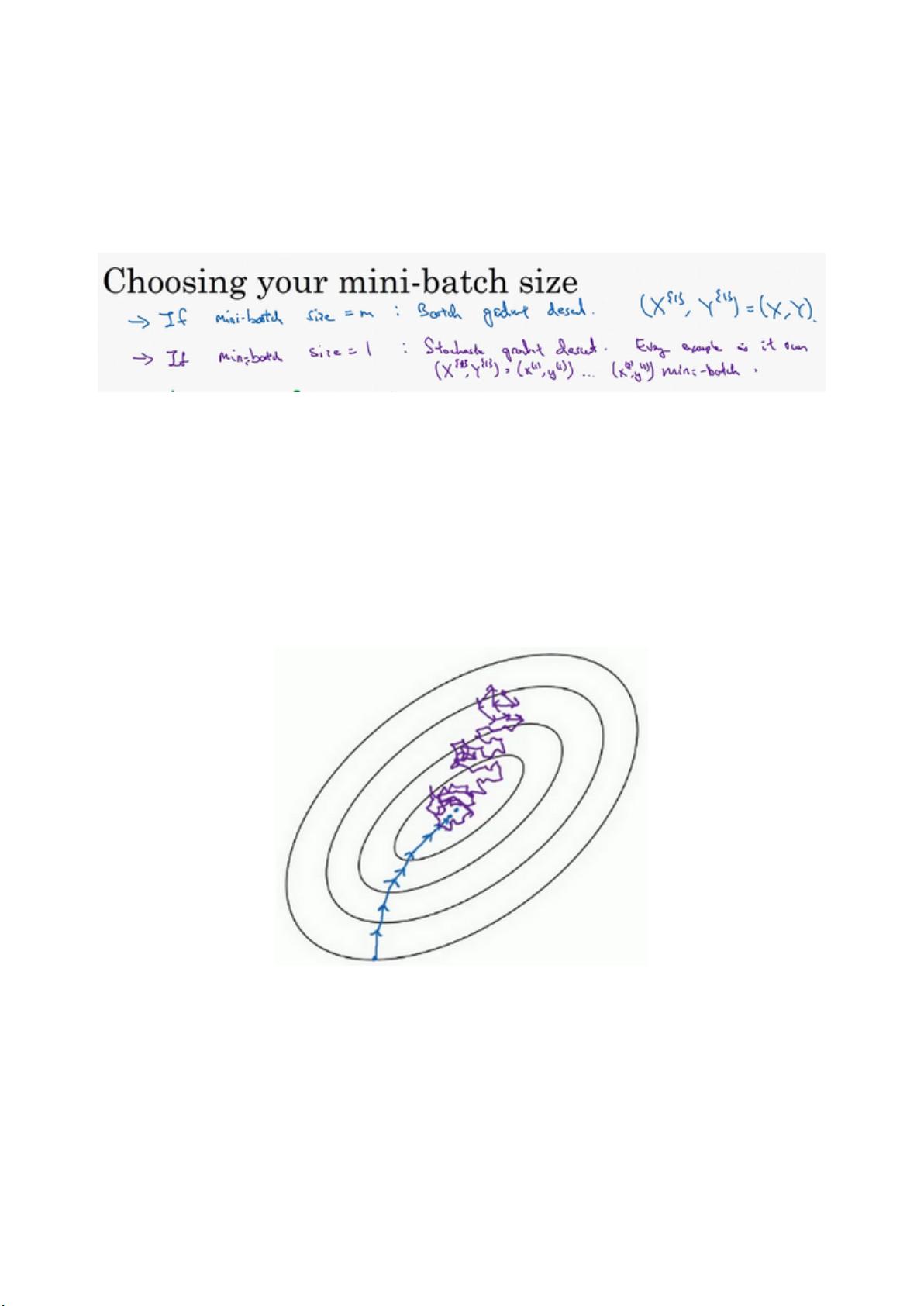

本段描述提到了"06-改善深层神经网络week21"和"Optimization algorithms"等内容。其中,介绍了Mini-batch gradient descent算法和它的优点。Mini-batch是一种改进的梯度下降算法,它将数据集分成多个小批量(mini-batch),在每个批量上计算梯度并进行参数更新,以此来加速模型训练的过程。相比于使用整个数据集进行梯度下降,mini-batch的方法具有更高的计算效率和更好的泛化性能。

Mini-batch gradient descent的优点包括:

1. 计算效率高:相比使用整个数据集进行梯度下降,mini-batch算法在每个批量上计算梯度,从而大大减少了计算量。在大规模的数据集上,可以显著加速模型训练的速度。

2. 内存利用率高:使用整个数据集进行梯度下降会占用大量的内存空间,而mini-batch算法只需要存储当前批量的数据,内存利用率更高。

3. 更好的泛化性能:mini-batch算法通过在每个批量上计算梯度,可以减少模型的过拟合。每个批量的数据都可以看作是从整个数据集中独立采样得到的,通过迭代更新参数,模型可以更好地适应整个数据集的分布。

4. 收敛速度快:相比于使用整个数据集进行梯度下降,mini-batch算法的参数更新更加频繁,能够更快地找到局部最优解。

然而,Mini-batch gradient descent算法也存在一些问题。首先,选择合适的批量大小是一个关键的问题。如果批量大小较小,计算梯度的方差较大,可能会导致训练不稳定;如果批量大小较大,每次更新参数的时间会增加。其次,mini-batch算法的性能也很大程度上依赖于学习率的选择,需要通过调试和实验来确定最优的学习率。此外,mini-batch算法在处理具有噪声的数据时可能会受到影响,因为每个批量的数据都可能包含不准确的标签或异常值。

综上所述,Mini-batch gradient descent是一种改进的梯度下降算法,具有计算效率高、内存利用率高、泛化性能好和收敛速度快等优点。然而,适当选择批量大小和学习率,并注意处理数据噪声等问题是使用mini-batch算法的关键。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-04 上传

2022-08-04 上传

点击了解资源详情

ShenPlanck

- 粉丝: 951

- 资源: 343

最新资源

- gulishop_backend:一个基于vue和element-ul的二次开发项目

- capstone_cunysps

- google-homepage

- M1905播放器易语言源码-易语言

- DbfExporter-开源

- INFO6105_repo:数据科学工程存储库

- KCcoroutine:协程

- react-frec:这是一个类型库,用于编写简单的“ React.forwardRef”和“ React.ForwardRefExoticComponent”

- 0601、单电源运放图解资料手册.rar

- 删除重复文本-易语言

- alpine-droplet:用于数字海洋的Alpine Linux图像生成器

- landify:这是我在2020年11月进行的第一个项目

- 0548、单片机原理与应用实验指导书.rar

- movie_api

- DiskMonitor:适用于macOS的Apple DiskArbitration框架的简单包装程序包

- 位图结构易语言演示源码-易语言