高效深度学习实践:模型压缩、优化与硬件加速

需积分: 9 94 浏览量

更新于2024-07-09

收藏 5.53MB PDF 举报

"这篇综述论文《高效深度学习:更小、更快、更好》由Google Research的研究员Gaurav Menghani撰写,旨在探讨如何优化深度学习模型,使其在保持高性能的同时,减少参数数量、降低延迟时间和减少训练资源需求。文章深入分析了深度学习效率的重要性,并对五个核心效率领域进行了详尽的调查,包括建模技术、基础设施和硬件优化。此外,该论文还提供了一个基于实验的指导,以及代码示例,帮助实践者优化模型的训练和部署。这是深度学习效率领域的首份全面调查,覆盖了从建模技术到硬件支持的模型效率全貌。作者希望这份调查能够为深度学习社区提供有价值的参考,推动更高效的学习算法和系统的发展。"

本文首先阐述了深度学习在多个领域取得的突破性进展,但随着模型的复杂度增加,随之而来的是模型大小、运行延迟和训练成本的显著增长。这引发了对于模型效率的关注,因为仅仅追求性能的提升并不足以满足实际应用的需求。论文接下来深入探讨了模型效率问题,指出在设计和优化深度学习模型时,需要综合考虑其对计算资源、内存和时间的影响。

论文的核心内容分为五个部分:

1. **建模技术**:讨论了各种轻量级模型架构,如MobileNet、ShuffleNet和 EfficientNet等,它们通过网络结构的创新,如深度可分离卷积、通道 shuffle 等,实现了模型的减小和性能的平衡。

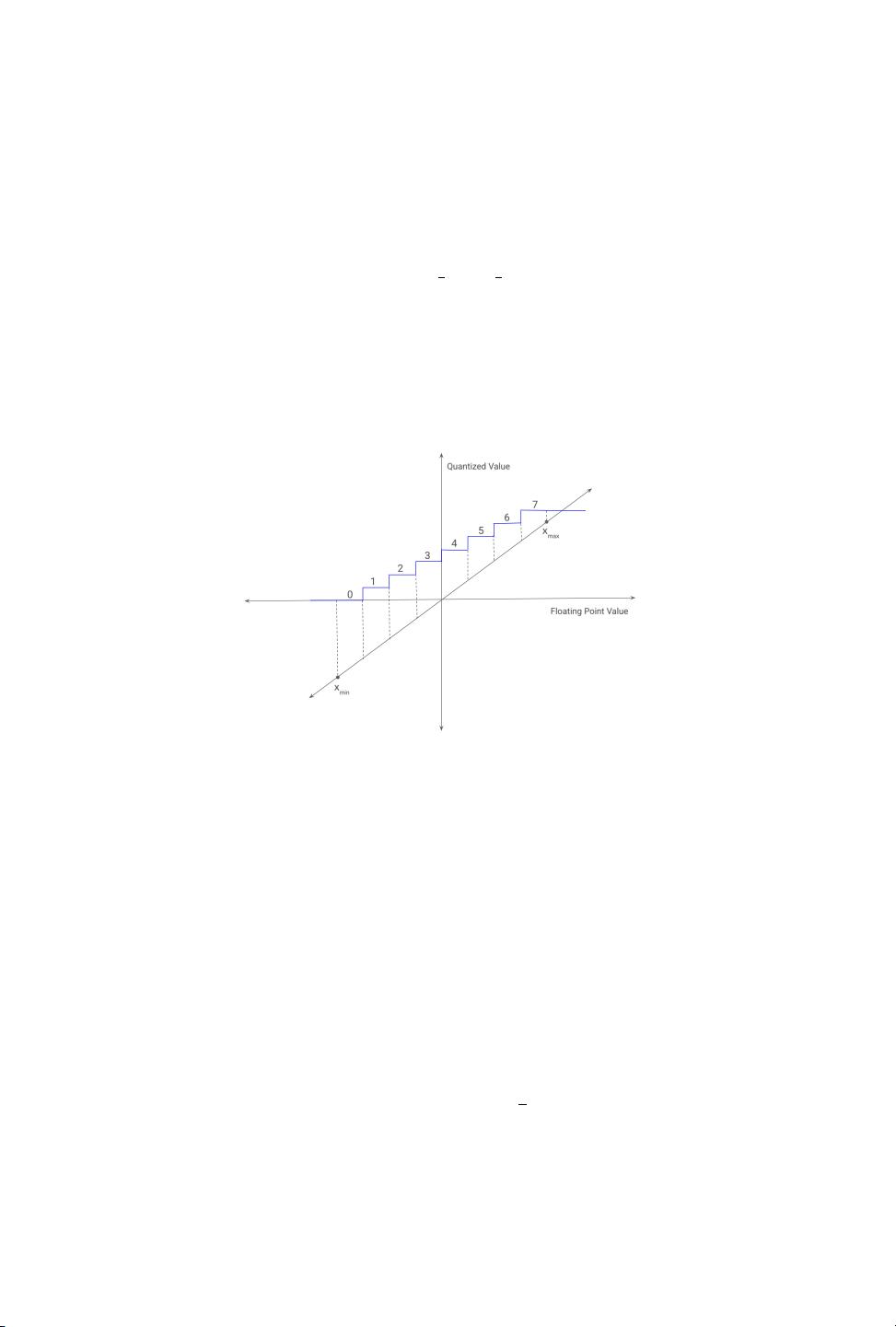

2. **量化和压缩**:研究了权重和激活的量化技术,如二值化、低精度表示,以及模型压缩方法,如知识蒸馏,这些都能有效减少模型大小,同时保持或提高性能。

3. **优化算法**:介绍了动量优化、自适应学习率策略(如Adam)、二阶优化方法等,以及如何选择合适的优化器以提高训练速度和效果。

4. **基础设施**:涵盖了分布式训练、数据并行和模型并行的策略,以及GPU、TPU等硬件加速方案,这些都是提高训练和推理效率的关键。

5. **硬件优化**:讨论了针对特定硬件的模型定制,如针对边缘设备的优化,以及新兴的硬件技术如何支持更高效的深度学习计算。

此外,论文还提供了实验指南和代码,以帮助开发者实践这些优化策略,包括模型的训练配置、超参数调整和性能基准测试。

这份综述论文是深度学习从业者的重要参考资料,它总结了当前的高效深度学习研究,并为未来的工作指明了方向,强调了在追求深度学习模型性能的同时,不能忽视效率问题,必须寻求更小、更快、更好的解决方案。

2022-05-25 上传

2023-03-10 上传

2023-12-08 上传

2023-05-29 上传

2023-03-28 上传

2023-09-10 上传

2023-06-06 上传

2024-01-08 上传

2023-06-09 上传

syp_net

- 粉丝: 158

- 资源: 1187

最新资源

- 前端面试必问:真实项目经验大揭秘

- 永磁同步电机二阶自抗扰神经网络控制技术与实践

- 基于HAL库的LoRa通讯与SHT30温湿度测量项目

- avaWeb-mast推荐系统开发实战指南

- 慧鱼SolidWorks零件模型库:设计与创新的强大工具

- MATLAB实现稀疏傅里叶变换(SFFT)代码及测试

- ChatGPT联网模式亮相,体验智能压缩技术.zip

- 掌握进程保护的HOOK API技术

- 基于.Net的日用品网站开发:设计、实现与分析

- MyBatis-Spring 1.3.2版本下载指南

- 开源全能媒体播放器:小戴媒体播放器2 5.1-3

- 华为eNSP参考文档:DHCP与VRP操作指南

- SpringMyBatis实现疫苗接种预约系统

- VHDL实现倒车雷达系统源码免费提供

- 掌握软件测评师考试要点:历年真题解析

- 轻松下载微信视频号内容的新工具介绍