优化Kafka Producer:增强消息发送可靠性与故障转移策略

需积分: 20 186 浏览量

更新于2024-09-09

收藏 316KB PDF 举报

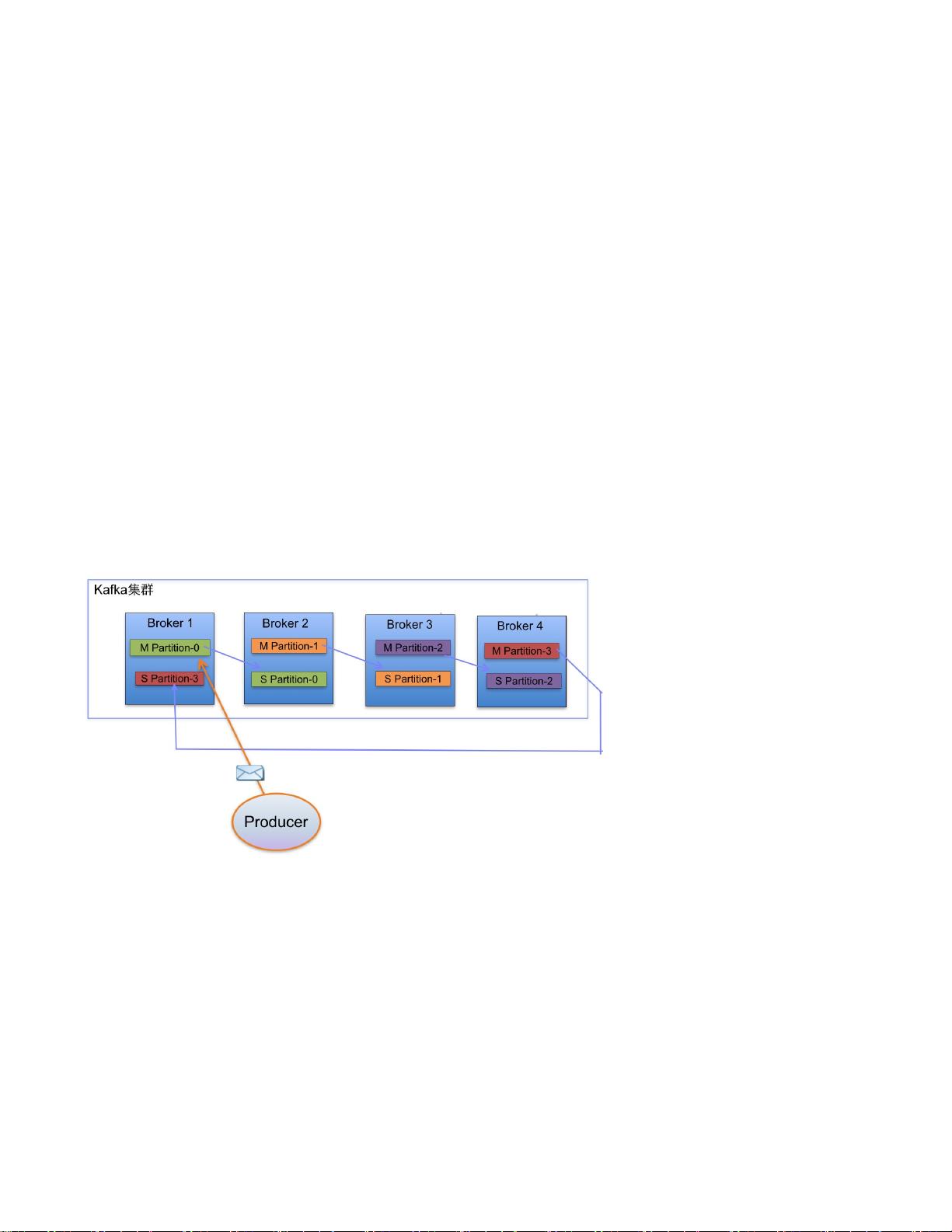

本文主要探讨了Kafka Producer机制优化中的一个重要问题,即如何提高发送消息的可靠性。Kafka是一个分布式流处理平台,其核心组件包括Broker(消息存储和转发的节点)和Topic(消息的分类)。每个Topic被划分为多个Partition,以便实现数据并行处理和高可用性。

在Kafka的默认行为中,当Producer试图将消息发送到特定的Partition时,如果该Partition的所有副本节点都出现故障,Producer会尝试重试发送,最多可达3次(默认设置),每次重试间隔100毫秒。然而,如果超过这个次数仍然失败,Producer会抛出异常,这可能导致用户代码的中断,从而影响消息的发送流程,甚至可能造成消息丢失。

为了解决这个问题,作者提出了一种优化策略,即引入“消息发送失效转移”功能。这个功能允许用户在Producer配置中开启一个开关,当目标Partition的所有副本节点都不可用时,消息不会阻塞在异常上,而是会被转发到其他可用的Partition。这种方式可以确保消息至少能被送到某个节点,即使原目标Partition发生故障。

在实现这个优化时,主要涉及到两个方面的代码修改:

1. 在`ProducerConfig.scala`类中,增加一个名为`sendSwitchBrokerEnabled`的配置项,允许用户设置此功能是否启用,初始值设为`false`。

```scala

val sendSwitchBrokerEnabled = props.getBoolean("send.switch.broker.enable", false)

```

2. 在`DefaultEventHandler.scala`类中,增加一个用于检查`sendSwitchBrokerEnabled`状态的方法,并在必要的地方进行判断:

```scala

private def isSendSwitchBrokerEnabled: Boolean = sendSwitchBrokerEnabled

// 在事件处理逻辑中使用isSendSwitchBrokerEnabled进行决策

```

同时,还可能需要在`DefaultEventHandler`类中添加新的方法,用于根据`topic`, `key`, 和可用的`PartitionAnd`列表来决定消息应被转发到哪个新的Partition。

通过这种方式,用户可以根据业务需求灵活控制消息发送的策略,确保在Kafka Producer遇到故障时,仍能尽可能地保证消息的可靠传输,避免了因为节点故障导致的消息丢失。这种优化对于生产环境中的高可用性和容错性非常重要,尤其是在大数据处理和实时流应用中。

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-05-06 上传

2021-06-20 上传

2021-06-01 上传

2021-02-12 上传

2021-06-09 上传

幽灵之使

- 粉丝: 1657

- 资源: 34

最新资源

- 基于Python和Opencv的车牌识别系统实现

- 我的代码小部件库:统计、MySQL操作与树结构功能

- React初学者入门指南:快速构建并部署你的第一个应用

- Oddish:夜潜CSGO皮肤,智能爬虫技术解析

- 利用REST HaProxy实现haproxy.cfg配置的HTTP接口化

- LeetCode用例构造实践:CMake和GoogleTest的应用

- 快速搭建vulhub靶场:简化docker-compose与vulhub-master下载

- 天秤座术语表:glossariolibras项目安装与使用指南

- 从Vercel到Firebase的全栈Amazon克隆项目指南

- ANU PK大楼Studio 1的3D声效和Ambisonic技术体验

- C#实现的鼠标事件功能演示

- 掌握DP-10:LeetCode超级掉蛋与爆破气球

- C与SDL开发的游戏如何编译至WebAssembly平台

- CastorDOC开源应用程序:文档管理功能与Alfresco集成

- LeetCode用例构造与计算机科学基础:数据结构与设计模式

- 通过travis-nightly-builder实现自动化API与Rake任务构建