Google核心技术与Hadoop入门解析

需积分: 3 21 浏览量

更新于2024-07-23

收藏 5.51MB PPTX 举报

"Hadoop入门及核心组件介绍"

Hadoop是一个开源框架,主要用于处理和存储大量数据,由Apache软件基金会开发并维护。它以其高容错性和可扩展性著称,尤其适合处理分布式环境中的大数据集。Hadoop的核心由两个主要组件构成:HDFS(Hadoop Distributed File System)和MapReduce。

HDFS是Hadoop的基础,是一个分布式文件系统,灵感来源于Google的GFS(Google FileSystem)。HDFS的设计目标是处理PB级别的数据,并且能在廉价硬件上运行。在HDFS中,数据被分割成块(默认64MB),并分布在多台机器上,每块都有多个副本以提供容错能力。这种设计使得即使部分节点故障,系统仍能正常运行。HDFS的架构包括一个NameNode(Master节点)和多个DataNodes(Chunk节点)。NameNode负责管理文件系统的元数据,而DataNodes则存储实际的数据块。NameNode通过心跳机制与DataNodes保持通信,确保数据的同步和一致性。

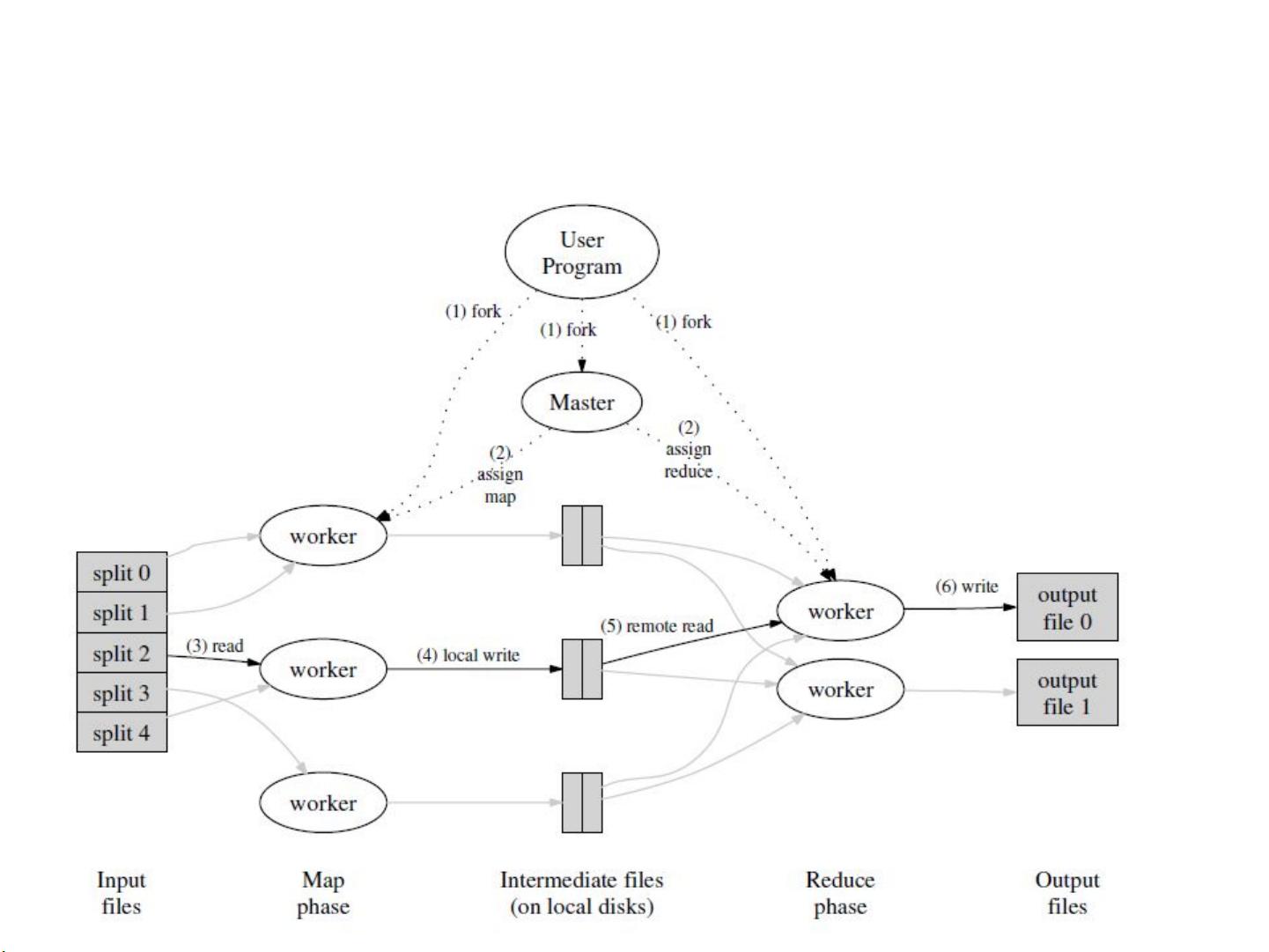

MapReduce是Hadoop用于处理和生成大数据集的编程模型。它受到了Google的MapReduce算法的启发,主要用于执行并行计算任务。Map阶段将输入数据分解成键值对,然后应用用户定义的函数进行处理;Reduce阶段则对Map阶段产生的中间结果进行聚合,最终生成输出。这种模型使得数据处理可以在多台机器上分布式进行,极大地提升了处理速度。

除了Hadoop的核心组件,还有一些其他重要项目和公司与其相关。例如,Cloudera是一家提供Hadoop相关解决方案和服务的公司,它们提供的CDH(Cloudera Distribution Including Apache Hadoop)是一个流行的Hadoop发行版,包含了Hadoop和其他相关工具,如HBase、Spark等,便于企业部署和管理大数据平台。

在使用Hadoop时,需要了解如何配置集群、管理数据流、编写MapReduce程序以及优化性能。此外,学习相关参考资料,如官方文档、社区论坛和专业书籍,可以帮助深入理解Hadoop的工作原理和最佳实践。

Hadoop是一个强大的大数据处理工具,其核心的HDFS和MapReduce组件为处理大规模数据提供了可靠和高效的解决方案。通过学习和掌握Hadoop,开发者和数据分析师可以有效地管理和分析海量数据,从而驱动业务洞察和决策。

2020-08-29 上传

2018-12-14 上传

2022-09-20 上传

2021-10-02 上传

2023-06-03 上传

2022-09-24 上传

2022-09-20 上传

2022-09-23 上传

2022-09-24 上传

匠心零度

- 粉丝: 9503

- 资源: 302

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手