PyTorch入门:理解核心数据结构Tensor

需积分: 5 43 浏览量

更新于2024-06-22

1

收藏 2.08MB PDF 举报

"PyTorch 基础:Tensor(张量)-谢TS的博客.pdf"

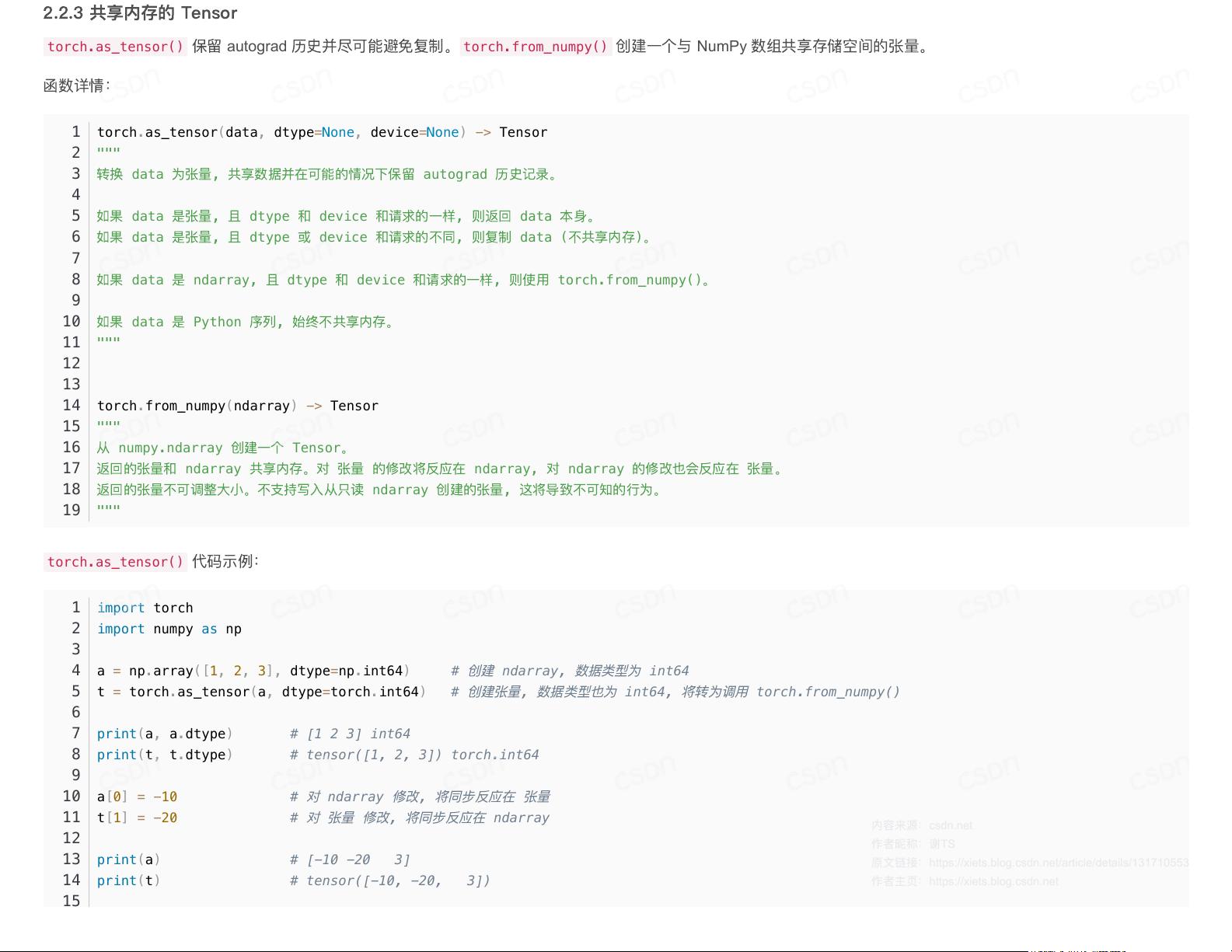

PyTorch 是一个由 Facebook 研发并维护的开源深度学习框架,它广泛应用于构建神经网络模型,同时也支持在 CPU 和 GPU 上进行高效计算。PyTorch 的核心数据结构是 `torch.Tensor`,它是一种用于存储单一数据类型的多维数组,类似于科学计算库 NumPy 中的 `numpy.ndarray`。由于两者接口和运算方法高度相似,使得从 NumPy 迁移到 PyTorch 变得十分平滑。

张量(Tensor)在 PyTorch 中扮演着至关重要的角色,它不仅用于数据存储,还是执行各种计算的基础单元。张量可以被看作是任意维度的数组,从零维的标量(scalar,即单个数值)到一维的向量(vector),再到二维的矩阵(matrix),以及更高维度的数组。这些在数学中都属于张量的范畴,因此张量可以覆盖非常广泛的数学对象。

PyTorch 中的张量操作丰富多样,包括但不限于创建、初始化、切片、索引、形状变换、加减乘除、求导等。这些操作使得张量可以方便地进行数值计算,尤其在构建深度学习模型时,张量是构建神经网络层和定义前向传播过程的关键。

例如,你可以通过以下方式创建一个简单的张量:

```python

import torch

# 创建一个2x3的二维张量,全为0

tensor = torch.zeros(2, 3)

# 创建一个随机初始化的3x3的二维张量

random_tensor = torch.rand(3, 3)

# 对两个张量进行加法运算

result = tensor + random_tensor

```

PyTorch 的动态计算图机制是其相对于其他深度学习框架(如 TensorFlow)的一大特色。张量的运算会在计算图中形成一个有向无环图(DAG),这允许在运行时构建和修改模型,提供了更大的灵活性。例如,如果在训练过程中需要改变网络结构,PyTorch 可以轻松应对。

对于张量的自动求梯度功能,PyTorch 提供了 `.requires_grad_()` 方法来标记需要计算梯度的张量,然后通过 `.backward()` 来计算梯度。这在反向传播和优化过程中极其有用:

```python

# 创建一个需要求梯度的张量

x = torch.ones(2, 2, requires_grad=True)

y = x + 2

z = y * y * 3

out = z.mean()

# 计算梯度

out.backward()

# 查看 x 的梯度

print(x.grad)

```

PyTorch 的张量操作还支持在 GPU 上执行,以利用其并行计算能力加速计算,这对于处理大规模数据或复杂模型至关重要。只需简单地将张量移动到 GPU 设备上即可:

```python

# 如果有可用的 GPU,则将张量转移到 GPU

if torch.cuda.is_available():

x = x.cuda()

y = y.cuda()

# ... 其他操作

```

此外,PyTorch 提供了丰富的预训练模型,如 torchvision 库中的卷积神经网络模型,可以直接用于图像分类、物体检测等任务。在训练过程中,张量也用于存储损失函数值和网络权重,从而进行模型的训练和调整。

总而言之,理解并熟练掌握 `torch.Tensor` 是使用 PyTorch 进行深度学习开发的基础,它为构建和优化神经网络提供了强大的工具集。通过深入学习张量的性质、操作和计算图机制,开发者能够有效地利用 PyTorch 构建复杂的深度学习模型,进行高效的数据处理和训练。

417 浏览量

427 浏览量

点击了解资源详情

2023-12-20 上传

2024-02-05 上传

132 浏览量

2023-12-22 上传

点击了解资源详情

谢TS

- 粉丝: 2w+

- 资源: 23

最新资源

- PMSM控制和建模(FOC、SVPWM、THIPWM等)_磁场定向控制、空间矢量调制、弱磁、速度/转矩控制、电厂模型、自动校准和

- serverless-angular-user-data:ღˇ◡ˇ(ᵕ꒶̮ᵕෆ联手Anuglar,Netlify和Hasura以获得一些用户数据乐趣ღˇෆ

- 红色动态微立体创业融资计划书PPT模板

- qMedia:一个ComputerCraft程序,可用于在终端上创建动画(如Powerpoint)

- DS3232RTC:用于Maxim Integrated DS3232和DS3231实时时钟的Arduino库

- 工兵

- C-24-Box-Model

- recaptcha:[已取消] Laravel 5的reCAPTCHA验证器

- 链接5G频段wifi 显示saved,然后重复点击3次链接wifi,显示链接失败,ylog和空口抓包 抓包 8581new

- angularTools:尝试通过学习角度来做点事情

- 点击图片展开或者收起代码

- Ajax-Rails-4-AJAX-modal-form-render-JS-response-as-table-row.zip

- 简约农村三层别墅建筑设计.rar

- 魔术8球

- 蓝灰色创意公司简介PPT模板

- ESPHelper:一个使ESP8266上使用WiFi和MQTT变得容易的库