PyTorch深度学习:梯度下降算法详解

需积分: 0 6 浏览量

更新于2024-06-15

收藏 1.38MB PDF 举报

本文将深入探讨PyTorch中的深度学习梯度下降算法,这对于理解和实践PyTorch深度学习至关重要。内容涵盖了Tensor对象的基本操作,包括索引和切片,以及Reduction操作,同时强调了自动微分Autograd的重要作用。

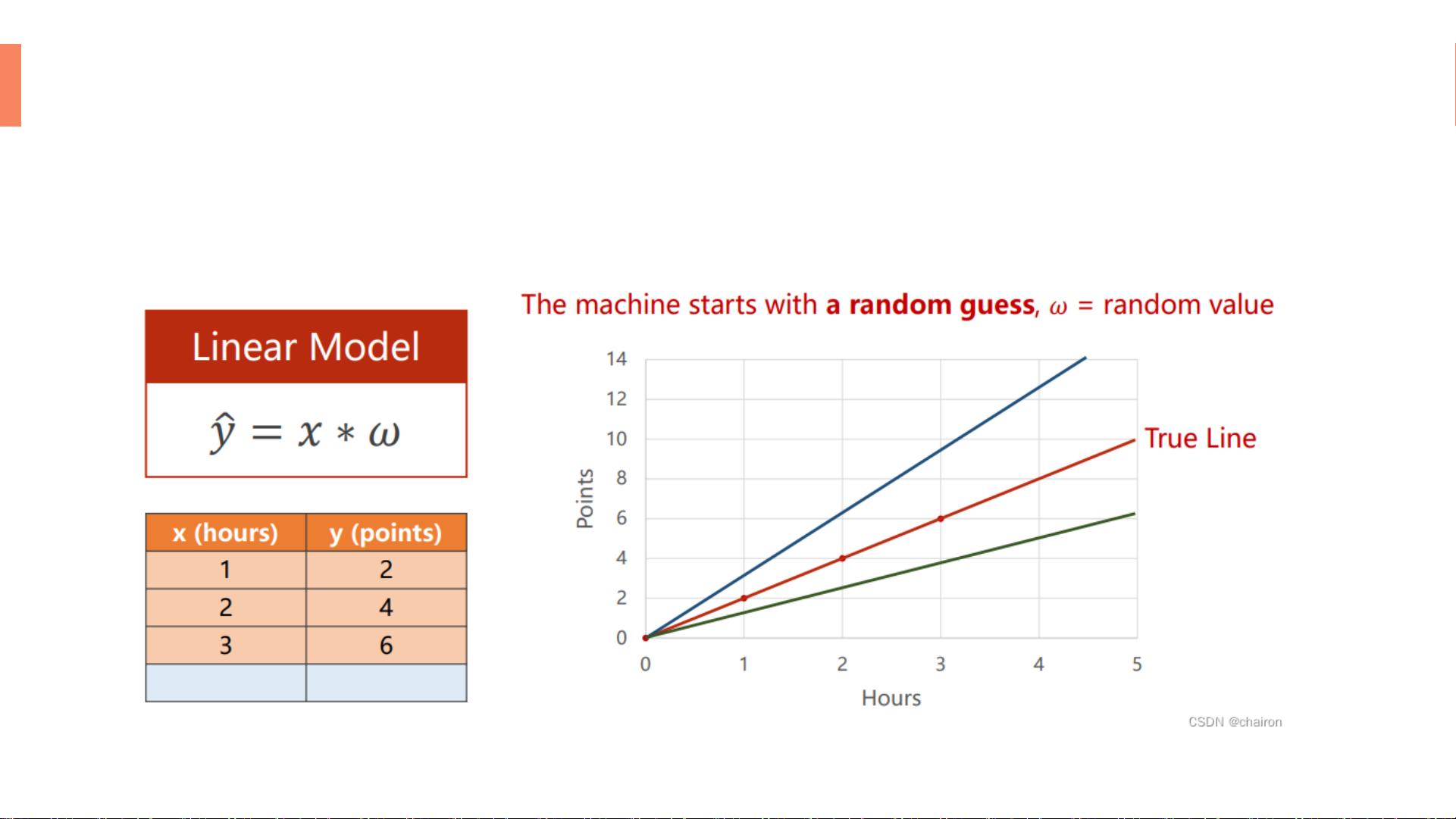

在深度学习中,梯度下降算法是一个核心概念,用于寻找模型参数的最佳值,从而最小化损失函数。当我们有多个变量,如在多维线性模型y = w1*x1 + w2*x2中,穷举所有可能的参数组合以找到最优解变得非常计算密集。因此,我们采用梯度下降算法,它通过迭代更新参数来逼近全局最小值。

梯度下降的初始步骤是选择一个参数w的起始值。随后,算法会根据损失函数的梯度方向更新参数。梯度表示函数变化的速率,正梯度表示损失增加的方向,负梯度则指示损失减少的方向。因此,我们沿着梯度的负方向移动w,以期望逐渐减小损失。学习率(α)决定了每次迭代时w更新的幅度,通常设置为一个小数值,如0.1或0.01。

然而,梯度下降可能会陷入局部最小值,而不是全局最小值,特别是在存在多个局部极小值的复杂函数中。为解决这个问题,可以使用随机梯度下降(SGD),通过多次运行并随机初始化起点来提高找到全局最优解的概率。初始点的选择也被视为超参数,对模型性能有影响。

在实践中,我们需要计算梯度来执行更新。例如,在一个简单的线性模型中,梯度是模型预测值(ŷ)与实际值(y)之差的平均平方误差(MSE)。PyTorch提供了自动微分机制Autograd,能够自动计算梯度,极大地简化了这一过程。

通过PyTorch的Tensor对象,我们可以方便地进行张量运算,包括索引、切片和Reduction操作,如求和、平均等。这些基本操作是构建和优化深度学习模型的基础。在PyTorch中,利用Tensor和Autograd,我们可以轻松实现梯度下降算法,实现模型的训练。

理解PyTorch中的梯度下降算法对于掌握深度学习至关重要,而Tensor的使用和自动微分功能则进一步增强了其在实际应用中的效率和便利性。通过学习和实践这些概念,开发者将更好地驾驭PyTorch进行深度学习模型的构建和优化。

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-05-27 上传

2024-05-27 上传

2024-05-09 上传

2024-02-19 上传

2019-08-11 上传

木小梦(๑•.•๑)

- 粉丝: 142

- 资源: 3

最新资源

- Chrome ESLint扩展:实时运行ESLint于网页脚本

- 基于 Webhook 的 redux 预处理器实现教程

- 探索国际CMS内容管理系统v1.1的新功能与应用

- 在Heroku上快速部署Directus平台的指南

- Folks Who Code官网:打造安全友好的开源环境

- React测试专用:上下文提供者组件实现指南

- RabbitMQ利用eLevelDB后端实现高效消息索引

- JavaScript双向对象引用的极简实现教程

- Bazel 0.18.1版本发布,Windows平台构建工具优化

- electron-notification-desktop:电子应用桌面通知解决方案

- 天津理工操作系统实验报告:进程与存储器管理

- 掌握webpack动态热模块替换的实现技巧

- 恶意软件ep_kaput: Etherpad插件系统破坏者

- Java实现Opus音频解码器jopus库的应用与介绍

- QString库:C语言中的高效动态字符串处理

- 微信小程序图像识别与AI功能实现源码