Linux环境下Hadoop集群中HBase的安装与配置指南

需积分: 49 175 浏览量

更新于2024-09-09

收藏 3.91MB DOCX 举报

"Hbase安装与配置的详细步骤以及Hadoop生态系统的相互作用"

在Hadoop生态系统中,HBase是一个重要的组件,它作为一个分布式数据库运行在Hadoop集群的HDFS之上。HDFS为HBase提供了高可用的底层存储,确保数据的持久化,而Hadoop的MapReduce则赋予HBase强大的计算能力。HBase自身则为整个集群提供了高效的数据存储和处理解决方案。

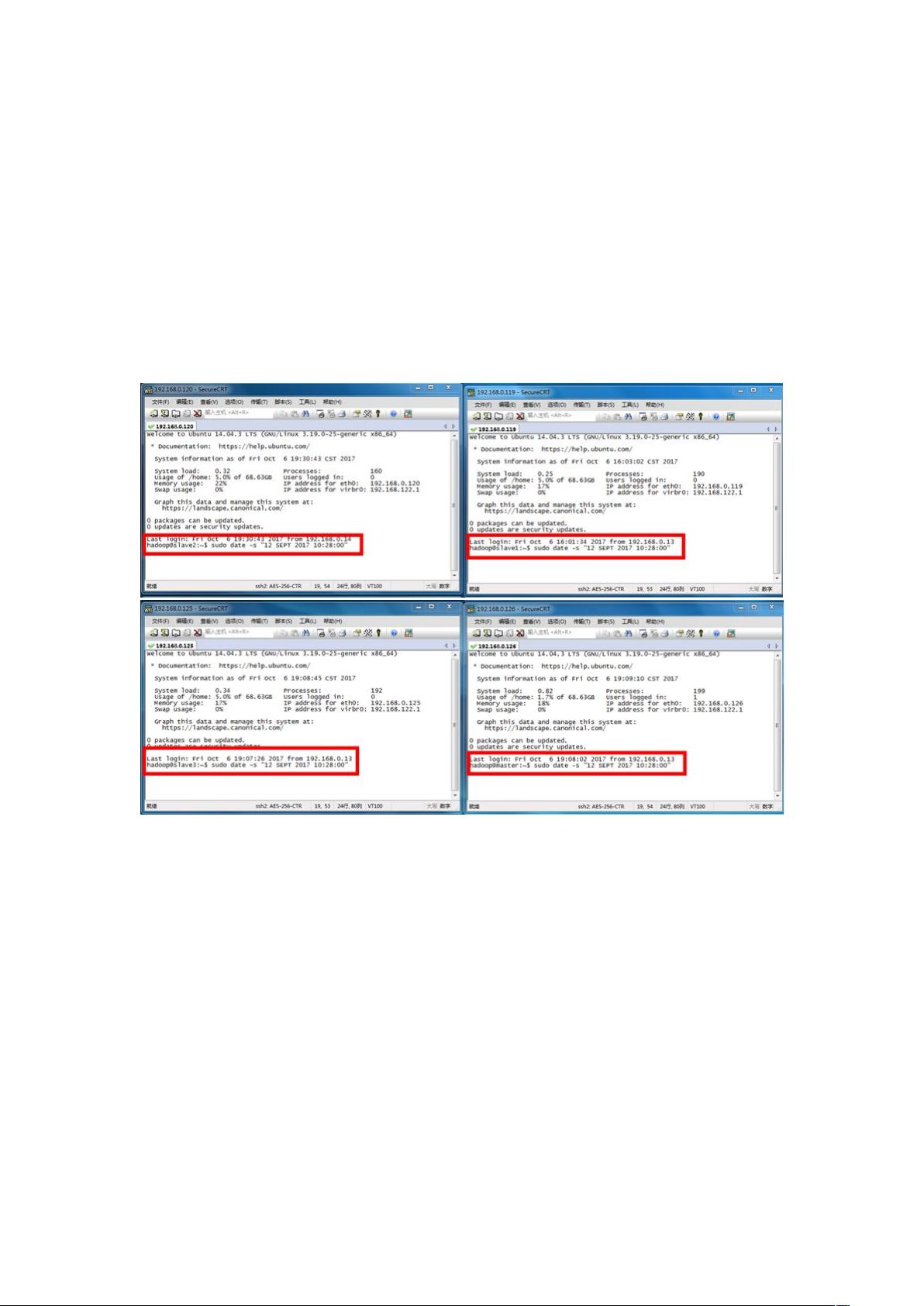

在开始HBase的安装和配置前,确保集群环境已经准备就绪,特别是系统时间同步。所有节点的时间必须保持一致,因为HBase依赖系统时间来生成时间戳,这是数据单元的重要属性。如果时间不一致,可能导致HBase无法正常启动。可以通过`sudo date –s "12SEPT201710:28:00"`这样的命令来同步系统时间。

接下来,我们关注Zookeeper的安装和配置。Zookeeper是HBase运行不可或缺的部分,它作为分布式协调服务,负责集群的同步和协调。首先,解压缩Zookeeper的安装包,通常放在集群Master节点的用户主目录下。然后,通过`tar –xzf zookeeper-3.4.5.tar.gz`命令解压,并用`mv`命令重命名目录。接着,进入`conf`目录,编辑`zoo_sample.cfg`文件,调整配置参数,如`tickTime`和`initLimit`,这些参数影响着Zookeeper的心跳机制和集群间的通信效率。

`tickTime`是Zookeeper的基本时间单位,所有其他时间设置都是它的倍数。它应该适中,过大可能导致超时时间增加,过小则可能使session过早超时并增加网络负载。`initLimit`则是Follower服务器与Leader建立连接时允许的最大心跳间隔数,超过这个限制,Zookeeper会认为连接失败。

HBase的安装通常包括下载HBase的二进制包,解压,配置环境变量,修改`hbase-site.xml`以定义HBase集群的相关属性,如Zookeeper的地址等。此外,还需要配置`hbase-env.sh`以设置JVM参数,例如堆大小和GC策略。

在所有节点上完成这些步骤后,启动Zookeeper,然后启动HBase。监控日志以确保所有服务都正常运行。一旦HBase集群启动成功,就可以开始测试和使用HBase的功能,如创建表,插入数据,进行查询等。

HBase的安装和配置涉及到多个层面,包括Hadoop集群的环境准备,Zookeeper的部署和配置,以及HBase自身的设置。理解这些步骤和背后的原理对于管理和优化HBase集群至关重要。在实际操作中,还需要注意网络、硬件资源和安全性的考虑,以确保HBase能够稳定、高效地服务于大数据处理需求。

2015-11-24 上传

2021-11-27 上传

2021-08-21 上传

2021-07-03 上传

2021-12-29 上传

2022-09-14 上传

Senful_Young

- 粉丝: 7

- 资源: 5

最新资源

- C语言运行环境,适合C语言初学者阅读。

- WinXp系统蓝屏解决方案

- 县级电网调度自动化系统的运用及深思

- EJB3中文教程,很有用的!

- jdbc数据库连接写法

- Oracle常用命令

- 例解C程序的内存分布

- linux sed命令讲解

- Error in initialization of native part of the Colorer library. This can be caused by absent net_sf_colorer.dll 报错

- BA5104红外遥控编码发射器

- LASER SCRIBING OF p-i-np-i-n “MICROMORPH” (a-SiHμc-SiH) TANDEM CELLS 非晶硅/微晶硅太阳能电池的激光切割

- sql server 2000软件全程视图使用教程

- jqgriddocs3.4

- Compressive Sensing

- 高速PCB设计指南之一

- Flex3 in Action(Feb 2009).pdf