GPU与CPU差异:工作原理对比及TensorFlow GPU安装详解

74 浏览量

更新于2024-08-28

收藏 251KB PDF 举报

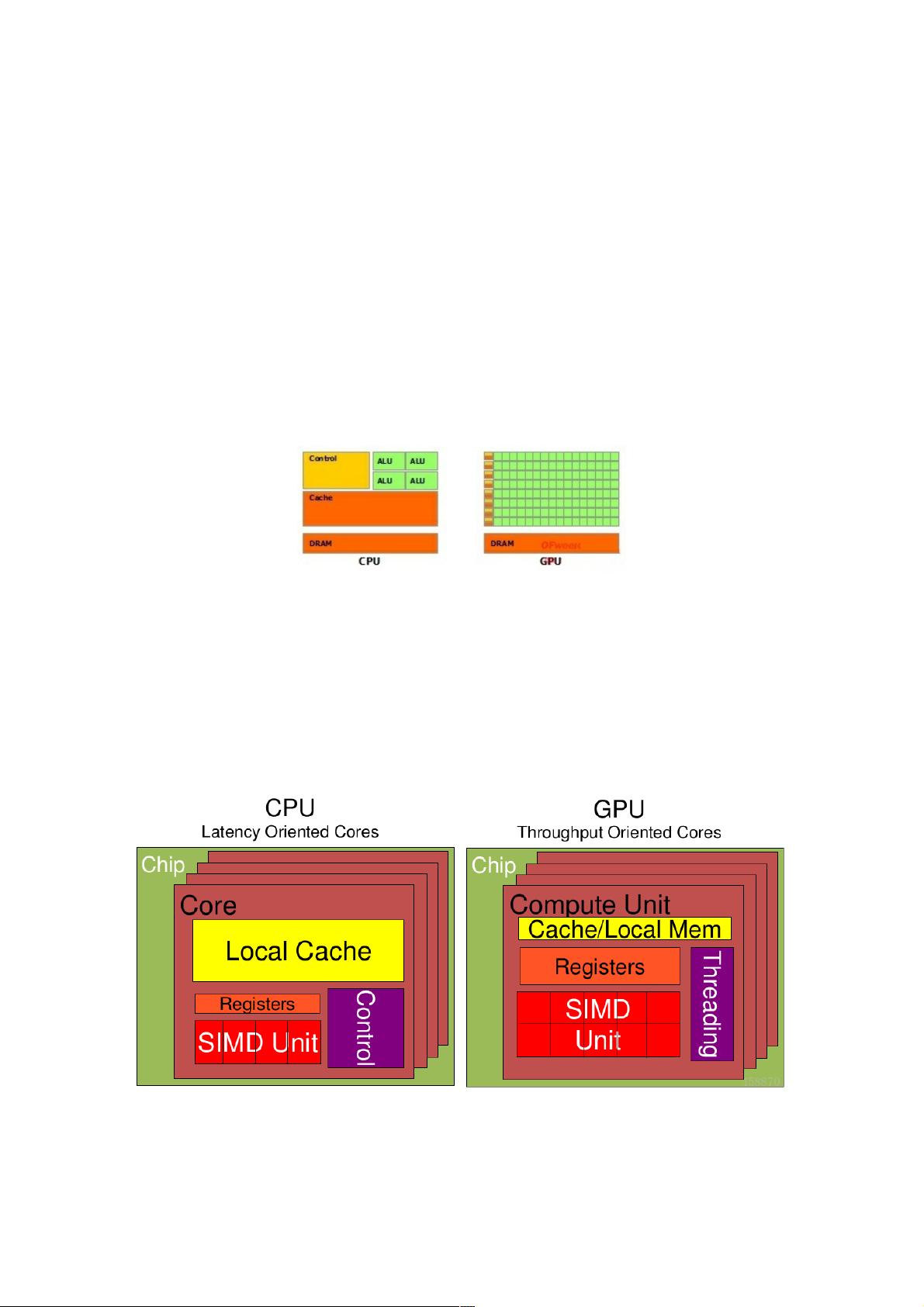

本文将深入探讨CPU和GPU之间的区别、工作原理以及如何在TensorFlow中利用GPU进行安装。首先,我们从两者的应用场景出发,了解它们设计目标的差异。CPU作为通用处理器,需要处理各种数据类型,执行逻辑判断,这导致其内部结构复杂,包含大量的分支跳转和中断处理机制,如计算单元ALU、存储单元(如Cache)和控制单元。相比之下,GPU的设计重点在于并行计算,针对类型高度统一且无依赖的大规模数据,追求高效的连续计算。

1. **性能对比:**

- Cache与本地内存:CPU通常具有较大的Cache,但GPU的Cache较小,目的是为了高效地服务众多并行运行的线程。

- 线程数量:GPU的优势在于能支持更多的线程,从而实现更高的并发处理能力。

- 寄存器:GPU拥有更多寄存器,以适应大量线程的并发需求。

- SIMD 单元:GPU的SIMD(单指令多数据)功能比CPU强大,可以在同一时间处理多个数据。

2. **CPU与GPU特性:**

- CPU强调单线程性能,拥有强大的ALU,能在短时间内完成高精度计算,时钟频率可达GHz级别。

- GPU注重并行计算,通过大量ALU和较少的Cache来实现高吞吐量,特别适合大规模并行数据处理。

3. **TensorFlow GPU安装指南:**

- 在使用TensorFlow时,为了充分利用GPU,需要确保TensorFlow版本支持GPU,并配置相应的硬件驱动和库,如CUDA和cuDNN。

- 通过设置TensorFlow的配置选项,如`tf.config.experimental.list_physical_devices('GPU')`,检查和管理GPU设备。

CPU和GPU在架构和性能上存在显著差异,适用于不同的场景。理解这些区别有助于在实际项目中根据需求选择合适的硬件资源,特别是对于深度学习和机器学习任务,GPU的加速效果通常更为明显。通过结合视频和实际案例,本文提供了深入浅出的讲解,帮助读者更好地掌握两者的工作原理和使用技巧。

2023-05-12 上传

2023-06-27 上传

2023-06-24 上传

2020-09-16 上传

2022-08-03 上传

2021-03-24 上传

2023-06-27 上传

点击了解资源详情

点击了解资源详情

weixin_38714509

- 粉丝: 3

- 资源: 931