PyCharm连接Databricks详细步骤

136 浏览量

更新于2024-08-31

收藏 612KB PDF 举报

"这篇教程详细介绍了如何在PyCharm中连接Databricks集群的步骤,主要包括检查Java版本、收集Databricks相关信息、安装Anaconda、创建虚拟环境以及配置必要的库。"

在本地开发环境中使用PyCharm连接Databricks集群是一项常见的任务,尤其对于数据科学家和工程师来说,这样的连接能方便地进行代码编写和测试。以下是具体的步骤:

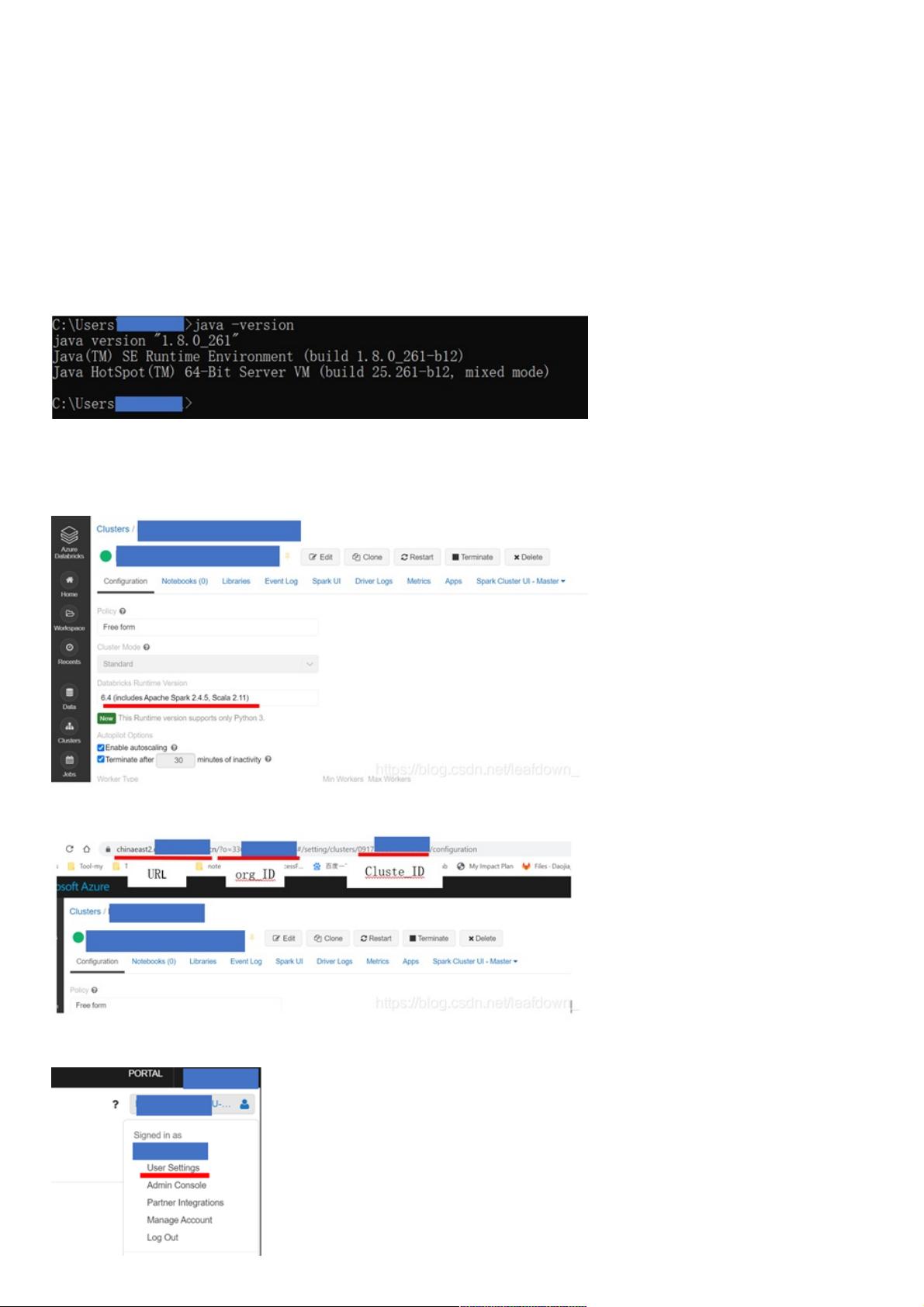

1. 检查Java版本:

首先,你需要确保本地系统上的Java版本是1.8或以上,因为Databricks需要这个版本的Java支持。若非如此,你可以从Oracle官网下载并安装符合要求的Java JDK。

2. 收集Databricks信息:

- 查看Python版本:这可以在Databricks集群的设置中找到,确保与你的本地环境匹配。

- 获取RuntimeVersion:这将决定你的代码运行环境。

- 查看Cluster URL:用于建立连接。

- 生成Token:在Databricks的个人设置中获取,用于身份验证。

3. 安装Anaconda:

如果尚未安装Anaconda,可以按照官方教程或第三方教程进行安装。Anaconda是一个强大的Python环境管理工具,便于创建和管理虚拟环境。

4. 创建虚拟环境:

- 使用Anaconda命令行工具创建一个与Databricks集群Python版本相匹配的虚拟环境,例如,如果集群使用Python 3.7,命令为:`conda create -n dbconnect python=3.7`。

- 激活虚拟环境:`conda activate dbconnect`。

- 卸载pyspark:确保新环境干净,避免因包冲突问题,可执行`pip uninstall pyspark`。

5. 配置和安装库:

- 添加清华镜像源以加快安装速度:`conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/` 和 `conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pks/main/`。

- 在虚拟环境中安装必要的库,包括pyspark和其他依赖,通常还需要安装dbutils,如:`pip install dbutils pyspark`.

6. 在PyCharm中配置Databricks连接:

- 打开PyCharm,进入设置(Preferences),选择项目 Interpreter。

- 添加新的Interpreter,选择Conda环境,并选择你刚才创建的dbconnect环境。

- 配置Interpreter路径,确保指向虚拟环境中的Python解释器。

- 设置远程解释器,输入Databricks集群的URL和Token,以及其他必要信息。

完成以上步骤后,你就可以在PyCharm中编写和运行针对Databricks集群的代码了,享受到本地开发的便利性,同时代码可以直接运行在Databricks集群上,进行大数据处理和分析。

506 浏览量

1444 浏览量

3161 浏览量

297 浏览量

195 浏览量

227 浏览量

143 浏览量

378 浏览量

2024-10-11 上传

weixin_38686542

- 粉丝: 1

- 资源: 938

最新资源

- Lista_de_Exercicios:Lista deExercíciode Algoritmos do Gustavo Guanabara教授

- rust-cas:通过构建与Bazel兼容的内容可寻址商店来测试Rust

- 网络刀客 v3.0

- TW-Shiraz:Shiraz是Tiddlywiki 5的一个小型插件,包含宏,样式表,模板,片段,图像,静态表,动态表,并充当入门工具包

- vc_static_button.rar_RFW_VC static Button_VC++ static Button

- 行业文档-设计装置-一种折叠式太阳能座椅广告棚.zip

- pid控制器代码matlab-Ziegler-Nichols-Tuning-Method:使用Ziegler-Nichols闭环方法针对给定传

- CompletableFuture.zip

- 纯css制作文字随时间变动而变色,文字变色效果,背景透明阴影

- up4

- Curriculum_Vitae:职务経歴书

- 粒子群多目标-程序.rar_UY9_pareto_pareto多目标_多目标 粒子群_自适应粒子群

- 行业文档-设计装置-一种折纸机的机头.zip

- englishTeachers:使用Postgresql的简单应用

- SSM实验室预约管理系统.7z

- ESP8266-01GPIO口模拟I2C LCD1602.rar