Windows环境下Flume-ng搭建与测试:Log4j日志流经Flume至HDFS

需积分: 50 166 浏览量

更新于2024-09-03

1

收藏 296KB DOCX 举报

"Flume-ng是一个用于收集、聚合和移动大量日志数据的工具,它在Windows环境下可以被配置和测试以将日志数据发送到HDFS。此文档详细介绍了如何在Windows上搭建Flume-ng环境,并通过Log4j生成的日志作为数据源,将这些日志数据流式传输到HDFS。"

Flume-ng是Apache Hadoop的一个子项目,它主要用于日志管理和数据收集。在Windows环境中搭建Flume-ng主要包括以下步骤:

1. **下载与安装**:

首先,你需要下载Flume-ng的可执行文件,并将其解压缩到你选择的目录。确保下载的是适合Windows操作系统的版本。

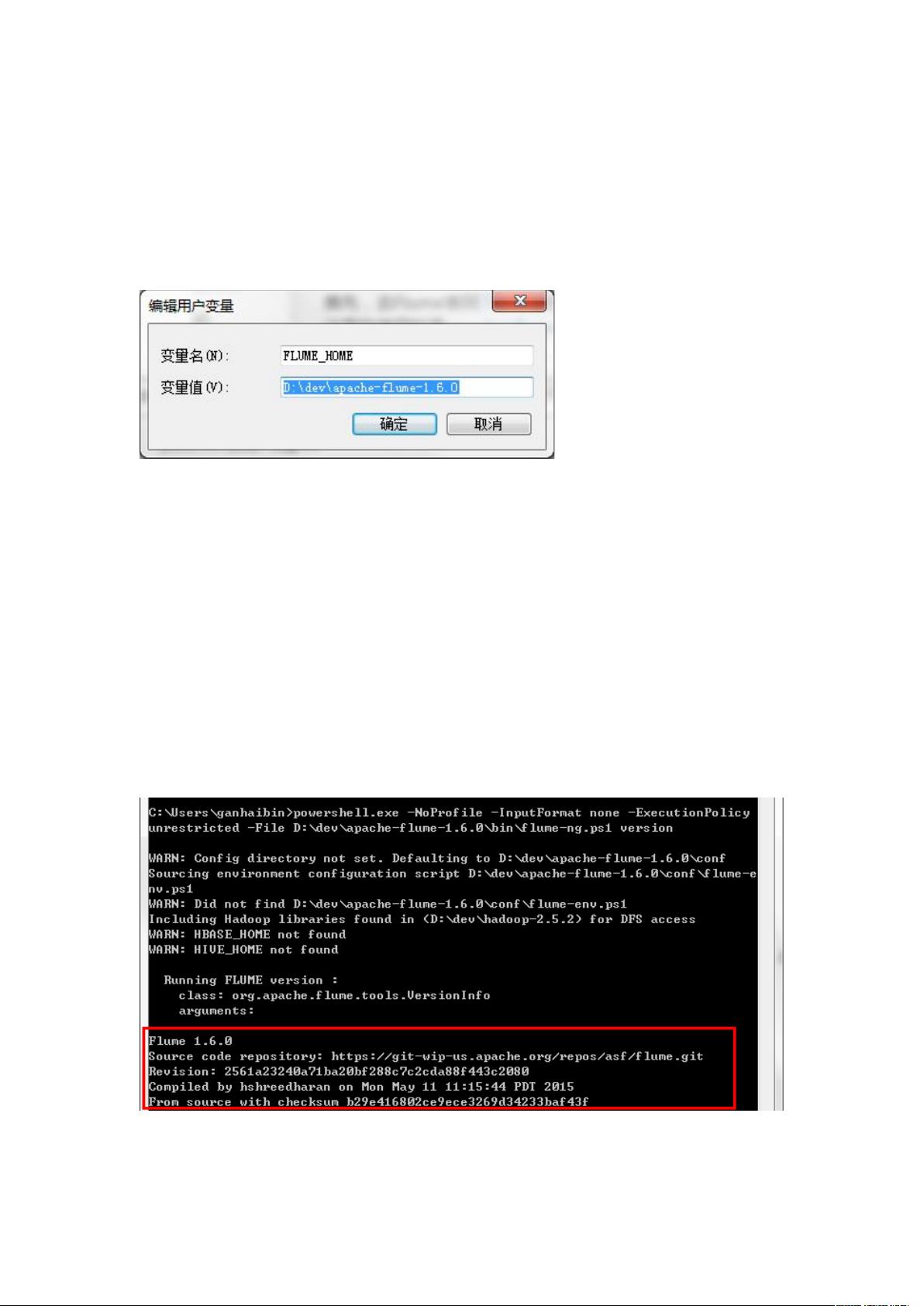

2. **配置环境变量**:

创建新的系统环境变量`FLUME_HOME`,将其值设置为Flume的安装目录。接着编辑`PATH`系统变量,添加`%FLUME_HOME%\conf`和`%FLUME_HOME%\bin`到路径列表中,以便在任何地方都可以运行Flume命令。

3. **配置Flume**:

打开`flume-env.sh`文件(如果不存在,需要从`flume-env.sh.template`复制并重命名为`flume-env.sh`),然后设置`JAVA_HOME`环境变量,指向你的JDK安装路径。

4. **验证安装**:

运行命令`flume-ng version`来检查Flume是否正确安装。如果出现版本信息,说明安装成功。

5. **测试Flume**:

- 创建一个简单的Flume配置文件`example.conf`,在这个例子中,配置了一个名为`a1`的Agent,包含一个Avro数据源`r1`,一个日志记录器Sink`k1`,以及一个内存Channel`c1`。数据源`r1`被配置为监听本地主机的44444端口,等待Avro数据输入;Sink`k1`则将接收到的数据输出到控制台。

- 在Flume的配置目录下,使用命令`flume-ng agent --conf conf --conf-file example.conf --name a1`启动Flume Agent。

- 启动成功后,会看到一个新的命令行窗口。在另一个命令行窗口中,使用telnet命令连接到44444端口,输入一些数据。这些数据将被Flume Agent捕获并由Sink输出到控制台。

6. **整合Log4j**:

要将Log4j日志通过Flume输出到HDFS,你需要在Log4j配置中添加Flume Appender,使得日志直接发送到Flume。这通常涉及到在Log4j的配置文件(如`log4j.properties`或`log4j.xml`)中定义一个自定义Appender,该Appender使用Flume的Avro Sink作为目的地。

7. **配置HDFS**:

在Flume的配置文件中,你需要指定HDFSSink,配置HDFS的URL、文件名以及写入模式。例如,你可以设置`hdfs.path`为HDFS的路径,`hdfs.fileType`为DataStream,`hdfs.writeFormat`为Text。

8. **启动和监控**:

一旦配置完成,你可以启动Flume Agent并将Log4j产生的日志发送到HDFS。同时,可以使用Flume提供的监控工具或Hadoop的Web UI来查看日志数据是否成功写入HDFS。

通过以上步骤,你就能够在Windows环境下成功地建立一个基本的Flume-ng环境,将Log4j日志数据流式传输到HDFS。这为大规模日志管理和分析提供了一个有效的解决方案。在实际应用中,你可能还需要考虑其他因素,比如日志数据的分片策略、故障恢复和性能优化等。

390 浏览量

2863 浏览量

1181 浏览量

2022-11-30 上传

2022-11-30 上传

330 浏览量

297 浏览量

173 浏览量

wanghan1977

- 粉丝: 10

最新资源

- DeepFreeze密码移除工具6.x版本使用教程

- MQ2烟雾传感器无线报警器项目解析

- Android实现消息推送技术:WebSocket的运用解析

- 利用jQuery插件自定义制作酷似Flash的广告横幅通栏

- 自定义滚动时间选择器,轻松转换为Jar包

- Python环境下pyuvs-rt模块的使用与应用

- DLL文件导出函数查看器 - 查看DLL函数名称

- Laravel框架深度解析:开发者的创造力与学习资源

- 实现滚动屏幕背景固定,提升网页高端视觉效果

- 遗传算法解决0-1背包问题

- 必备nagios插件压缩包:实现监控的关键

- Asp.Net2.0 Data Tutorial全集深度解析

- Flutter文本分割插件flutter_break_iterator入门与实践

- GD Spi Flash存储器的详细技术手册

- 深入解析MyBatis PageHelper分页插件的使用与原理

- DELPHI实现斗地主游戏设计及半成品源码分析