Ubuntu下Hadoop单节点部署与原理详解

需积分: 21 38 浏览量

更新于2024-07-20

收藏 2.01MB DOC 举报

本篇指南详细介绍了如何在单节点上部署和配置Hadoop,主要针对的是基于Ubuntu操作系统的环境。Hadoop是一个开源的分布式计算框架,由Apache软件基金会提供,主要用于处理大规模数据集的并行计算,其核心组件包括Hadoop分布式文件系统(HDFS)和MapReduce。

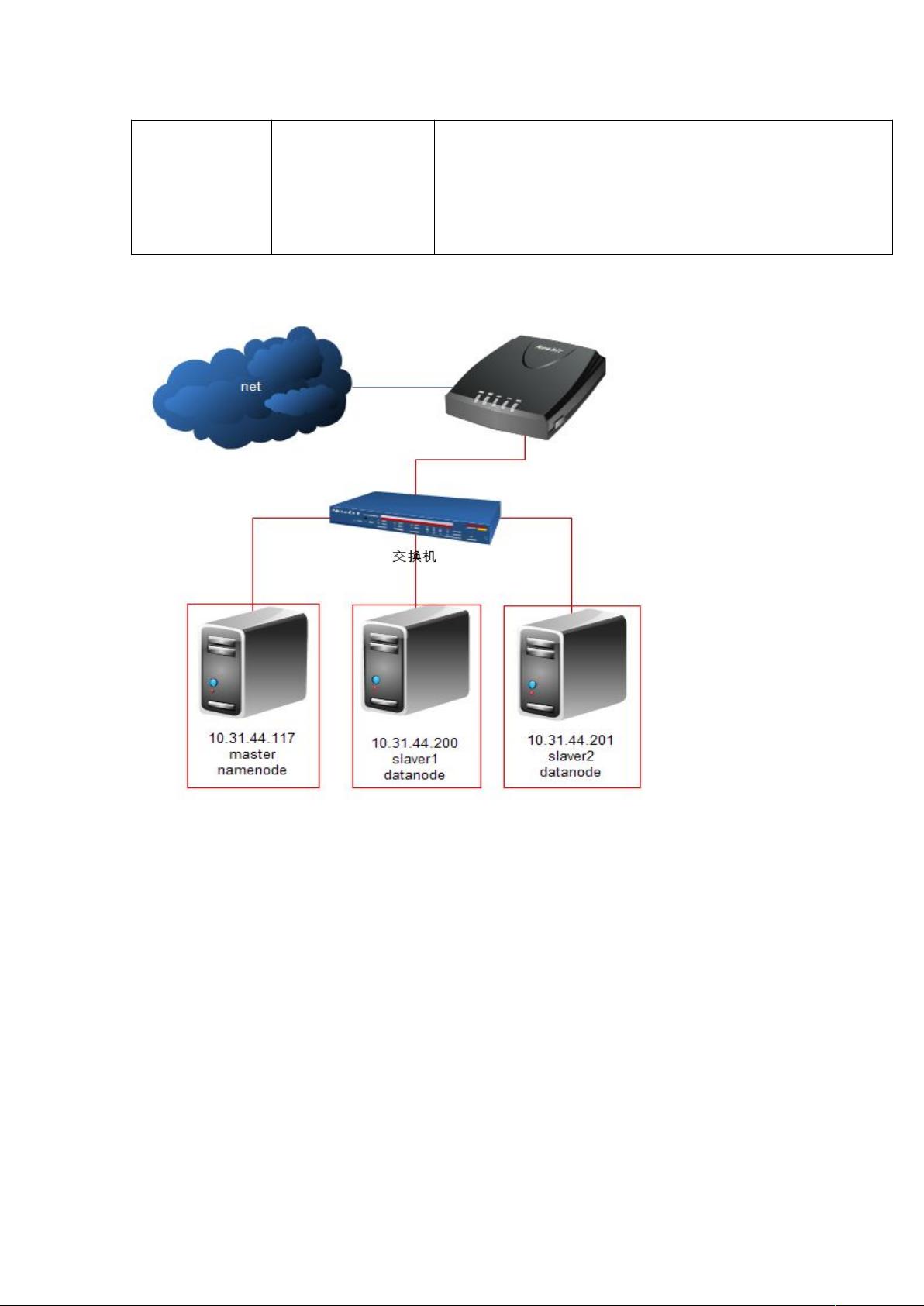

首先,实验目标是让学生掌握Hadoop的基本原理和工作机制,理解Hadoop集群的架构,以及关键技术如HDFS和MapReduce的功能和应用。HDFS是Hadoop的关键部分,它采用主从架构,由NameNode(名称节点)和DataNode(数据节点)组成。NameNode负责管理元数据,如文件块的分布和副本存储,而DataNode则实际存储数据块并提供读写服务。HDFS的设计旨在实现高可用性和容错性,通过将文件划分为多个Block并分布在多个DataNode上,即使部分节点故障,也能确保数据的完整性。

MapReduce是另一个重要组件,它简化了大规模并行计算的任务设计,只需要定义Map和Reduce两个函数即可处理满足特定条件的数据集。MapReduce适用于那些可以拆分成独立处理部分的任务,能够在集群环境下高效执行,同时具备容错处理能力,支持T级别数据的处理。

在单节点部署时,实践者需要按照一定的步骤进行,包括安装Hadoop,配置环境变量,启动守护进程,以及验证HDFS和MapReduce服务是否正常运行。这通常涉及下载Hadoop发行版,设置必要的配置文件,如core-site.xml和hdfs-site.xml,以及mapred-site.xml等,以适应本地硬件和网络环境。

此外,Hadoop集群的组织结构中,服务器角色明确,Namenode作为控制中心,负责全局协调和管理,而DataNode则专注于数据的存储和处理。这种分工协作使得整个集群能高效、稳定地提供服务。

这篇指南为读者提供了一套完整的Hadoop单节点部署和配置流程,不仅涵盖了理论知识,还强调了实际操作中的关键环节,对于初学者和想要深入了解Hadoop的人来说,是一份宝贵的参考资料。

189 浏览量

179 浏览量

2022-11-26 上传

128 浏览量

180 浏览量

195 浏览量