深度学习在数据不足时的解决方案:NanoNets与迁移学习

114 浏览量

更新于2024-08-28

收藏 706KB PDF 举报

"NanoNets:数据不足时如何深度学习"

深度学习是现代人工智能的核心驱动力,它在诸多领域如自然语言处理、图像识别和自动驾驶等取得了显著的成就。然而,深度学习的一大挑战在于需要大量的数据来训练模型,这就像火箭升空需要强大的引擎和充足的燃料一样。Andrew Ng的观点形象地表达了这一概念,深度学习模型是火箭引擎,而大数据则是推动模型学习的关键燃料。

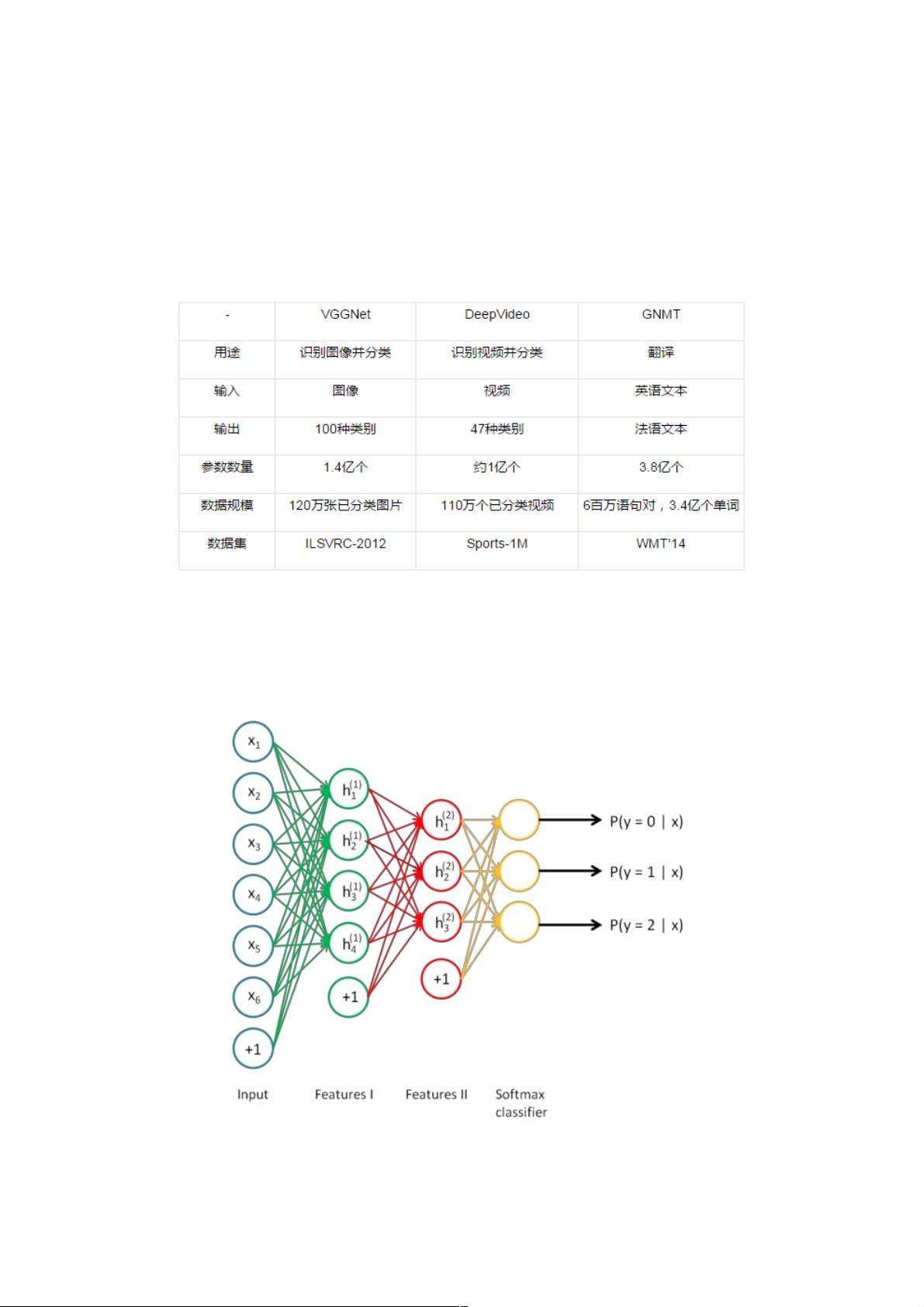

深度学习模型通常由多层神经网络构成,每一层负责学习输入数据的不同特征。这种分层结构使得模型能够逐步解析复杂的信息,从简单的边缘和纹理到复杂的概念。例如,AlexNet这样的经典模型在图像识别中,其早期层会捕获图像的低级特征,如线条和形状,而晚期层则处理更抽象的概念,如物体类别。

当面临数据不足的问题时,模型往往难以准确学习和泛化。这是因为模型的大小(参数数量)与解决复杂问题的能力密切相关,同时也与所需的数据量成正比。如果数据不足,模型可能会过拟合,即过度适应训练数据,导致在未见过的数据上表现不佳。

为了解决数据不足的问题,迁移学习应运而生。迁移学习是一种策略,它利用在大规模数据集上预训练的模型(通常是针对相似任务或通用任务)来初始化新任务的模型。预训练模型已经学习了大量数据中的通用特征,这些特征可以作为新任务的基础,减少对新数据的需求。例如,一个在ImageNet上预训练的模型已经理解了图像的基本特征,可以被用于识别新的图像类别,只需要少量特定类别的数据进行微调即可。

Qiang Yang 和 Sinno Jialin Pan 的《Transfer Learning Survey》进一步探讨了迁移学习的理论和应用,包括从源任务到目标任务的知识转移方法、不同类型的迁移学习,以及如何有效地利用有限的数据来提升模型性能。

NanoNets 可能是指一种专门设计用于处理小数据集的深度学习框架,通过精巧的模型架构和优化技术,尽可能地提高在数据不足情况下的学习效率和准确性。尽管深度学习在大数据背景下展现出强大的能力,但在实际应用中,如何在数据稀缺的情况下仍然保持模型的性能,是研究人员和工程师持续关注和解决的问题。通过迁移学习和类似 NanoNets 的方法,我们可以克服数据不足的障碍,继续推进深度学习在各个领域的应用。

2021-08-18 上传

2021-02-13 上传

点击了解资源详情

2021-05-04 上传

2021-02-05 上传

2021-03-08 上传

2024-10-31 上传

2024-10-31 上传

weixin_38539018

- 粉丝: 6

- 资源: 941

最新资源

- SSM动力电池数据管理系统源码及数据库详解

- R语言桑基图绘制与SCI图输入文件代码分析

- Linux下Sakagari Hurricane翻译工作:cpktools的使用教程

- prettybench: 让 Go 基准测试结果更易读

- Python官方文档查询库,提升开发效率与时间节约

- 基于Django的Python就业系统毕设源码

- 高并发下的SpringBoot与Nginx+Redis会话共享解决方案

- 构建问答游戏:Node.js与Express.js实战教程

- MATLAB在旅行商问题中的应用与优化方法研究

- OMAPL138 DSP平台UPP接口编程实践

- 杰克逊维尔非营利地基工程的VMS项目介绍

- 宠物猫企业网站模板PHP源码下载

- 52简易计算器源码解析与下载指南

- 探索Node.js v6.2.1 - 事件驱动的高性能Web服务器环境

- 找回WinSCP密码的神器:winscppasswd工具介绍

- xctools:解析Xcode命令行工具输出的Ruby库