非并行TSVR方法与SMO求解器:结构风险最小化与稀疏性探讨

128 浏览量

更新于2024-07-14

收藏 1.05MB PDF 举报

非并行支持向量回归模型及其SMO型求解器是一篇发表于2018年《神经网络》(Neural Networks)期刊的研究论文,由Long Tang、Yingjie Tian和Chunyan Yang等人共同完成。该研究主要关注在机器学习领域中的一种高级预测技术——支持向量回归(Support Vector Regression, SVR),特别是针对非并行版本的模型优化。

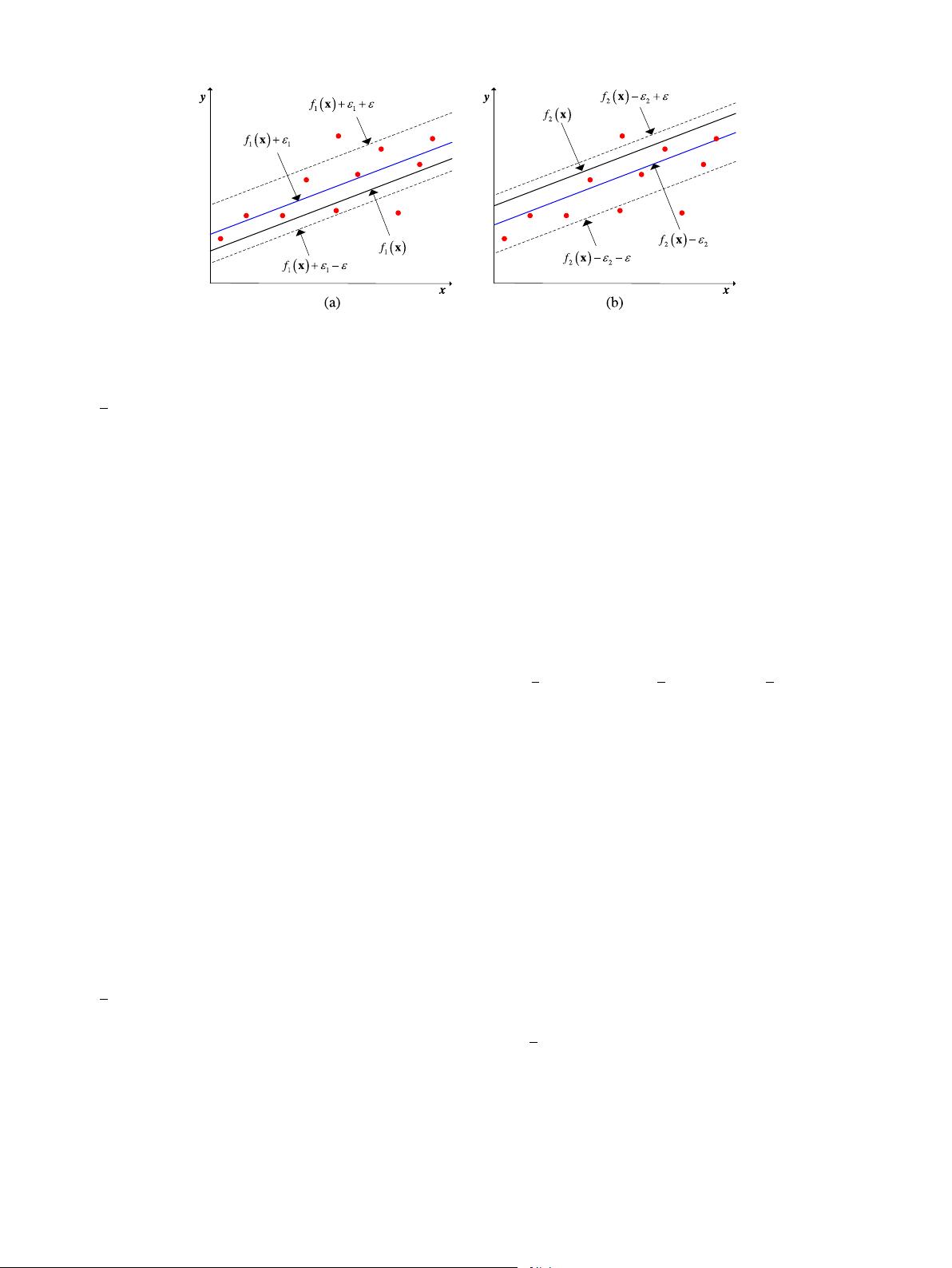

在传统的支持向量机(SVM)中,尤其是支持向量回归模型中,关键目标是找到一个超平面,它能够最大化数据的间隔,同时最小化模型的预测误差。然而,随着数据集规模的增长,传统的并行方法可能无法有效处理大规模训练,因此研究者提出了一种非并行的解决方案,这在实际应用中具有重要的意义,尤其是在大数据背景下。

论文的核心内容探讨了非并行支持向量回归模型如何通过结构风险最小化原则(Structural Risk Minimization, SRM)进行优化。SRM是一种统计学习理论中的方法,它旨在平衡模型的复杂度和泛化能力,避免过拟合。在非并行模型中,作者可能采用了一种称为序列最小优化(Sequential Minimal Optimization, SMO)的算法来简化求解过程。SMO是一种著名的二次规划求解策略,它通过分割样本对进行局部优化,显著降低了计算复杂性,使得非并行模型在解决大规模问题时依然保持高效。

另一个关键点是模型的稀疏性。论文可能讨论了如何通过非并行算法实现和支持向量回归的稀疏性,这有助于减少模型的复杂性和内存需求,从而提高模型的解释性和执行效率。稀疏支持向量机通常会寻找只依赖少数输入特征的决策边界,这对于特征选择和理解模型行为至关重要。

此外,论文还可能包含了实验部分,展示了非并行支持向量回归模型及其SMO求解器在实际数据集上的性能比较,以及与传统并行方法的对比分析。这些实验结果可以揭示非并行方法在不同场景下的优势,如处理大规模数据、训练时间缩短和模型稳定性提升等方面。

这篇研究论文深入探讨了非并行支持向量回归模型在理论和实践层面的优化策略,以及其在实际机器学习任务中的应用潜力,对于那些关注大数据处理和模型效率提升的科研人员和工程师具有很高的参考价值。

点击了解资源详情

2011-06-30 上传

2019-04-09 上传

192 浏览量

2015-07-20 上传

2011-04-01 上传

weixin_38718690

- 粉丝: 6

- 资源: 944

最新资源

- BottleJS快速入门:演示JavaScript依赖注入优势

- vConsole插件使用教程:输出与复制日志文件

- Node.js v12.7.0版本发布 - 适合高性能Web服务器与网络应用

- Android中实现图片的双指和双击缩放功能

- Anum Pinki英语至乌尔都语开源词典:23000词汇会话

- 三菱电机SLIMDIP智能功率模块在变频洗衣机的应用分析

- 用JavaScript实现的剪刀石头布游戏指南

- Node.js v12.22.1版发布 - 跨平台JavaScript环境新选择

- Infix修复发布:探索新的中缀处理方式

- 罕见疾病酶替代疗法药物非临床研究指导原则报告

- Node.js v10.20.0 版本发布,性能卓越的服务器端JavaScript

- hap-java-client:Java实现的HAP客户端库解析

- Shreyas Satish的GitHub博客自动化静态站点技术解析

- vtomole个人博客网站建设与维护经验分享

- MEAN.JS全栈解决方案:打造MongoDB、Express、AngularJS和Node.js应用

- 东南大学网络空间安全学院复试代码解析