优化与损失函数:深度学习入门关键

需积分: 9 38 浏览量

更新于2024-07-19

收藏 4.63MB PDF 举报

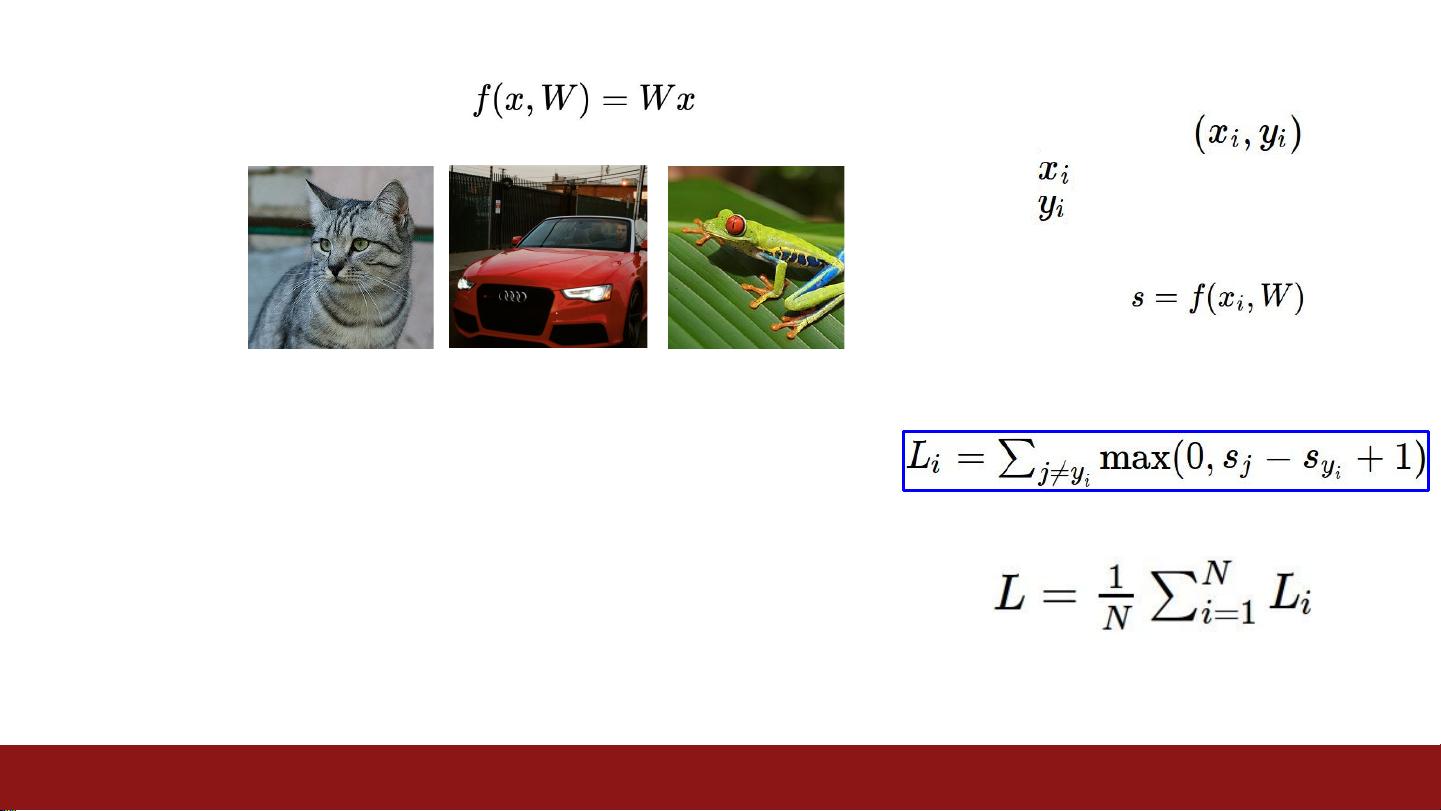

在《CS231n_2017_lecture3.pdf》的课程讲义中,主要探讨了深度学习中的关键概念——损失函数(Loss Functions)和优化方法(Optimization)。这些内容对于理解和实现机器学习模型至关重要,特别是对于计算机视觉和深度学习项目。

首先,损失函数被定义为误差项(loss term)和正则化项(regularization term)的组合。误差项衡量模型预测值与真实值之间的差异,常见的有均方误差(MSE)和交叉熵(Cross Entropy)等,它们帮助评估模型预测的准确性。正则化项则是为了防止过拟合,通过引入对模型复杂度的惩罚,如L1、L2正则化或权重衰减,来提升模型泛化能力。

课程介绍了几种常见的优化算法,如梯度下降法(Gradient Descent)、随机梯度下降(Stochastic Gradient Descent,SGD)、动量法(Momentum)、Nesterov动量(Nesterov Accelerated Gradient, NAG)以及更高级的优化器如Adam。理解这些优化方法有助于调整学习率、选择合适的更新策略,以达到最小化损失函数的目的。

此外,课程还提到了行政事务,包括作业1的发布、项目创意讨论区、办公室时间安排、TA的专业领域以及如何利用Google Cloud Credit。这些信息对于学生管理课程进度和获取额外支持非常重要。

值得注意的是,课程中还回顾了上一次课的内容,强调了图像识别中的挑战,如光照变化(illumination)、形状变形(deformation)、遮挡(occlusion)等问题,这些因素在实际应用中需要模型具备一定的鲁棒性来应对。

《CS231n_2017_lecture3.pdf》深入讲解了深度学习中的核心概念,旨在帮助学生掌握如何设计和训练准确且具有泛化能力的模型,同时关注于实际问题中的挑战和优化技术。这对于任何想要进入或进一步研究深度学习领域的学习者来说都是宝贵的知识资源。

2019-10-12 上传

2018-04-28 上传

2018-01-20 上传

2018-01-20 上传

2018-01-24 上传

2018-01-20 上传

2018-01-20 上传

2018-01-20 上传

ShawDa

- 粉丝: 50

- 资源: 17

最新资源

- 深入浅出:自定义 Grunt 任务的实践指南

- 网络物理突变工具的多点路径规划实现与分析

- multifeed: 实现多作者间的超核心共享与同步技术

- C++商品交易系统实习项目详细要求

- macOS系统Python模块whl包安装教程

- 掌握fullstackJS:构建React框架与快速开发应用

- React-Purify: 实现React组件纯净方法的工具介绍

- deck.js:构建现代HTML演示的JavaScript库

- nunn:现代C++17实现的机器学习库开源项目

- Python安装包 Acquisition-4.12-cp35-cp35m-win_amd64.whl.zip 使用说明

- Amaranthus-tuberculatus基因组分析脚本集

- Ubuntu 12.04下Realtek RTL8821AE驱动的向后移植指南

- 掌握Jest环境下的最新jsdom功能

- CAGI Toolkit:开源Asterisk PBX的AGI应用开发

- MyDropDemo: 体验QGraphicsView的拖放功能

- 远程FPGA平台上的Quartus II17.1 LCD色块闪烁现象解析